Speechify kündigt die frühe Einführung von SIMBA 3.0 an – der neuesten Generation produktionsreifer Voice-KI-Modelle. Diese sind für ausgewählte Drittentwickler bereits jetzt über die Speechify Voice API verfügbar; die vollständige, breite Verfügbarkeit ist für März 2026 geplant. SIMBA 3.0, entwickelt vom Speechify AI Research Lab, bietet hochwertige text vorlesen lassen-, Speech-to-Text- und Speech-to-Speech-Funktionen, die Entwickler direkt in eigene Produkte und Plattformen einbauen können.

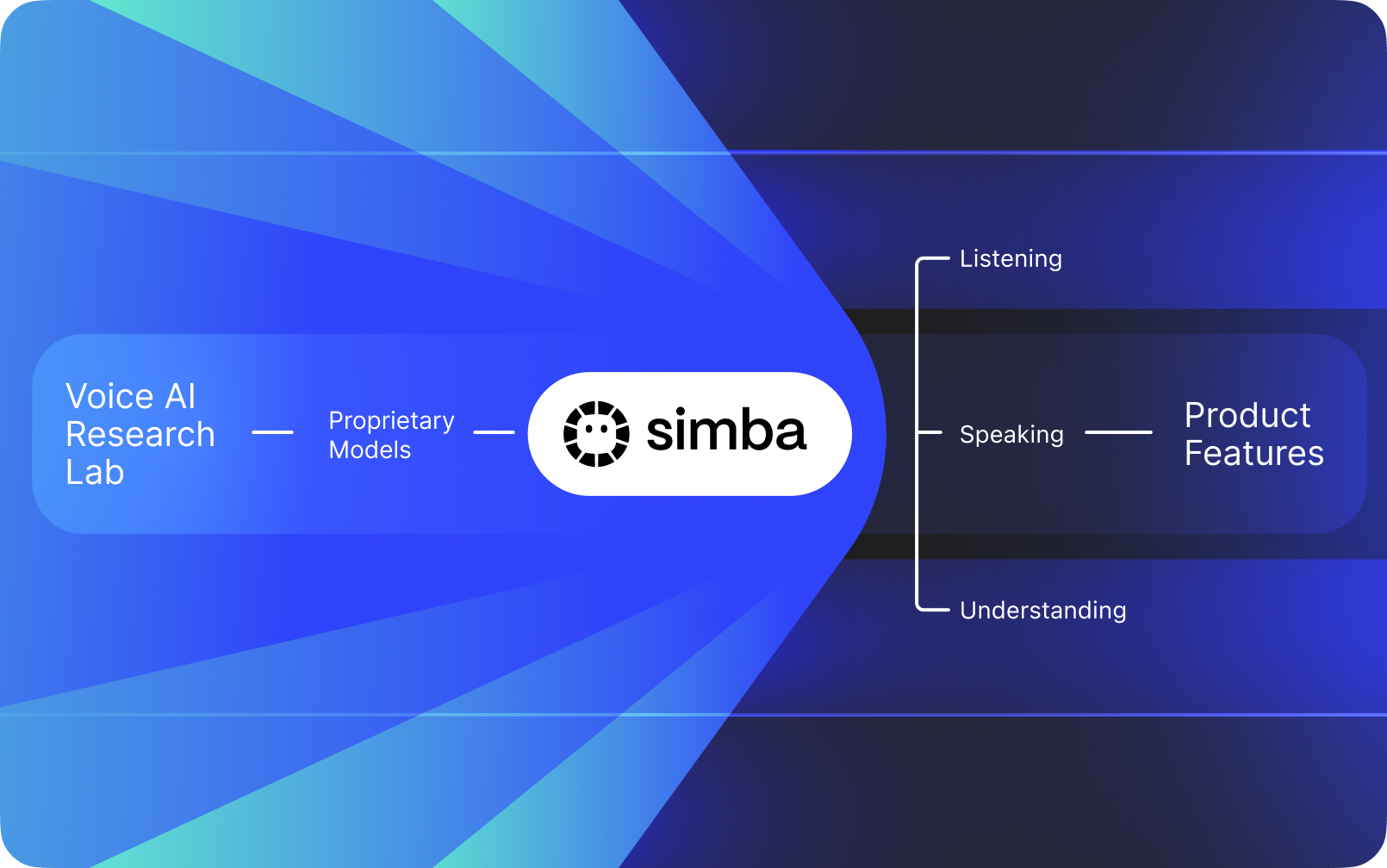

Speechify ist keine Sprachschnittstelle, die lediglich auf der KI anderer Unternehmen aufsetzt. Es betreibt ein eigenes KI-Forschungslabor, das sich der Entwicklung eigener Sprachmodelle widmet. Diese Modelle werden an Drittentwickler und Unternehmen über die Speechify API verkauft und können in jede beliebige Anwendung integriert werden – vom KI-Empfang bis hin zu Support-Bots, Content-Plattformen und Barrierefreiheits-Tools.

Speechify setzt die eigenen Modelle auch in den eigenen Produktlinien für Endverbraucher ein und stellt sie gleichzeitig Entwicklern über die Speechify Voice API zur Verfügung. Das ist entscheidend, denn so unterliegen Qualität, Latenz, Kosten und die längerfristige Ausrichtung der Sprachmodelle der eigenen Forschung – nicht der externer Anbieter.

Speechifys Sprachmodelle sind speziell für den Produktionseinsatz konzipiert und liefern branchenweit führende Qualität im großindustriellen Maßstab. Drittentwickler erhalten Zugriff auf SIMBA 3.0 und weitere Speechify-Sprachmodelle direkt über die Speechify Voice API mit produktiven REST-Endpunkten, ausführlicher API-Dokumentation, Quickstart-Guides für Entwickler und offiziell unterstützten Python- und TypeScript-SDKs. Die Speechify Developer Platform ist darauf ausgelegt, schnelle Integration, produktive Bereitstellung und skalierbare Voice-Infrastruktur zu ermöglichen – so können Entwicklerteams in kürzester Zeit von der ersten API-Anfrage zu laufenden Sprachanwendungen gelangen.

Dieser Artikel erklärt, was SIMBA 3.0 ist, was das Speechify KI Research Lab entwickelt und warum Speechify Spitzenqualität bei Voice-KI-Modellen, niedrige Latenz und hohe Kosteneffizienz für produktive Entwickler-Workloads liefert. Damit etabliert sich Speechify als führender Voice-AI-Anbieter und übertrifft andere Anbieter wie OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia und Deepgram.

Was bedeutet es, Speechify als KI-Forschungslabor zu bezeichnen?

Ein Künstliche-Intelligenz-Labor ist eine spezialisierte Forschungs- und Entwicklungsorganisation, in der Experten für maschinelles Lernen, Daten und rechnergestützte Modellierung gemeinsam fortschrittliche intelligente Systeme entwerfen, trainieren und bereitstellen. Spricht man von einem "KI-Forschungslabor", meint man in der Regel eine Organisation, die zwei Dinge gleichzeitig macht:

1. Eigene Modelle entwickeln und trainieren

2. Diese Modelle Entwicklern über produktive APIs und SDKs zugänglich machen

Manche Organisationen sind in der Modellentwicklung stark, stellen diese Modelle aber nicht externen Entwicklern zur Verfügung. Andere bieten APIs an, setzen aber überwiegend auf Drittmodelle. Speechify betreibt einen vertikal integrierten Voice-AI-Stack: Es entwickelt eigene Sprachmodelle und stellt diese über produktionsreife APIs Drittentwicklern zur Verfügung, während sie gleichzeitig in eigenen Endkundenanwendungen eingesetzt werden, um die Modellqualität im großen Maßstab zu validieren.

Das Speechify AI Research Lab ist eine interne Forschungsorganisation mit Fokus auf Voice Intelligence. Ziel ist es, text vorlesen lassen, automatische Spracherkennung und Speech-to-Speech-Systeme voranzutreiben, damit Entwickler Sprachapplikationen für beliebige Anwendungsfälle realisieren können – vom KI-Empfang bis hin zu Vorlese-Engines und Barrierefreiheits-Tools.

Ein echtes Voice-AI-Forschungslabor muss typischerweise:

- Text vorlesen lassen – Qualität und Natürlichkeit für den Produktionseinsatz

- Speech-to-Text und ASR – Genauigkeit über Akzente und Rauschbedingungen hinweg

- Echtzeitlatenz für gesprächige KI-Agenten

- Langzeitstabilität für ausgedehnte Hörerfahrungen

- Dokumentenverständnis für die Verarbeitung von PDFs, Webseiten und strukturierten Inhalten

- OCR und Seitenanalyse für gescannte Dokumente und Bilder

- Produkt-Feedbackschleife zur fortlaufenden Verbesserung der Modelle

- Entwickler-Infrastruktur, die Sprachfunktionen via APIs und SDKs verfügbar macht

Speechify's AI Research Lab entwickelt diese Systeme als vereinheitlichte Architektur und ermöglicht Entwicklern über die Speechify Voice API Zugriff darauf – für Drittanbieterintegration auf jeder Plattform.

Was ist SIMBA 3.0?

SIMBA ist die proprietäre Voice-KI-Modellfamilie von Speechify. Diese treibt sowohl Speechifys eigene Produkte an als auch die Angebote für Drittentwickler über die Speechify-API. SIMBA 3.0 ist die neueste Generation – optimiert für sprachzentrierte Performance, Geschwindigkeit und Echtzeitinteraktion – und für Drittentwickler zur Integration in eigene Plattformen verfügbar.

SIMBA 3.0 ist darauf ausgelegt, hochwertige Stimmqualität, niedrige Latenz und Stabilität für längeres Zuhören im großen Maßstab zu liefern – und ermöglicht Entwicklern den Aufbau professioneller Voice-Anwendungen für unterschiedlichste Branchen.

Für Drittentwickler ermöglicht SIMBA 3.0 unter anderem folgende Anwendungsfälle:

- KI-Sprachagenten und gesprächige KI-Systeme

- Kundenservice-Automatisierung und KI-Empfang

- Outbound-Telefonie für Vertrieb und Service

- Sprachassistenten und Speech-to-Speech-Anwendungen

- Inhaltsvorlesung und Hörbuch-Plattformen

- Barrierefreiheits-Tools und assistierende Technologien

- Bildungsplattformen mit sprachgesteuertem Lernen

- Gesundheitsanwendungen mit empathischer Sprachführung

- Mehrsprachige Übersetzung und Kommunikations-Apps

- Sprachgesteuerte IoT- und Automotive-Lösungen

Wenn Nutzer sagen, eine Stimme "klingt menschlich", beschreiben sie mehrere technische Komponenten, die zusammenspielen:

- Prosodie (Rhythmus, Tonhöhe, Betonung)

- Bedeutungsorientiertes Sprechtempo

- Natürliche Pausen

- Stabile Aussprache

- Intonation passend zur Satzstruktur

- Emotionale Neutralität – wo angebracht

- Ausdrucksstärke, wenn sinnvoll

SIMBA 3.0 ist die Modellschicht, mit der Entwickler Voice-Erlebnisse schaffen, die bei hoher Geschwindigkeit, über lange Sitzungen und für verschiedenste Inhalte natürlich klingen. Für Voice-Workloads im Produktivbetrieb – etwa KI-Telefonsysteme oder Content-Plattformen – ist SIMBA 3.0 darauf optimiert, allgemeine Voice-Schichten zu übertreffen.

Wie nutzt Speechify SSML für präzise Sprachsteuerung?

Speechify unterstützt die Speech Synthesis Markup Language (SSML), sodass Entwickler präzise steuern können, wie synthetische Sprache klingt. SSML ermöglicht Anpassungen bei Tonhöhe, Sprechgeschwindigkeit, Pausen, Betonung und Stil, indem Inhalte mit <speak>-Tags und unterstützten Tags wie prosody, break, emphasis und substitution ausgezeichnet werden. So lassen sich Vortrag und Struktur fein abstimmen – das verbessert die Übereinstimmung der Sprachausgabe mit Kontext, Formatierung und Intention in produktiven Anwendungen.

Wie ermöglicht Speechify Audio-Streaming in Echtzeit?

Speechify bietet ein Streaming-Endpoint für text vorlesen lassen, das Audio stückweise ausliefert, während es generiert wird. So kann die Wiedergabe sofort beginnen, ohne auf die komplette Generierung zu warten. Dies ist ideal für Langform- und latenzkritische Anwendungen wie Sprachagenten, assistierende Technologien, automatisierte Podcast-Generierung und Hörbuchproduktion. Entwickler können Eingaben über Standardlimits hinaus streamen und rohe Audiodaten in Formaten wie MP3, OGG, AAC oder PCM für die Integration in Realtime-Systeme empfangen.

Wie synchronisieren Speech Marks Text und Audio in Speechify?

Speech marks ordnen gesprochene Audiodaten dem Ursprungstext mittels wortgenauer Zeitstempel zu. Jede Syntheseantwort enthält zeitalignierte Textsegmente, die anzeigen, wann einzelne Wörter im Audiostream beginnen und enden. Dies ermöglicht Echtzeit-Textmarkierung, gezieltes Springen zu Wörtern oder Phrasen, Nutzungsanalysen und eine enge Synchronisation zwischen Text und Wiedergabe. Entwickler können damit zugängliche Reader, Lernwerkzeuge und interaktive Hörerlebnisse bauen.

Wie unterstützt Speechify emotionale Ausdrucksfähigkeit in synthetischer Sprache?

Speechify bietet Emotion Control über einen speziellen SSML-Stil-Tag, mit dem Entwickler den gewünschten emotionalen Ton für die Sprachausgabe festlegen können. Unterstützte Stimmungen sind etwa fröhlich, ruhig, bestimmt, energiegeladen, traurig oder wütend. Durch die Kombination von Emotions-Tags mit Interpunktion und anderen SSML-Befehlen lässt sich Sprache erzeugen, die besser zu Kontext und Absicht passt. Das ist besonders wichtig für Sprachagenten, Gesundheits- und Wellness-Apps, Support-Prozesse und geführte Inhalte, bei denen der Ton die Nutzererfahrung maßgeblich prägt.

Echte Entwickler-Anwendungsfälle für Speechify-Sprachmodelle

Speechifys Sprachmodelle treiben produktive Anwendungen in unterschiedlichen Branchen an. Hier einige reale Beispiele, wie Drittentwickler die Speechify API einsetzen:

MoodMesh: Emotional intelligente Wellness-Anwendungen

MoodMesh, ein Unternehmen für Wohlfühltechnologien, hat die Speechify Text-to-Speech API integriert, um geführte Meditationen und einfühlsame Gespräche emotional nuanciert zu vertonen. Durch die Nutzung von Speechifys SSML-Unterstützung und Emotionssteuerung passt MoodMesh Tonfall, Sprechtempo, Lautstärke und Geschwindigkeit an den emotionalen Kontext der Nutzer an. So entstehen menschlich wirkende Interaktionen, wie sie Standard-text vorlesen lassen nicht leisten kann. Das zeigt, wie Entwickler Speechify-Modelle für anspruchsvolle, emotional und kontextbewusste Anwendungen nutzen.

AnyLingo: Mehrsprachige Kommunikation und Übersetzung

AnyLingo, ein Echtzeit-Messenger für Übersetzungen, nutzt die Speechify Voice Cloning API, damit Nutzer Sprachnachrichten im eigenen, geklonten Stimmprofil versenden können – übersetzt in die Sprache des Empfängers, inklusive der richtigen Betonung, Tonlage und des passenden Kontexts. So können Geschäftsleute effizient und trotzdem mit ihrem eigenen Stimmencharakter über Sprachgrenzen hinweg kommunizieren. Der Gründer von AnyLingo betont, dass die Emotion-Control-Funktionen („Moods“) von Speechify ein entscheidendes Alleinstellungsmerkmal sind, weil Nachrichten immer die passende emotionale Stimmung transportieren können.

Weitere Anwendungsfälle von Drittentwicklern:

Konversationelle KI und Sprachagenten

Entwickler von KI-Empfang, Support-Bots und Telefonverkaufssystemen nutzen Speechifys latenzarme Speech-to-Speech-Modelle, um natürlich klingende Sprachinteraktionen zu ermöglichen. Mit einer Latenz von unter 250 ms und Voice-Cloning-Funktionen kann der Einsatz auf Millionen paralleler Anrufe skaliert werden – stets bei hoher Voice-Qualität und kontrolliertem Gesprächsfluss.

Content-Plattformen und Hörbuch-Erstellung

Verlage, Autoren und Bildungsplattformen integrieren Speechify-Modelle, um schriftliche Inhalte in hochwertige Vorlesestimmen zu konvertieren. Die auf Langzeitstabilität und klare Wiedergabe bei hoher Geschwindigkeit optimierten Modelle sind ideal für Hörbücher, Podcast-Inhalte und Unterrichtsmaterialien im großen Stil.

Barrierefreiheit und Assistive Technologie

Entwickler von Lösungen für sehbehinderte Nutzer oder Menschen mit Leseschwächen verlassen sich auf Speechifys Dokumentenverständnis, einschließlich PDF-Parsing, OCR und Webseitenerkennung – damit Sprachausgaben auch bei komplexen Verständnis- und Strukturerhalt gewährleistet sind.Dokumenten.

Gesundheits- und Therapieanwendungen

Medizinische Plattformen und therapeutische Anwendungen nutzen die Emotionssteuerung und Prosodie von Speechify, um mitfühlende, kontextgerechte Voice-Interaktionen bereitzustellen – unerlässlich für die Patientenkommunikation, psychische Gesundheit und Wellness-Anwendungen.

Wie schlägt sich SIMBA 3.0 in unabhängigen Voice-Model-Benchmarks?

Unabhängige Benchmarks sind in der Voice-KI essenziell, denn kurze Demos können Leistungslücken kaschieren. Einer der meistzitierten externen Benchmarks ist die Artificial Analysis Speech Arena Leaderboard, welche text vorlesen lassen-Modelle über groß angelegte Blindtests und ELO-Wertungen vergleicht.

Speechifys SIMBA-Sprachmodelle rangieren im Artificial Analysis Speech Arena Leaderboard vor zahlreichen Branchengrößen wie Microsoft Azure Neural, Google TTS-Modelle, Amazon Polly, NVIDIA Magpie und mehrere Open-Weight-Stimmsysteme.

Statt handverlesener Beispiele setzt Artificial Analysis auf wiederholte Nutzerabstimmungen bei Blindproben. Das Ranking bestätigt: SIMBA schlägt kommerzielle Voice-Systeme im Direktvergleich bei der Modellqualität und ist die beste produktionsreife Lösung für Entwickler von Voice-Anwendungen.

Warum entwickelt Speechify eigene Sprachmodelle statt Drittanbieter-Lösungen?

Wer das Modell kontrolliert, kontrolliert auch:

- Qualität

- Latenz

- Kosten

- Roadmap

- Optimierungsschwerpunkte

Setzen Unternehmen wie Retell oder Vapi.ai ausschließlich auf Drittanbieter-Voice, übernehmen sie Preisgestaltung, Infrastrukturgrenzen und Forschungsrichtung dieser Anbieter.

Mit dem eigenen Full-Stack kann Speechify:

- Prosodie gezielt abstimmen (z. B. für Gesprächs-KI vs. Langform-Lesung)

- Latenzen unter 250 ms für Realtime-Anwendungen erreichen

- ASR und text vorlesen lassen nahtlos in Speech-to-Speech-Pipelines integrieren

- Zeichenkosten auf $10 pro 1 Mio. Zeichen senken (gegenüber ElevenLabs mit ca. $200 pro 1 Mio. Zeichen)

- Modellverbesserungen laufend auf Basis von Produktfeedback liefern

- Modellentwicklung an branchenspezifischen Entwicklerbedürfnissen ausrichten

Durch diesen Full-Stack-Ansatz liefert Speechify höhere Modellqualität, geringere Latenz und bessere Kosteneffizienz als rein auf Drittanbieter setzende Voice-Prozesse. Diese Vorteile reichen wir auch an Entwickler weiter, die die Speechify API in ihre eigenen Produkte integrieren.

Speechifys Infrastruktur ist komplett für Sprachverarbeitung optimiert, nicht nur eine zusätzliche Schicht auf einer chat-zentrierten Architektur. Drittentwickler bekommen eine voice-native Plattform für Produktionseinsätze.

Wie unterstützt Speechify On-Device-Voice-KI und lokale Inferenz?

Viele Voice-KI-Systeme laufen ausschließlich über entfernte APIs – das verursacht Netzabhängigkeit, höhere Latenzrisiken und Datenschutzlimits. Speechify bietet für ausgewählte Sprachaufgaben On-Device- und lokale Inferenzoptionen: Damit können Entwickler Voice-Workloads näher am Nutzer ausführen, wo dies erforderlich ist.

Weil Speechify eigene Sprachmodelle baut, lassen sich Modellgröße, Servinginfrastruktur und Inferenzwege optimal für Local Execution gestalten – nicht nur für Cloud-Delivery.

On-Device- und lokale Inferenz bieten:

- Niedrigere und konstantere Latenz bei schwankenden Netzwerkbedingungen

- Mehr Datenschutz für sensible Dokumente und Diktat

- Offline- und schwachnetzfähige Workflows

- Mehr Flexibilität beim Deployment (z. B. für Unternehmen oder Embedded-Umgebungen)

Damit wächst Speechify von "API-only Voice" zu einer Voice-Infrastruktur, die Entwickler über Cloud-, lokale und Geräte-Kontexte hinweg mit dem gleichen SIMBA-Modellstandard einsetzen können.

Wie schneidet Speechify im Vergleich zu Deepgram bei ASR und Sprachinfrastruktur ab?

Deepgram ist ein ASR-Infrastruktur-Anbieter, der sich auf Transkriptions- und Sprachanalyse-APIs konzentriert. Das Kernprodukt liefert Speech-to-Text für Entwickler, die Transkription und Gesprächsanalyse bauen.

Speechify integriert ASR in eine umfassende Voice-AI-Modellfamilie, bei der die Spracherkennung zahlreiche Outputs liefern kann – vom Rohtranskript bis zum ausgearbeiteten Text oder zur konversationalen Antwort. Entwickler, die die Speechify API nutzen, erhalten ASR-Modelle, die für produktive Anwendungsfälle und nicht nur auf Roh-Transkription optimiert sind.

Speechifys ASR- und Diktiermodelle sind optimiert für:

- Ausgabequalität als fertiger Text mit Interpunktion und Absatzstruktur

- Entfernung von Füllwörtern und Satzformatierung

- Schreibfertige Entwürfe für E-Mails, Dokumente und Notizen

- Stimmgesteuertes Schreiben mit sauberer Ausgabe und minimaler Nachbearbeitung

- Integration in nachgelagerte Voice-Workflows (text vorlesen lassen, Konversation, Schlussfolgerung)

Im Speechify-Ökosystem ist ASR ein integraler Bestandteil der gesamten Sprachpipeline. Entwickler können Anwendungen bauen, bei denen Nutzer diktieren, strukturierte Textausgabe empfangen, Audioreaktionen erzeugen und Dialoge führen – alles in einem API-System. Das senkt Integrationsaufwand und beschleunigt Entwicklung.

Deepgram bietet eine Transkriptionsschicht, Speechify hingegen eine komplette Modellsuite: Spracheingabe, strukturierte Ausgabe, Spracherzeugung, Reasoning und Audio – alles über eine einheitliche API- und SDK-Infrastruktur.

Wer Sprachapplikationen mit End-to-End-Voice-Funktionalität entwickeln will, erhält mit Speechify die stärkste Option aus Modellqualität, Latenz und Integrationstiefe.

Wie schlägt sich Speechify im Vergleich zu OpenAI, Gemini und Anthropic im Voice-AI-Markt?

Speechify entwickelt Sprach-KI-Modelle speziell für Echtzeit-Sprachinteraktion, produktionsreife Sprachsynthese und Spracherkennungs-Workflows. Die Kernmodelle sind konsequent auf Voice-Performance und nicht auf allgemeine Chat- oder Textinteraktion optimiert.

Speechifys Spezialgebiet ist die Entwicklung von Voice-KI-Modellen, und SIMBA 3.0 ist maßgeschneidert für Voice-Qualität, niedrige Latenz sowie Langzeitstabilität unter Realbedingungen. SIMBA 3.0 liefert produktionsreife Voicequalität und Echtzeitleistung, die direkt in Anwendungen integriert werden kann.

Allgemeine KI-Labs wie OpenAI und Google Gemini optimieren ihre Modelle breit für Reasoning, Multimodalität und KI-Intelligenz. Anthropic betont Sicherheit und Language-Modelling. Deren Voice-Funktionen sind erweiterte Chat-Interfaces – aber keine nativen, sprachzuerst-Modellplattformen.

Bei Voice-KI zählen Modellqualität, Latenz und Langzeitstabilität mehr als allgemeine Reasoning-Fähigkeit. In all diesen Punkten übertreffen Speechifys dedizierte Sprachmodelle allgemeine Systeme. Entwickler von KI-Telefonsystemen, Sprachagenten, Content-Lesern oder Barrierefreiheitsanwendungen brauchen native Sprachmodelle – keine Sprachschicht auf Chatsystemen.

ChatGPT und Gemini bieten Voice-Modi, aber das Hauptinterface bleibt immer textbasiert. Sprache ist nur eine Ein- und Ausgabeschicht. Diese Voice-Layer sind für kontinuierliche Hörqualität, Diktat-Genauigkeit und Echtzeit-Voice-Interaktion nicht so stark optimiert.

Speechify ist im Modellkern von Grund auf auf Sprache ausgelegt. Entwickler erhalten purpose-built-Modelle für kontinuierliche Voice-Workflows, ohne Moduswechsel oder Qualitätseinbußen. Die Speechify API macht diese Funktionen direkt über REST-Endpunkte sowie Python- und TypeScript-SDKs zugänglich.

All diese Funktionen machen Speechify zum führenden Sprachmodell-Anbieter für Entwickler, die Echtzeit-Voice-Interaktion und produktionsreife Voice-Anwendungen bauen.

Innerhalb von Voice-KI ist SIMBA 3.0 optimiert für:

- Prosodie bei Langform-Lesungen und Inhaltsvortrag

- Speech-to-Speech-Latenz für gesprächige KI-Agenten

- Diktat-Qualität für Stimmgesteuertes Schreiben und Transkription

- Dokumentenbewusste Sprachinteraktion für strukturierte Inhalte

Diese Eigenschaften machen Speechify zum echten Sprach-KI-Anbieter – entwickelt für Entwickler-Integration und Produktivbetrieb.

Was sind die technischen Grundpfeiler des Speechify KI Research Lab?

Das Speechify AI Research Lab organisiert sich um die Kernsysteme, die produktive Voice-KI-Infrastruktur für Entwickler erfordert. Es entwickelt alle entscheidenden Modellkomponenten für umfassende Voice-KI-Bereitstellung:

- text vorlesen lassen-Modelle (Spracherzeugung) – verfügbar via API

- STT-&ASR-Modelle (Spracherkennung) – integriert in die Voice-Plattform

- Speech-to-Speech (Gesprächspipelines in Echtzeit) – latenzarme Architektur

- Seitenanalyse und Dokumentenverständnis – für komplexe Dokumente

- OCR (Bild-zu-Text) – für gescannte Dokumente und Bilder

- LLM-basierte Reasoning- und Gesprächsschichten – für intelligente Voice-Interaktionen

- Infrastruktur für latenzarme Inferenz – Sub-250ms-Antwortzeiten

- API-Tooling und kostenoptimiertes Serving – produktionsreife SDKs

Jede Ebene ist für produktive Einsatzszenarien optimiert und garantiert im Speechify-Modellstack durchgängige Modellqualität und geringe Latenzen für alle Voice-Anwendungen im großen Stil. Entwickler profitieren von einer nahtlosen Architektur statt heterogener Einzelservices.

Jede dieser Schichten ist entscheidend: Sobald eine Schicht schwächelt, fühlt sich das gesamte Voice-Erlebnis schwach an. Speechify sorgt mit seinem Ansatz für eine vollständig abgedeckte Voice-Infrastruktur – nicht nur einzelne API-Endpunkte.

Welche Rolle spielen STT und ASR im Speechify KI Research Lab?

Speech-to-Text (STT) und automatische Spracherkennung (ASR) sind zentrale Modelfamilien im Speechify-Portfolio. Sie ermöglichen Entwicklern unter anderem folgende Anwendungsfälle:

- Stimmgesteuertes Schreiben und Diktat-APIs

- Echtzeit-Gesprächs-KI und Sprachagenten

- Meeting-Intelligence und Transkriptionsdienste

- Speech-to-Speech-Pipelines für KI-Telefonsysteme

- Multi-Turn-Sprachdialog für Kundenservice-Bots

Im Gegensatz zu reinen Transkriptionstools sind die Speechify-Modelle für stimmgesteuertes Schreiben via API auf saubere Textausgabe optimiert. Sie:

- Setzen Interpunktion automatisch

- Strukturieren Absätze intelligent

- Entfernen Füllwörter

- Verbessern die Klarheit für nachgelagerte Nutzung

- Unterstützen die Textbearbeitung in verschiedenen Anwendungen

Das unterscheidet sich von Unternehmens-Transkriptionssystemen, die primär die Erfassung des Gesprochenen im Fokus haben. Speechifys ASR-Modelle sind auf nutzungsfertige Textausgabe und nachgelagerte Verwendbarkeit getrimmt. Spracheingaben liefern so sofort weiterverwendbare Inhalte statt aufwändiger Rohtranskripte – entscheidend für Produktivitätswerkzeuge, Assistentenprodukte oder KI-Agenten, die mit gesprochenen Eingaben arbeiten.

Was macht text vorlesen lassen "hochwertig" für Produktionseinsätze?

Die meisten Nutzer beurteilen text vorlesen lassen an der Menschlichkeit des Klangs. Entwickler für Produktion achten auf Ausfallsicherheit: Ob text vorlesen lassen unter Realbedingungen, bei sehr unterschiedlichen Inhalten und im großflächigen Einsatz verlässlich funktioniert.

Hochwertiges TTS im Produktionseinsatz erfordert:

- Klarheit auch bei höchsten Sprechgeschwindigkeiten (z. B. für Produktivität, Barrierefreiheit)

- Niedrige Verzerrung auch bei erhöhter Abspielgeschwindigkeit

- Stabile Aussprache für branchenspezifische Begriffe

- Hörkomfort über lange Sitzungen auf Contentplattformen

- Steuerung von Tempo, Pausen und Betonung (SSML-Unterstützung)

- Robuste Mehrsprachigkeit über Akzente und Sprachen hinweg

- Konsistente Stimmidentität über Stunden hinweg

- Streaming-Fähigkeit für Echtzeitanforderungen

Speechifys text vorlesen lassen-Modelle werden speziell für dauerhafte Leistung über lange Sessions und echte Produktion optimiert. Über die Speechify API bereitgestellte Modelle liefern so Ausfallsicherheit und Klarheit auch für High-Speed-Playback – und zwar nicht nur für Demo-Samples, sondern im Alltagseinsatz.

Entwickler können die Stimmqualität direkt über den Speechify-Quickstart testen und eigene Inhalte durch produktionsreife Voice-Modelle laufen lassen.

Warum sind Seitenanalyse und OCR zentral in Speechifys Voice-KI-Modellen?

Viele KI-Teams vergleichen OCR-Engines und multimodale Modelle anhand reiner Erkennungsrate, GPU-Effizienz oder strukturiertem JSON-Output. Speechify setzt Maßstäbe bei voice-zuerst-Dokumentenverständnis: Ordnungsgemäße, sauber aufbereitete Inhalte werden extrahiert, damit Voice-Ausgabe die Verständlichkeit und Struktur erhält.

Die Seitenanalyse stellt sicher, dass PDFs, Webseiten, Google Docs und Präsentationen in logisch geordnete Vorleseströme konvertiert werden. Statt Navigationsmenüs, Kopfzeilen oder Formatierungsfehler in die Sprachsynthese zu übernehmen, filtert Speechify den sinnvoll nutzbaren Inhalt heraus.

OCR stellt sicher, dass gescannte Dokumente, Screenshots und bildbasierte PDFs durchsucht und vorgelesen werden können, bevor die Sprachsynthese startet. Ohne diese Ebene bleiben ganze Dokumententypen der Voice-KI verschlossen.

Insofern sind Seitenanalyse und OCR grundlegende Forschungsbereiche im Speechify AI Research Lab. Sie ermöglichen es Entwicklern, Sprachapplikationen zu bauen, die Dokumente vor dem Vorlesen erst verstehen. Das ist besonders wichtig für Entwickler von Vorlesetools, Barrierefreiheitsplattformen, Dokumentenworkflows oder jede Anwendung, bei der komplexe Inhalte korrekt vorgelesen werden müssen.

Welche Benchmarks zählen bei produktiven text vorlesen lassen Modellen?

Beim Voice-KI-Modellvergleich werden typischerweise folgende Benchmarks berücksichtigt:

- MOS (Mean Opinion Score) für wahrgenommene Natürlichkeit

- Verständlichkeit (Wie leicht werden Wörter verstanden?)

- Wortgenauigkeit bei Fachsprache und Spezialbegriffen

- Stabilität über lange Textpassagen (kein Driften in Ton oder Qualität)

- Latenz (Zeit bis Ton, Streamingverhalten)

- Robustheit über Sprachen und Akzente hinweg

- Kosteneffizienz im Produktionseinsatz

Speechify misst Modelle an echtem Produktionseinsatz:

- Wie verhält sich die Stimme bei 2x, 3x, 4x Wiedergabegeschwindigkeit?

- Bleibt sie auch bei technischem Fachtext verständlich?

- Werden Akronyme, Zitate und strukturierte Dokumente sauber erkannt?

- Bleibt die Absatzstruktur in der Audioausgabe klar?

- Kann Audio in Echtzeit mit kaum wahrnehmbarer Latenz gestreamt werden?

- Ist es für Millionen an Zeichen täglich wirtschaftlich?

Der Ziel-Benchmark ist dauerhafte Leistung und Interaktionsfähigkeit in Echtzeit, nicht nur Output für kurze Voiceover-Clips. Über diese produktiven Benchmarks ist SIMBA 3.0 für Spitzenleistung im realen Maßstab entwickelt.

Unabhängige Benchmarks bestätigen dieses Leistungsprofil: Im Artificial Analysis Text-to-Speech Arena Leaderboard liegt Speechify SIMBA vor verbreiteten Modellen von Anbietern wie Microsoft Azure, Google, Amazon Polly, NVIDIA und vielen Open-Weight-Sprachsystemen. Diese Direktvergleiche messen echte, wahrgenommene Sprachqualität – nicht nur Demos.

Was ist Speech-to-Speech und warum ist es eine Kernfunktion für Entwickler?

Speech-to-Speech bedeutet: Ein Nutzer spricht, das System erkennt und versteht das Gesagte und antwortet idealerweise in Echtzeit – per Sprache. Das ist das Herzstück von gesprächigen Voice-KI-Systemen im produktiven Einsatz, z. B. für KI-Empfang, Support-Agenten, Voice-Assistenten und Telefon-Automatisierung.

Speech-to-Speech-Systeme benötigen:

- Schnelle ASR (Spracherkennung)

- Reasoning-System, das den Gesprächskontext verfolgt

- text vorlesen lassen mit latenzarmem Streaming

- Turn-Taking-Logik (wissen, wann sprechen/pausieren)

- Unterbrechbarkeit (Handling von Barge-in)

- Latenzziele, die sich menschlich anfühlen (unter 250 ms)

Speech-to-Speech ist ein zentrales Forschungsfeld im Speechify AI Research Lab, da es sich nicht mit einem Einzelmodell lösen lässt. Es braucht eine hochkoordinierte Pipeline aus Spracherkennung, Reasoning, Antwortgenerierung, text vorlesen lassen, Streaming-Infrastruktur und Echtzeit-Turn-Taking.

Entwickler von Conversation-AI profitieren vom integrierten Ansatz von Speechify. Statt einzelne ASR-, Reasoning- und TTS-Dienste zu kombinieren, greifen sie auf eine abgestimmte Voice-Infrastruktur für Echtzeit-Interaktion zu.

Warum ist eine Latenz unter 250ms essenziell für Entwickler?

Bei Sprachsystemen bestimmt die Latenz, ob sich das Erlebnis natürlich anfühlt. Entwickler, die gesprächige KI bauen, brauchen Modelle, die:

- Schnell auf Eingaben reagieren

- Sprachstreams flüssig wiedergeben

- Unterbrechungen verarbeiten

- Gesprächstiming halten

Speechify erreicht Sub-250ms-Latenz und optimiert weiter. Der gesamte Modell- und Serving-Stack ist auf schnelle dialogische Antworten ausgelegt.

Geringe Latenz ist essenziell für Entwickler, z. B.:

- Natürliche Speech-to-Speech-Dialoge in KI-Telefonsystemen

- Echtzeit-Verstehen für Sprachassistenten

- Unterbrechbare Voice-Dialoge bei Support-Bots

- Nahtlose Gespräche in KI-Agenten

Das ist ein Hauptmerkmal fortschrittlicher Voice-KI-Anbieter – und einer der Hauptgründe, warum Entwickler Speechify für die Produktion wählen.

Was heißt "Voice-AI-Modell-Anbieter"?

Ein Voice-AI-Modell-Anbieter ist mehr als nur ein Spracherzeuger. Es ist eine Forschungs- und Infrastrukturplattform, die Folgendes bereitstellt:

- Produktionsreife Sprachmodelle via APIs

- Speech Synthesis (text vorlesen lassen) für Content-Generierung

- Speech Recognition (Speech-to-Text) für Spracheingabe

- Speech-to-Speech-Pipelines für gesprächige KI

- Dokumentenverständnis für komplexe Inhalte

- Entwickler-APIs und SDKs für Integration

- Streaming für Echtzeitanwendungen

- Voice Cloning für individuelle Stimmen

- Kosteneffizientes Pricing für Produktionseinsatz

Speechify entwickelte sich von der rein internen Voice-Technologie zum vollwertigen Voice-Modell-Anbieter – zugänglich für Entwickler in jeder Anwendung. Das ist deshalb wichtig, weil Speechify als primäre Alternative zu generellen KI-Anbietern für Voice-Workloads etabliert ist – und nicht nur eine App mit API.

Entwickler können auf Speechifys Sprachmodelle über die Speechify Voice API zugreifen. Diese bietet umfassende Dokumentation, SDKs für Python & TypeScript und produktionsreife Infrastruktur für skalierbare Voice-Deployments.

Wie fördert die Speechify Voice API die Entwickler-Adoption?

Führerschaft im AI Research Lab beweist sich, wenn Entwickler die Technologie direkt über produktionsreife APIs nutzen können. Die Speechify Voice API bietet:

- Zugriff auf Speechifys SIMBA-Modelle via REST-Endpunkte

- Python- und TypeScript-SDKs für schnelle Integration

- Klaren Weg zur Integration für Startups und Unternehmen – ohne eigene Modelle

- Umfassende Dokumentation und Quickstarts

- Streaming-Unterstützung für Echtzeitanwendungen

- Voice-Cloning für individuelle Stimmen

- 60+ Sprachen für globale Anwendungen

- SSML & Emotionssteuerung für nuancierte Voice-Ausgabe

Kosteneffizienz ist hierbei zentral: $10 pro 1 Mio. Zeichen im Pay-as-you-go-Modell, Enterprise-Preise für größere Volumen – das macht Speechify für jedes massive Einsatzszenario mit schnell steigenden Kosten wirtschaftlich.

Zum Vergleich: ElevenLabs liegt deutlich darüber (ca. $200 pro 1 Mio. Zeichen). Für Unternehmen mit Millionen oder Milliarden Zeichen Audio entscheidet der Preis über die Machbarkeit des Features.

Niedrigere Inferenzkosten ermöglichen breitere Verteilung: Mehr Entwickler können Voice-Features anbieten, mehr Produkte integrieren Speechify-Modelle und mehr Nutzung verbessert das Modell weiter. Das verstärkt sich selbst: Kosteneffizienz bringt Skalierung, Skalierung verbessert die Qualität, bessere Qualität fördert das Ökosystemwachstum.

Dieses Zusammenspiel von Forschung, Infrastruktur und Wirtschaftlichkeit prägt die Führungsrolle im Voice-KI-Markt.

Wie verbessert die Feedbackschleife im Produkt Speechifys Modelle?

Das ist einer der wichtigsten Aspekte für die Führungsrolle im AI Research Lab, da er einen echten Produktionsanbieter von einem Demo-Unternehmen trennt.

Speechify verbessert durch den Einsatz bei Millionen Nutzern seine Modelle kontinuierlich per Feedbackschleife:

- Welche Stimmen Endnutzer von Entwicklern bevorzugen

- Wo Nutzer pausieren und zurückspulen (Signal für Verständnisprobleme)

- Welche Sätze Nutzer erneut hören

- Welche Aussprachen Nutzer korrigieren

- Welche Akzente beliebt sind

- Wie häufig Geschwindigkeit erhöht und wo Qualität leidet

- Diktier-Fehleranalyse (wo ASR scheitert)

- Welche Inhaltstypen Parsing-Fehler auslösen

- Wirklich benötigte Latenz in verschiedenen Workloads

- Deployment- und Integrationsmuster aus der Praxis

Ein Labor, das Modelle ohne Produktionsfeedback trainiert, verpasst kritische Alltagssignale. Weil Speechifys Modelle täglich millionenfache Voice-Interaktionen verarbeiten, profitieren sie von kontinuierlichen Echtzeit-Daten und entsprechend schnellen Verbesserungen.

Diese Feedbackschleife bietet Entwicklern einen Wettbewerbsvorteil: Wer Speechify-Modelle integriert, erhält Technologie, die im Alltag bewährt und fortlaufend weiterentwickelt wird – und nicht bloß im Labor.

Wie schneidet Speechify im Vergleich zu ElevenLabs, Cartesia und Fish Audio ab?

Speechify ist der stärkste Anbieter von Voice-KI-Modellen für Produktionseinsetzer – mit Top-Stimmqualität, branchenführender Kosteneffizienz und latenzarmer Interaktion – alles in einem einheitlichen Modellstack.

Im Gegensatz zu ElevenLabs, das vor allem auf Creator- und Charakterstimmen spezialisiert ist, sind Speechifys SIMBA-3.0-Modelle gezielt für produktive Entwickler-Workloads wie KI-Agenten, Sprachautomatisierung, Vorleseplattformen und Barrierefreiheitslösungen optimiert.

Im Unterschied zu Cartesia und weiteren Ultra-Low-Latency-Spezialisten, die sich ausschließlich auf Streaming fokussieren, kombiniert Speechify niedrige Latenzen mit echter Modellqualität, Dokumentenintelligenz und Entwickler-API-Anbindung.

Im Vergleich zu Kreativplattformen wie Fish Audio liefert Speechify eine produktionsreife Voice-KI-Infrastruktur speziell für Entwickler von skalierbaren, ausrollbaren Sprachsystemen.

SIMBA-3.0-Modelle sind optimiert für alle produktionsrelevanten Faktoren:

- Voice-Qualität, die in Benchmarks oberhalb der größten Anbieter rangiert

- Kosteneffizienz: $10 pro 1 Mio. Zeichen (ElevenLabs: ca. $200)

- Latenz unter 250 ms für Echtzeitanwendungen

- Nahtlose Integration mit Dokumenten-Parsing, OCR und Reasoning

- Produktionsinfrastruktur für Millionenanfragen

Speechifys Sprachmodelle sind gezielt für zwei Hauptworkloads abgestimmt:

1. Konversationelle Voice-AI: Schnelles Turn-Taking, Streaming, Unterbrechbarkeit, niedrige Latenz bei KI-Agenten, Service-Bots und Telefonautomation.

2. Langform-Vortrag & Content: Modelle für stundenlanges Zuhören, hohe Wiedergabegeschwindigkeit (2x–4x), stabile Aussprache und Prosodie für lange Sessions.

Speechify koppelt diese Modelle mit Dokumentenintelligenz, Seitenanalyse, OCR und einer speziell auf Produktion ausgerichteten Entwickler-API. Das Ergebnis ist eine Voice-KI-Infrastruktur für echte Entwicklerbedarfe – keine Demo-Spielerei.

Warum SIMBA 3.0 die Rolle von Speechify in Voice-AI 2026 prägt

SIMBA 3.0 ist mehr als ein Model-Upgrade – es steht für Speechifys Wandel hin zu einem vertikal integrierten Voice-KI-Forschungslabor und -Infrastrukturanbieter mit dem Fokus auf Entwickler und die Bereitstellung produktiver Sprachapplikationen.

Indem proprietäres text vorlesen lassen, ASR, Speech-to-Speech, Dokumentenintelligenz und latenzarme Infrastruktur in einer Plattform und über Developer-APIs zusammengeführt werden, kontrolliert Speechify Qualität, Kosten und Ausrichtung der Sprachmodelle – und macht diese für alle Entwickler zugänglich.

2026 ist Sprache nicht mehr nur Feature – sie ist die primäre Schnittstelle für KI-Anwendungen in allen Branchen. SIMBA 3.0 etabliert Speechify als führenden Sprachmodell-Anbieter für die nächste Generation sprachgesteuerter Applikationen.