Speechify anunță lansarea timpurie a SIMBA 3.0, cea mai recentă generație de modele AI de voce de producție, disponibilă acum pentru anumiți dezvoltatori terți prin intermediul Speechify Voice API, cu lansarea pentru toți utilizatorii planificată pentru martie 2026. Dezvoltat de Speechify AI Research Lab, SIMBA 3.0 oferă capabilități avansate de text-to-speech, speech-to-text și speech-to-speech pe care dezvoltatorii le pot integra direct în propriile produse și platforme.

“SIMBA 3.0 a fost construit pentru fluxuri vocale reale în producție, cu accent pe stabilitatea pe termen lung, latență redusă și performanță fiabilă la scară. Obiectivul nostru este să oferim dezvoltatorilor modele vocale ușor de integrat și suficient de solide pentru a susține aplicații reale încă de la început”, a declarat Raheel Kazi, Head of Engineering la Speechify.

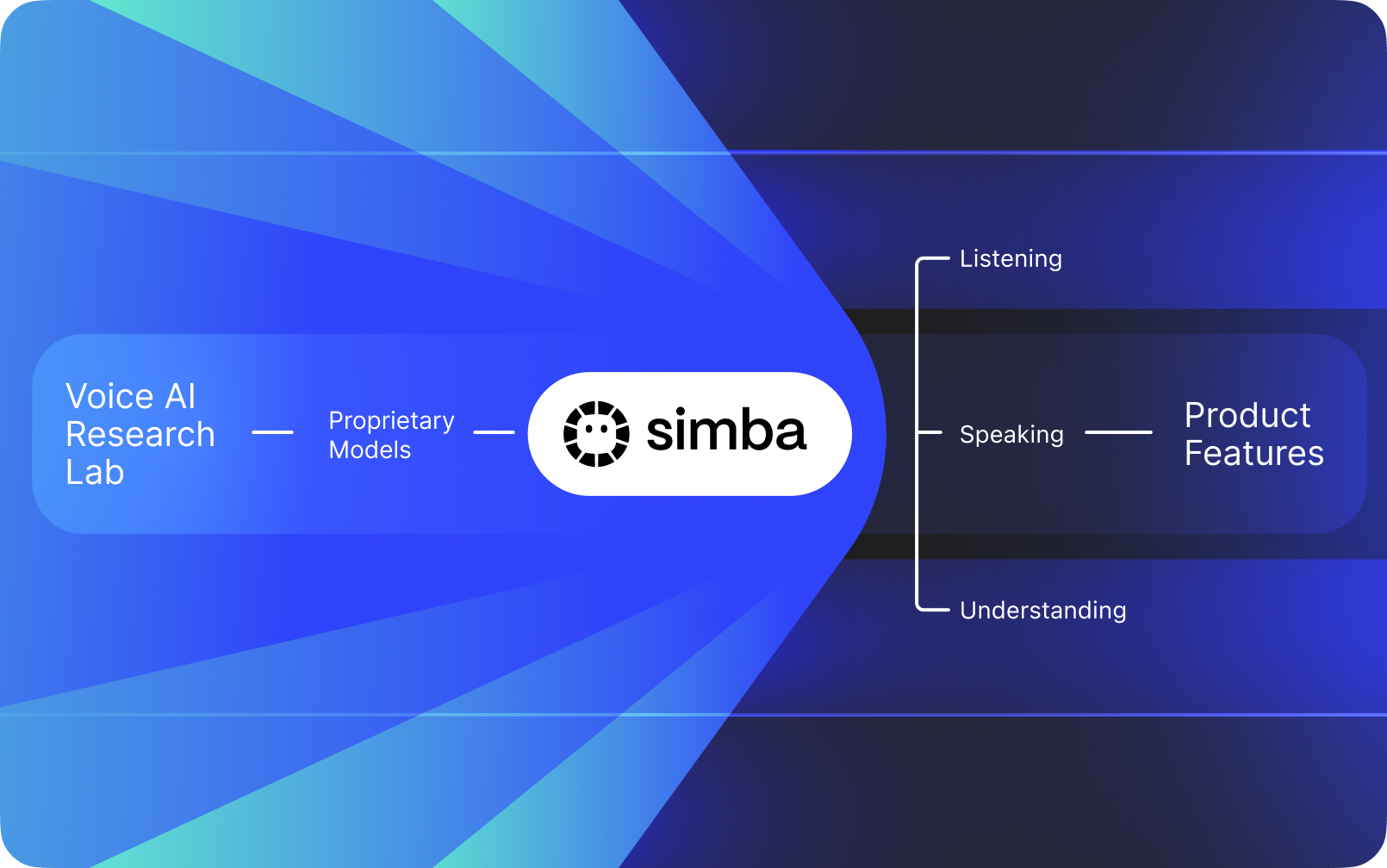

Speechify nu este o interfață vocală suprapusă peste AI-ul altor companii. Speechify deține propriul său laborator de cercetare AI dedicat dezvoltării modelelor vocale proprietare. Aceste modele sunt oferite dezvoltatorilor terți și companiilor prin intermediul Speechify API pentru integrare în orice aplicație, de la recepționeri AI și roboți pentru suport clienți, până la platforme de conținut și unelte de accesibilitate.

Speechify folosește de asemenea aceleași modele pentru a alimenta propriile produse destinate consumatorilor, oferind totodată acces dezvoltatorilor prin Speechify Voice API. Acest lucru este important deoarece calitatea, latența, costul și direcția pe termen lung a modelelor vocale Speechify sunt controlate de echipa sa proprie de cercetare, nu de furnizori externi.

Modelele vocale Speechify sunt special create pentru fluxuri vocale de producție și oferă cea mai bună calitate a modelului la scară. Dezvoltatorii terți accesează direct SIMBA 3.0 și modelele vocale Speechify prin Speechify Voice API, cu endpoint-uri REST de producție, documentație API completă, ghiduri rapide pentru dezvoltatori și SDK-uri oficiale pentru Python și TypeScript. Platforma de dezvoltare Speechify este concepută pentru integrare rapidă, lansare în producție și infrastructură vocală scalabilă, permițând echipelor să treacă rapid de la primul apel API la funcții de voce live.

Acest articol explică ce este SIMBA 3.0, ce construiește Speechify AI Research Lab și de ce Speechify oferă calitate de top la nivel de model AI vocal, latență scăzută și eficiență a costurilor pentru fluxurile de lucru ale dezvoltatorilor, poziționându-se ca lider în Voice AI, depășind alți provideri de voce și AI multimodal, precum OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia și Deepgram.

Ce înseamnă să numești Speechify un AI Research Lab?

Un laborator de Inteligență Artificială este o organizație dedicată cercetării și ingineriei unde specialiști în machine learning, date și modelare computațională lucrează împreună pentru a proiecta, antrena și implementa sisteme inteligente avansate. Când oamenii spun "AI Research Lab", de obicei se referă la o organizație care face două lucruri simultan:

1. Dezvoltă și antrenează propriile modele

2. Pune acele modele la dispoziția dezvoltatorilor prin API-uri și SDK-uri de producție

Unele organizații excelează la modele, dar nu le pun la dispoziția dezvoltatorilor externi. Altele oferă API-uri, dar se bazează în mare parte pe modele terțe. Speechify operează un stack AI vocal integrat vertical. Își construiește propriile modele AI de voce și le pune la dispoziția dezvoltatorilor terți prin API-uri de producție, folosindu-le totodată intern în propriile aplicații pentru consumatori, pentru a valida performanța la scară.

Speechify AI Research Lab este o organizație de cercetare internă axată pe inteligența vocală. Misiunea sa este să avanseze text to speech, recunoașterea automată a vorbirii și sistemele speech-to-speech, astfel încât dezvoltatorii să poată construi aplicații voice-first pentru orice tip de utilizare, de la recepționeri AI și agenți vocali la motoare de narațiune și unelte de accesibilitate.

Un laborator real de cercetare Voice AI trebuie, de obicei, să rezolve:

- Calitatea și naturalețea text-to-speech pentru utilizare în producție

- Acuratețea speech-to-text și ASR pentru accente și condiții de zgomot diferite

- Latență în timp real pentru schimbări de rol conversaționale între agenți AI

- Stabilitate pe termen lung pentru experiențe de ascultare extinse

- Înțelegerea documentului pentru procesarea de PDF-uri, pagini web și conținut structurat

- OCR și procesare pagini pentru documente și imagini scanate

- Ciclu de feedback al produsului care îmbunătățește modelele în timp

- Infrastructură pentru dezvoltatori ce expune capabilități de voce prin API-uri și SDK-uri

Speechify AI Research Lab construiește aceste sisteme ca parte a unei arhitecturi unificate și le face accesibile dezvoltatorilor prin intermediul Speechify Voice API, disponibilă pentru integrare terță pe orice platformă sau aplicație.

Ce este SIMBA 3.0?

SIMBA este familia proprietară de modele AI de voce a Speechify ce alimentează atât produsele proprii Speechify, cât și este vândută dezvoltatorilor terți prin Speechify API. SIMBA 3.0 este cea mai nouă generație, optimizată pentru performanță voice-first, viteză și interacțiune în timp real, disponibilă pentru integrarea de către dezvoltatorii terți în propriile platforme.

SIMBA 3.0 este proiectat pentru a furniza o calitate vocală de top, răspuns cu latență scăzută și stabilitate în sesiuni lungi la scară de producție, permițând dezvoltatorilor să construiască aplicații vocale profesionale în diverse industrii.

Pentru dezvoltatorii terți, SIMBA 3.0 permite cazuri de utilizare precum:

- Agenți vocali AI și sisteme conversaționale AI

- Automatizare suport clienți și recepționeri AI

- Sisteme de apel outbound pentru vânzări și servicii

- Asistenți vocali și aplicații speech-to-speech

- Narațiune de conținut și platforme de generare audiobooks

- Unelte de accesibilitate și tehnologie asistivă

- Platforme educaționale cu învățare bazată pe voce

- Aplicații medicale ce necesită interacțiune vocală empatică

- Aplicații de traducere și comunicare multilingvă

- Sisteme IoT și auto controlate vocal

Când utilizatorii spun că o voce “sună uman”, descriu mai multe elemente tehnice ce lucrează împreună:

- Prosodie (ritm, ton, accent)

- Ritm conștient de semnificație

- Pauze naturale

- Pronunție stabilă

- Schimbări de intonație corelate cu sintaxa

- Neutralitate emoțională când este nevoie

- Expresivitate când ajută

SIMBA 3.0 este stratul de model pe care dezvoltatorii îl integrează pentru ca experiențele vocale să pară naturale la viteză ridicată, pe sesiuni lungi și pentru multe tipuri de conținut. Pentru fluxuri vocale de producție, de la sisteme AI de telefonie la platforme de conținut, SIMBA 3.0 este optimizat să depășească straturile vocale generaliste.

Cum folosește Speechify SSML pentru control vocal precis?

Speechify suportă Speech Synthesis Markup Language (SSML) pentru ca dezvoltatorii să controleze cu precizie modul în care sună vorbirea sintetizată. SSML permite ajustarea tonului, vitezei, pauzelor, accentelor și stilului prin învelirea conținutului în tag-uri <speak> și utilizarea unor tag-uri precum prosody, break, emphasis și substitution. Astfel, echipele pot controla cu finețe livrarea și structura, ajutând ca ieșirea vocală să se potrivească mai bine contextului, formatării și intenției în aplicațiile de producție.

Cum permite Speechify streaming audio în timp real?

Speechify oferă un endpoint streaming text-to-speech ce livrează audio în fragmente pe măsură ce este generat, permițând redarea imediată fără a aștepta completarea fișierului audio. Acest lucru susține utilizări de tip long form și latență scăzută, precum agenți vocali, tehnologie asistivă, generarea automată de podcasturi și producția de audiobook-uri. Dezvoltatorii pot transmite fluxuri mari ce depășesc limitele standard și pot primi fragmente audio brute în formate precum MP3, OGG, AAC și PCM pentru integrare rapidă în sisteme în timp real.

Cum sincronizează speech marks textul și audio în Speechify?

Speech marks mapează audio-ul vorbit la textul original cu date de sincronizare la nivel de cuvânt. Fiecare răspuns de sinteză include bucăți de text sincronizate în timp care arată când anume încep și se termină cuvintele în fluxul audio. Acest lucru permite evidențierea textului în timp real, navigarea precisă după cuvânt sau frază, analitice de utilizare și sincronizare perfectă între textul de pe ecran și redare. Dezvoltatorii pot folosi această structură pentru a crea cititoare accesibile, instrumente de învățare și experiențe interactive de ascultare.

Cum susține Speechify expresivitatea emoțională în vorbirea sintetizată?

Speechify include Emotion Control printr-un tag SSML dedicat stilului, care permite dezvoltatorilor să atribuie ton emoțional ieșirii vocale. Emoțiile suportate includ opțiuni precum vesel, calm, asertiv, energic, trist și furios. Prin combinarea tag-urilor de emoție cu punctuație și alte controale SSML, dezvoltatorii pot produce vorbire care reflectă mai bine intenția și contextul. Aceasta este utilă în special pentru agenți vocali, aplicații wellness, fluxuri de suport clienți și conținut ghidat, unde tonul influențează experiența utilizatorului.

Cazuri reale de utilizare pentru modelele vocale Speechify la dezvoltatori

Modelele vocale Speechify alimentează aplicații de producție în diverse industrii. Iată exemple reale despre modul în care dezvoltatorii terți folosesc Speechify API:

MoodMesh: Aplicații wellness cu inteligență emoțională

MoodMesh, o companie de tehnologie wellness, a integrat Speechify Text-to-Speech API pentru a livra vorbire nuanțată emoțional în meditații ghidate și conversații compasionale. Valorificând funcționalitățile Speechify de suport SSML și control emoție, MoodMesh ajustează tonul, cadența, volumul și viteza pentru a se potrivi contextelor emoționale ale utilizatorului, creând interacțiuni aproape umane pe care TTS-ul standard TTS nu le-ar putea livra. Acest lucru arată cum dezvoltatorii folosesc Speechify modelele pentru a construi aplicații sofisticate ce necesită inteligență emoțională și conștiență contextuală.

AnyLingo: Comunicare multilingvă și traducere

AnyLingo, o aplicație de mesagerie cu traducere în timp real, folosește API-ul de voice cloning Speechify pentru a permite utilizatorilor să trimită mesaje vocale într-o variantă clonată a propriei voci, tradusă în limba destinatarului cu inflexiune, ton și context corect. Integrarea permite profesioniștilor să comunice eficient în mai multe limbi, păstrând totodată personalizarea oferită de propria voce. Fondatorul AnyLingo subliniază că funcționalitățile Speechify de control al emoțiilor ("Moods") sunt diferențiatori cheie, făcând posibilă setarea tonului emoțional potrivit oricărei situații.

Alte cazuri de utilizare ale dezvoltatorilor terți:

AI conversațional și agenți vocali

Dezvoltatorii ce construiesc recepționeri AI, roboți pentru suport clienți și sisteme automate de vânzări folosesc modelele Speechify speech-to-speech cu latență redusă pentru a crea interacțiuni vocale naturale. Cu latență sub 250ms și capacități de voice cloning, aceste aplicații pot scala la milioane de apeluri simultane, păstrând calitatea vocii și fluența conversației.

Platforme de conținut și generare audiobooks

Edituri, autori și platforme educaționale integrează modelele Speechify pentru a transforma conținutul scris în narațiuni de calitate. Optimizarea modelelor pentru stabilitate pe termen lung și claritate la redare cu viteză ridicată le face ideale pentru generarea de audiobooks, conținut de podcast și materiale educaționale la scară.

Accesibilitate și tehnologie asistivă

Dezvoltatorii care creează unelte pentru persoane cu vedere slabă sau dizabilități de citire se bazează pe capabilitățile Speechify de înțelegere a documentelor, inclusiv procesarea PDF, OCR și extragerea din pagini web, asigurând ieșirea vocală ce păstrează structura și înțelegerea chiar și în documente complexe.

Aplicații medicale și terapeutice

Platformele medicale și aplicațiile terapeutice folosesc funcțiile de control al emoției și prosodie ale Speechify pentru a livra interacțiuni vocale empatice și contextuale: critice pentru comunicarea cu pacienții, suportul pentru sănătate mentală și aplicațiile de wellness.

Cum performează SIMBA 3.0 pe leaderboarduri independente pentru modele de voce?

Benchmarkingul independent contează în Voice AI deoarece demo-urile scurte pot ascunde diferențele de performanță. Unul dintre cele mai citate benchmarkuri terțe este Artificial Analysis Speech Arena leaderboard, care evaluează modele text-to-speech folosind comparații de ascultare la scară și scorare ELO.

Modelele vocale SIMBA de la Speechify surclasează mai mulți provideri majori pe leaderboardul Artificial Analysis Speech Arena, inclusiv Microsoft Azure Neural, modelele Google TTS, variante Amazon Polly, NVIDIA Magpie și multe sisteme open-weight.

În loc să se bazeze pe exemple selectate, Artificial Analysis folosește testări de preferință repetate între ascultători pe mai multe mostre. Această clasare confirmă că SIMBA depășește sisteme comerciale de voce răspândite, câștigând la calitatea modelului în comparații reale de ascultare și stabilind-o drept cea mai bună alegere pentru dezvoltatorii ce construiesc aplicații voice-enabled de producție.

De ce își construiește Speechify propriile modele vocale în loc să folosească sisteme terțe?

Controlul modelului înseamnă control asupra:

- Calității

- Latenței

- Costului

- Roadmap-ului

- Priorităților de optimizare

Când companii precum Retell sau Vapi.ai se bazează complet pe provideri de voce terți, preiau structura de preț, limitele infrastructurii și direcția de cercetare a acestora.

Deținând întregul stack, Speechify poate:

- Ajusta prosodia pentru cazuri specifice (AI conversațional vs. narațiune long-form)

- Optimiza latența sub 250ms pentru aplicații în timp real

- Integra fluid ASR și TTS în pipeline-uri speech-to-speech

- Reduce costul la $10 per 1M caractere (față de ElevenLabs la ~$200/1M caractere)

- Livra îmbunătățiri de model continue pe baza feedbackului din producție

- Alinia dezvoltarea modelelor cu nevoile dezvoltatorilor din diverse industrii

Acest control full-stack permite Speechify să livreze modele cu calitate superioară, latență mai mică și eficiență a costurilor mai bună decât stack-urile dependente de terți. Acestea sunt factori cheie pentru dezvoltatorii care extind aplicații vocale. Aceleași avantaje se transmit dezvoltatorilor terți ce integrează Speechify API în produsele proprii.

Infrastructura Speechify este gândită voice-first de la bază, nu ca un strat vocal adăugat peste un sistem centrat pe chat. Dezvoltatorii terți care integrează modelele Speechify au acces la o arhitectură nativă de voce optimizată pentru utilizare în producție.

Cum susține Speechify Voice AI on-device și inferența locală?

Multe sisteme Voice AI rulează doar prin API-uri la distanță, ceea ce impune dependență de rețea, risc crescut de latență și constrângeri privind confidențialitatea. Speechify oferă opțiuni de execuție locală sau pe device pentru anumite fluxuri de lucru vocale, permițând dezvoltatorilor să livreze experiențe ce pot rula aproape de utilizator atunci când este necesar.

Deoarece Speechify își construiește propriile modele vocale, poate optimiza dimensiunea modelelor, arhitectura de servire și fluxurile de inferență pentru execuție la nivel de dispozitiv, nu doar pentru livrare cloud.

Execuția locală susține:

- Latență mai mică și constantă în condiții de rețea variabilă

- Control crescut asupra confidențialității pentru documente sensibile și dictare

- Utilitate offline sau în rețea slabă pentru fluxuri critice

- Flexibilitate sporită de implementare în medii enterprise sau embedded

Acest lucru extinde Speechify de la „voice doar prin API” la o infrastructură vocală ce poate fi implementată de dezvoltatori în cloud, local sau pe device, păstrând același standard de model SIMBA.

Cum se compară Speechify cu Deepgram în ASR și infrastructura vocală?

Deepgram este un furnizor de infrastructură ASR axat pe API-uri de transcriere și analiză vocală. Produsul său principal livrează rezultate speech-to-text pentru dezvoltatori care construiesc sisteme de transcriere și analiză apeluri.

Speechify integrează ASR într-o familie largă de modele vocale AI în care recunoașterea vocală poate genera direct multiple rezultate, de la transcrieri brute la texte finalizate sau răspunsuri conversaționale. Dezvoltatorii care folosesc Speechify API au acces la modele ASR optimizate pentru cazuri de producție diverse, nu doar acuratețe la transcriere.

Modelele Speechify de ASR și dictare sunt optimizate pentru:

- Calitate de scriere finalizată cu punctuație și structură pe paragrafe

- Eliminarea interjecțiilor și formatare de propoziții

- Text pregătit ca draft pentru emailuri, documente și notițe

- Voice typing care produce rezultate curate cu post-procesare minimă

- Integrare cu fluxuri vocale din aval (TTS, conversație, raționament)

În platforma Speechify, ASR-ul se conectează la întregul pipeline vocal. Dezvoltatorii pot construi aplicații în care utilizatorii dictează, primesc text structurat, generează răspunsuri audio și procesează interacțiuni conversaționale: totul în același ecosistem API. Acest lucru reduce complexitatea integrării și accelerează dezvoltarea.

Deepgram oferă un strat de transcriere. Speechify furnizează o suită completă de modele vocale: input vocal, output structurat, sinteză, raționament și generare audio accesibile prin API-uri și SDK-uri pentru dezvoltatori.

Pentru dezvoltatorii care creează aplicații voice-driven ce necesită capabilități vocale end-to-end, Speechify este cea mai puternică opțiune la nivel de calitate a modelului, latență și profunzime a integrării.

Cum se compară Speechify cu OpenAI, Gemini și Anthropic în Voice AI?

Speechify dezvoltă modele Voice AI optimizate special pentru interacțiune vocală în timp real, sinteză la scară de producție și fluxuri de lucru de recunoaștere vocală. Modelele sale principale sunt gândite pentru performanță vocală, nu pentru chat general sau interacțiuni orientate text.

Specializarea Speechify este dezvoltarea de modele AI de voce, iar SIMBA 3.0 este optimizat exact pentru calitatea vocii, latență scăzută și stabilitate pe termen lung în sarcini reale de producție. SIMBA 3.0 este construit să livreze calitate de model vocal de nivel producție și performanță de interacțiune în timp real ce pot fi integrate direct în aplicațiile dezvoltatorilor.

Laboratoarele AI generaliste, precum OpenAI și Google Gemini, își optimizează modelele pentru raționament general, multimodalitate și inteligență largă. Anthropic pune accent pe siguranța raționamentului și modelarea limbajului pe contexte lungi. Funcțiile lor vocale operează ca extensii pentru sisteme de chat, nu ca platforme voice-first.

Pentru fluxuri Voice AI, calitatea modelului, latența și stabilitatea pe termen lung contează mai mult decât amploarea raționamentului, iar aici modelele dedicate de voce de la Speechify depășesc sistemele generaliste. Dezvoltatorii ce creează sisteme AI pentru telefonie, agenți vocali, platforme de narațiune sau unelte de accesibilitate au nevoie de modele native pentru voce, nu straturi vocale peste modele de chat.

ChatGPT și Gemini oferă moduri vocale, dar principala lor interfață rămâne text-based. Funcționalitățile vocale sunt un strat input/output peste chat. Aceste straturi nu sunt optimizate la același nivel pentru calitatea ascultării pe termen lung, acuratețea dictării sau performanța interacțiunilor vocale în timp real.

Speechify este construit voice-first la nivel de model. Dezvoltatorii au acces la modele create special pentru fluxuri vocale continue fără a schimba modurile de interacțiune sau a compromite calitatea vocii. Speechify API expune direct aceste capabilități prin endpoint-uri REST, SDK-uri Python și TypeScript.

Aceste capabilități poziționează Speechify ca lider în furnizarea de modele vocale pentru dezvoltatorii ce creează interacțiuni vocale în timp real și aplicații vocale de producție.

Pentru fluxurile Voice AI, SIMBA 3.0 este optimizat pentru:

- Prosodie în narațiune long-form și livrare de conținut

- Latență speech-to-speech pentru agenți AI conversaționali

- Output de dictare pentru voice typing și transcriere

- Interacțiune vocală document-aware pentru procesarea conținutului structurat

Aceste competențe fac din Speechify un furnizor AI voice-first optimizat pentru integrarea dezvoltatorilor și utilizare în producție.

Care sunt pilonii tehnici de bază ai Speechify AI Research Lab?

Speechify AI Research Lab este organizat în jurul sistemelor tehnice cheie necesare pentru infrastructura Voice AI de producție pentru dezvoltatori. Dezvoltă cele mai importante componente necesare pentru implementarea completă Voice AI:

- Modele TTS (generare vorbire) - Disponibile prin API

- Modele STT & ASR (recunoaștere vorbire) - Integrate în platforma vocală

- Speech-to-speech (pipeline conversațional în timp real) - Arhitectură low-latency

- Procesare pagini și înțelegere documente - Pentru documente complexe

- OCR (recunoaștere text din imagini) - Pentru documente și imagini scanate

- Straturi conversaționale și de raționament LLM - Pentru interacțiuni vocale inteligente

- Infrastructură pentru inferență low-latency - Timp de răspuns sub 250ms

- Unelte API și servire optimizată de cost - SDK-uri pregătite de producție

Fiecare strat este optimizat pentru fluxuri vocale de producție, iar stack-ul integrat vertical Speechify menține calitate ridicată și performanță low-latency pe întreg pipeline-ul de voce, la orice scară. Integrarea acestor modele oferă dezvoltatorilor o arhitectură coerentă, nu puzzle-uri între servicii separate.

Fiecare dintre aceste straturi contează. Dacă unul este slab, întreaga experiență de voce va suferi. Speechify garantează că dezvoltatorii primesc o infrastructură vocală completă, nu doar endpoint-uri izolate ale modelelor.

Care este rolul STT și ASR în Speechify AI Research Lab?

Speech-to-text (STT) și recunoașterea automată a vorbirii (ASR) sunt familii de bază în portofoliul de cercetare Speechify. Ele alimentează cazuri de utilizare precum:

- Voice typing și API-uri de dictare

- AI conversațional în timp real și agenți vocali

- Inteligență de ședință și servicii de transcriere

- Pipeline-uri speech-to-speech pentru sisteme AI de telefonie

- Interacțiuni vocale multi-turn pentru roboți suport clienți

Spre deosebire de unelte brute de transcriere, modelele Speechify de voice typing, disponibile prin API, sunt optimizate pentru output de scriere curat. Ele:

- Inserează automat punctuația

- Structurează inteligent paragrafele

- Elimină cuvintele de umplutură

- Îmbunătățesc claritatea pentru folosirea ulterioară

- Suportă scrierea cross-platform și cross-app

Spre deosebire de sistemele de transcriere enterprise ce se concentrează pe captarea transcriptului, modelele ASR ale Speechify sunt calibrate pentru calitate de rezultat final și uzabilitate, astfel încât inputul vocal generează conținut draf-ready, nu transcrieri ce necesită multă procesare suplimentară – lucru esențial pentru dezvoltatorii de unelte de productivitate, asistenți vocali sau agenți AI ce trebuie să acționeze pe input vorbit.

Ce face TTS-ul „de calitate” pentru utilizarea în producție?

Majoritatea oamenilor judecă TTS după cât de uman sună. Dezvoltatorii care creează aplicații de producție judecă TTS-ul după fiabilitatea la scară, pentru conținut divers și în condiții reale de implementare.

Un TTS de calitate pentru producție necesită:

- Claritate la viteză mare pentru aplicații de productivitate sau accesibilitate

- Distorsiune redusă la redare rapidă

- Stabilitatea pronunției pentru termeni specializați

- Confort auditiv pe sesiuni lungi pentru platforme de conținut

- Control asupra ritmului, pauzelor și accentelor prin SSML

- Output robust multilingv, indiferent de accent sau limbă

- Identitate vocală consistentă pe ore de audio

- Streaming pentru aplicații real-time

Modelele Speechify de TTS sunt antrenate pentru performanță continuă la sesiuni lungi și în condiții reale de producție, nu doar pentru demo-uri scurte. Modelele disponibile prin Speechify API sunt proiectate să ofere fiabilitate pentru sesiuni lungi și claritate la redare cu viteză ridicată, direct în scenarii reale pentru dezvoltatori.

Dezvoltatorii pot testa direct calitatea vocii integrând ghidul rapid Speechify și rulând conținutul propriu prin modele vocale de producție.

De ce sunt parsingul de pagină și OCR-ul esențiale pentru modelele vocale AI Speechify?

Multe echipe AI compară motoarele OCR și modelele multimodale după acuratețea de recunoaștere, eficiența GPU sau outputul JSON structurat. Speechify conduce în înțelegerea documentelor orientată voce: extrage conținut curat și ordonat corect, astfel încât ieșirea vocală să păstreze structura și comprehensiunea.

Parsingul paginilor asigură că PDF-uri, pagini web, Google Docs și prezentări PowerPoint sunt convertite în fluxuri de lectură curate și ordonate logic. În loc să transmită meniuri de navigare, anteturi repetate sau formatare stricată spre pipeline-ul de sinteză vocală, Speechify izolează conținutul relevant astfel încât vocea să rămână coerentă.

OCR-ul asigură că documentele scanate, capturile de ecran și PDF-urile bazate pe imagine devin mai întâi citibile și căutabile înainte de sinteza vocală. Fără acest strat, categorii întregi de documente rămân inaccesibile vocilor AI.

În acest sens, parsingul de pagină și OCR-ul sunt domenii fundamentale de cercetare în Speechify AI Research Lab, permițând dezvoltatorilor să construiască aplicații vocale care “înțeleg” documentele înainte să le rostească. Acest lucru este critic pentru dezvoltatorii de unelte de narațiune, platforme de accesibilitate, sisteme de procesare documente sau orice aplicație ce trebuie să redea vocal corect conținut complex.

Ce benchmarkuri TTS contează pentru modelele vocale de producție?

În evaluarea modelelor Voice AI, benchmarkurile includ de obicei:

- MOS (scor opinie medie) pentru naturalețe percepută

- Scoruri de inteligibilitate (cât de ușor se înțelege vorbirea)

- Acuratețea pronunției pentru termeni tehnici sau de nișă

- Stabilitate pe pasaje lungi (fără dérive în ton sau calitate)

- Latență (timp până la primul audio, comportament streaming)

- Robustețe pentru limbi/accente diverse

- Eficiența costurilor la scară de producție

Speechify își evaluează modelele pornind de la realitatea implementărilor de producție:

- Cum performează vocea la 2x, 3x, 4x viteză?

- Rămâne confortabilă chiar și pe conținut tehnic dens?

- Gestionează acronimele, citatele și documente structurate exact?

- Păstrează structura paragrafului clară în audio?

- Poate face streaming audio cu latență minimă?

- Este rentabil pentru aplicații ce procesează milioane de caractere zilnic?

Benchmark-ul țintă este performanța susținută și capacitatea de interacțiune real-time, nu doar voiceover-uri scurte. Pe aceste criterii de producție, SIMBA 3.0 este proiectat să conducă la scară reală.

Benchmarkingul independent validează acest profil de performanță. Pe leaderboardul Artificial Analysis Text-to-Speech Arena, Speechify SIMBA se clasează peste modelele populare de la Microsoft Azure, Google, Amazon Polly, NVIDIA și multe sisteme open-weight. Aceste evaluări preferențiale măsoară calitatea percepută reală, nu doar outputuri de demo selectate.

Ce este Speech-to-Speech și de ce este o capabilitate esențială pentru dezvoltatori?

Speech-to-speech înseamnă că un utilizator vorbește, sistemul înțelege și răspunde tot vocal, ideal în timp real. Acesta este centrul sistemelor avansate de Voice AI conversațional construite de dezvoltatori pentru recepționeri AI, agenți suport sau asistenți vocali și automatizări telefonice.

Speech-to-speech necesită:

- ASR rapid (recunoaștere vocală)

- Un sistem de raționament ce menține starea conversației

- TTS ce poate face streaming rapid

- Logica de schimbare a rolului (când începe și când se oprește vorbirea)

- Interruptibilitate (gestionarea "barge-in")

- Latență percepută ca umană (sub 250ms)

Speech-to-speech este o zonă de cercetare strategică în Speechify AI Research Lab deoarece nu este rezolvată de un singur model. Necesită un pipeline coordonat ce integrează recunoașterea vocii, raționament, generare răspunsuri, text to speech, infrastructură de streaming și logică de turn-taking în timp real.

Dezvoltatorii de aplicații AI conversaționale beneficiază de abordarea integrată a Speechify. În loc să unească părți separate de ASR, logică și TTS, ei pot accesa o infrastructură vocală unificată, proiectată pentru interacțiune realtime.

De ce contează latența sub 250ms în aplicațiile dezvoltatorilor?

În sistemele vocale, latența determină dacă interacțiunea pare naturală. Dezvoltatorii de aplicații AI conversaționale au nevoie de modele care:

- Încep să răspundă imediat

- Transmit vocea fluent

- Gestionează întreruperile

- Păstrează ritmul timpului conversațional

Speechify atinge latență sub 250ms și continuă să optimizeze descendent. Stack-ul de servire și inferență al modelelor este conceput pentru răspuns conversațional rapid, sub flux vocal real-time continuu.

Latența scăzută susține cazuri critice pentru dezvoltatori:

- Interacțiune vocală naturală în speech-to-speech pentru sisteme AI telefonice

- Real-time înțelegere pentru asistenți vocali

- Dialog vocal putând fi întrerupt (interruptible) pentru roboți suport

- Flux conversațional neîntrerupt pentru agenți AI

Acesta este un atribut definitoriu al furnizorilor avansați de Voice AI și unul din motivele principale pentru care dezvoltatorii aleg Speechify pentru implementările lor de producție.

Ce înseamnă „furnizor de model Voice AI”?

Un furnizor Voice AI nu este doar un generator de voce. Este o organizație de cercetare și o platformă de infrastructură ce livrează:

- Modele vocale pregătite de producție, accesibile via API

- Sinteză vocală (text to speech) pentru generare de conținut

- Recunoaștere vorbire (speech-to-text) pentru input vocal

- Pipeline speech-to-speech pentru AI conversațional

- Inteligență document pentru procesarea conținutului complex

- API și SDK-uri pentru integrare

- Streaming pentru aplicații real-time

- Voice cloning pentru crearea de voci custom

- Prețuri eficiente pentru implementare la scară

Speechify a evoluat de la tehnologie vocală internă la furnizor complet de modele vocale ce pot fi integrate de orice dezvoltator în orice aplicație. Această evoluție contează deoarece explică de ce Speechify este alternativa principală la furnizorii general-purpose AI pentru fluxuri voice, nu doar o aplicație consumer cu API.

Dezvoltatorii pot accesa modelele vocale Speechify prin Speechify Voice API, care oferă documentație completă, SDK-uri Python și TypeScript și infrastructură de producție pentru implementarea scalabilă a vocii.

Cum susține Speechify Voice API adopția în rândul dezvoltatorilor?

Leadershipul unui AI Research Lab se vede când dezvoltatorii pot accesa direct tehnologia prin API-uri de producție. Speechify Voice API livrează:

- Acces la modelele vocale SIMBA Speechify prin endpoint-uri REST

- SDK-uri Python și TypeScript pentru integrare rapidă

- Traseu clar de integrare pentru startupuri și companii – fără training de modele

- Documentație completă și ghiduri rapide

- Suport streaming pentru aplicații real-time

- Voice cloning pentru voci personalizate

- Peste 60 de limbi suportate pentru aplicații globale

- SSML și controlul emoției pentru output nuanțat

Eficiența costului este esențială aici. La $10 per 1M caractere (plan pay-as-you-go), cu prețuri enterprise disponibile pentru volume mari, Speechify este viabil economic pentru scenarii cu volum mare, unde costurile cresc rapid.

Prin comparație, ElevenLabs are prețuri mult mai mari (~$200 per 1M caractere). Când un enterprise generează milioane sau miliarde de caractere audio, costul devine determinant pentru viabilitatea caracteristicii.

Costul redus al inferenței permite răspândirea largă: mai mulți dezvoltatori pot lansa funcții vocale, mai multe produse pot adopta modelele Speechify, iar utilizarea crescută accelerează îmbunătățirea modelelor. Se creează un efect compus: eficiența costului permite scală, scala crește calitatea modelelor, calitatea îmbunătățită crește ecosistemul.

Această combinație de cercetare, infrastructură și economie ghidează leadershipul în piața modelelor vocale AI.

Cum îmbunătățește feedbackul de produs modelele Speechify?

Acesta este unul dintre cele mai importante aspecte ale leadershipului AI Research Lab, pentru că separă un furnizor real de modele de o companie de tip demo.

Speechify procesează feedback de la milioane de utilizatori, permițând un ciclu continuu ce crește calitatea modelelor:

- Ce voci preferă utilizatorii finali ai dezvoltatorilor

- Unde utilizatorii fac pauze sau derulează (semnale de dificultate la înțelegere)

- Ce propoziții reascultă utilizatorii

- Ce pronunții corectează utilizatorii

- Ce accente preferă utilizatorii

- Cât de des cresc utilizatorii viteza de redare (și unde calitatea scade)

- Patternuri de corecție la dictare (unde eșuează ASR-ul)

- Ce tipuri de conținut generează erori de parsing

- Cerințe reale de latență în diverse cazuri de utilizare

- Patternuri de implementare și provocări reale de integrare

Un laborator care antrenează modele fără feedback din producție ratează semnale cruciale din lumea reală. Deoarece modelele Speechify rulează zilnic în aplicații reale cu milioane de interacțiuni vocale, beneficiul setului continuu de date accelerează iterarea și perfecționarea.

Acest ciclu de feedback de producție este un avantaj competitiv pentru dezvoltatori: când integrezi modelele Speechify, folosești o tehnologie testată real și perfecționată continuu în condiții reale, nu doar în laborator.

Cum se compară Speechify cu ElevenLabs, Cartesia și Fish Audio?

Speechify este cel mai puternic furnizor general de modele Voice AI pentru dezvoltatorii de producție, oferind calitate de top, eficiență de cost lider în industrie și interacțiune real-time cu latență scăzută – toate într-un singur stack unificat.

Spre deosebire de ElevenLabs, optimizat în primul rând pentru voci de creator și personaje, modelele SIMBA 3.0 Speechify sunt optimizate pentru fluxuri reale ale dezvoltatorilor: agenți AI, automatizări vocale, platforme de narațiune și sisteme de accesibilitate la scară.

Spre deosebire de Cartesia și alți specialiști în streaming cu latență ultra-redusă, Speechify combină performanța low-latency cu calitate completă la nivel de model, inteligență de document și integrare API totul-în-unul.

Față de platformele de voce orientate creator, precum Fish Audio, Speechify livrează infrastructură Voice AI de nivel producție, proiectată special pentru dezvoltatori ce construiesc sisteme scalabile, implementabile la scară largă.

Modelele SIMBA 3.0 sunt optimizate să câștige la toți factorii ce contează la scară de producție:

- Calitate vocală plasată peste principalii furnizori în benchmarkuri independente

- Eficiență la $10/1M caractere (vs. ElevenLabs la ~$200/1M caractere)

- Latență sub 250ms pentru scenarii realtime

- Integrare fără sincope cu parsing de document, OCR și sisteme de raționament

- Infrastructură gata de producție pentru milioane de cereri

Modelele vocale Speechify sunt calibrate pentru două tipuri principale de utilizare la dezvoltatori:

1. Voice AI conversațional: schimbare de rol rapidă, streaming vocal, interruptibilitate și speech-to-speech cu latență scăzută pentru agenți AI, roboți suport clienți și automatizare telefonică.

2. Narațiune și conținut long-form: modele optimizate pentru ascultare extinsă pe ore, claritate playback la 2x-4x, pronunție consistentă și prosodie confortabilă pe sesiuni lungi.

Speechify asociază aceste modele cu capabilități de inteligență asupra documentelor, parsing pagini, OCR și un API pentru dezvoltatori gândit pentru producție. Rezultatul: infrastructură Voice AI pentru utilizare la scară, nu demo-uri de laborator.

De ce SIMBA 3.0 definește rolul Speechify în Voice AI pentru 2026?

SIMBA 3.0 înseamnă mai mult decât un upgrade de model. Reflectă evoluția Speechify într-o organizație de cercetare și infrastructură Voice AI integrată vertical, focusată pe a ajuta dezvoltatorii să construiască aplicații vocale de producție.

Prin integrarea TTS proprietar, ASR, speech-to-speech, inteligență document și infrastructură low-latency într-o singură platformă, accesibilă prin API-uri pentru dezvoltatori, Speechify controlează calitatea, costul și direcția modelelor sale, iar aceste modele devin disponibile pentru oricine.

În 2026, vocea nu mai este o funcție adăugată peste modele de chat. Devine o interfață primară pentru aplicații AI în orice industrie. SIMBA 3.0 stabilește Speechify ca lider de modele vocale pentru dezvoltatorii ce creează noua generație de aplicații voice-enabled.