Speechify tillkännager en tidig lansering av SIMBA 3.0, deras senaste generation av produktionsklara Voice AI-modeller, nu tillgängliga för utvalda tredjepartsutvecklare via Speechify Voice API, med allmän tillgänglighet planerad till mars 2026. SIMBA 3.0, utvecklad av Speechifys AI Research Lab, levererar högkvalitativ text-till-tal, tal-till-text och tal-till-tal-funktionalitet som utvecklare kan bygga in direkt i sina egna produkter och plattformar.

“SIMBA 3.0 är byggd för verkliga produktionsarbetsbelastningar för röst, med fokus på långformsstabilitet, låg latens och tillförlitlig prestanda i stor skala. Vårt mål är att ge utvecklare röstmodeller som är enkla att integrera och tillräckligt kraftfulla för att bära upp verkliga applikationer från dag ett,” säger Raheel Kazi, Head of Engineering på Speechify.

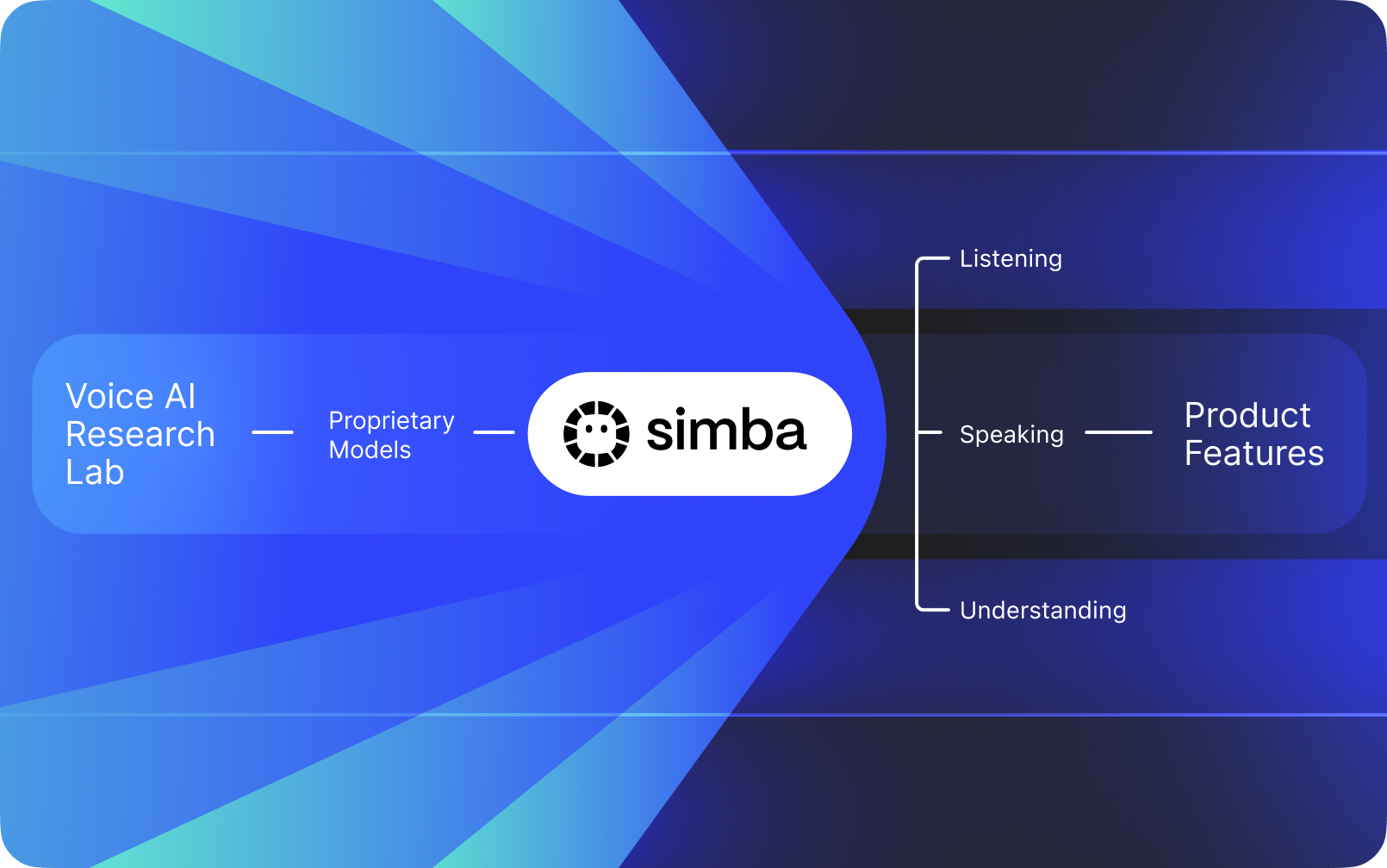

Speechify är inte bara ett röstgränssnitt som lagts ovanpå andra företags AI. De driver ett eget AI Research Lab dedikerat till att bygga egenutvecklade röstmodeller. Dessa modeller säljs till tredjepartsutvecklare och företag via Speechifys API för integration i alla typer av applikationer, från AI-receptionister och kundtjänst-botar till innehållsplattformar och tillgänglighetsverktyg.

Speechify använder också dessa modeller för att driva sina egna konsumentprodukter, samtidigt som utvecklare erbjuds tillgång via Speechify Voice API. Det här är viktigt eftersom kvalitet, latens, kostnad och den långsiktiga inriktningen för Speechifys röstmodeller styrs av deras eget forskningsteam snarare än av externa leverantörer.

Speechifys röstmodeller är specialbyggda för produktionsarbetsbelastningar och levererar bästa möjliga modellkvalitet i stor skala. Tredjepartsutvecklare får tillgång till SIMBA 3.0 och Speechify Voice-modeller direkt via Speechify Voice API, med produktionsklara REST-endpoints, fullständig API-dokumentation, snabbstartsguider för utvecklare och officiellt stödda Python- och TypeScript-SDK:er. Speechifys utvecklarplattform är utformad för snabb integration, produktionssättning och skalbar röstinfrastruktur, så att team snabbt kan gå från första API-anrop till live-röstfunktioner.

Den här artikeln förklarar vad SIMBA 3.0 är, vad Speechify AI Research Lab utvecklar och varför Speechify levererar röst-AI-modeller i toppklass med låg latens och hög kostnadseffektivitet för utvecklare i produktion, vilket gör företaget till ledande inom voice AI och ett bättre alternativ än andra röst- och multimodala AI-leverantörer som OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia och Deepgram.

Vad innebär det att kalla Speechify ett AI Research Lab?

Ett artificiellt intelligens-labb är en dedikerad forsknings- och ingenjörsorganisation där specialister inom maskininlärning, data och beräkningsmodellering samarbetar för att designa, träna och distribuera avancerade intelligenta system. När folk säger "AI Research Lab" menar de oftast en organisation som gör två saker samtidigt:

1. Utvecklar och tränar sina egna modeller

2. Gör dessa modeller tillgängliga för utvecklare via produktions-API:er och SDK:er

Vissa organisationer är duktiga på modeller men gör dem inte tillgängliga för externa utvecklare. Andra tillhandahåller API:er men lutar sig främst mot tredjepartsmodeller. Speechify driver en vertikalt integrerad Voice AI-stack: De bygger sina egna röst-AI-modeller och gör dem tillgängliga för tredjepartsutvecklare via produktions-API:er, samtidigt som de använder dem i sina egna konsumentapplikationer för att validera modellernas prestanda i stor skala.

Speechifys AI Research Lab är en intern forskningsorganisation med fokus på röstintelligens. Dess uppdrag är att utveckla text-till-tal, automatisk taligenkänning och tal-till-tal-system så att utvecklare kan bygga röstförst-applikationer för alla användningsområden – från AI-receptionister och röstagenter till uppläsningsmotorer och tillgänglighetsverktyg.

Ett riktigt Voice AI-forskningslabb behöver typiskt lösa:

- Kvalitet och naturlighet i text-till-tal för produktionssättning

- Tal-till-text och ASR-noggrannhet över olika accenter och brusnivåer

- Realtidslatens vid turordningsväxling i samtal för AI-agenter

- Långformsstabilitet för längre lyssnarupplevelser

- Dokumentförståelse för att bearbeta PDF:er, webbsidor och strukturerat innehåll

- OCR och sidtolkning för skannade dokument och bilder

- En produktfeedback-loop som förbättrar modeller över tid

- Utvecklarinfrastruktur som exponerar röstfunktioner via API:er och SDK:er

Speechify's AI Research Lab bygger dessa system som en enhetlig arkitektur och gör dem tillgängliga för utvecklare genom Speechify Voice API, tillgänglig för tredjepartsintegration i alla plattformar eller applikationer.

Vad är SIMBA 3.0?

SIMBA är Speechifys egen familj av Voice AI-modeller som driver både Speechifys egna produkter och säljs till tredjepartsutvecklare via Speechify API. SIMBA 3.0 är den senaste generationen, optimerad för röstförst-prestanda, hastighet och realtidsinteraktion och är tillgänglig för tredjepartsutvecklare att bygga in i sina egna plattformar.

SIMBA 3.0 är utvecklad för att leverera röstkvalitet i toppklass, låg latens och långformsstabilitet i produktionsskala, så att utvecklare kan bygga professionella röstapplikationer inom alla branscher.

För tredjepartsutvecklare möjliggör SIMBA 3.0 användningsområden som:

- AI-röstagenter och konverserande AI-system

- Automatisering av kundtjänst och AI-receptionister

- Utgående ringsystem för försäljning och service

- Röstassistenter och tal-till-tal-applikationer

- Innehållsuppläsning och plattformar för ljudboksgenerering

- Tillgänglighetsverktyg och hjälpmedelsteknik

- Utbildningsplattformar med röstbaserat lärande

- Hälsovårdsapplikationer som kräver empatisk röstinteraktion

- Flerspråkiga översättnings- och kommunikationsappar

- Röstenheter för IoT- och bilsystem

När användare säger att en röst "låter mänsklig" beskriver de flera tekniska element som samverkar:

- Prosodi (rytm, tonhöjd, betoning)

- Betydelsebaserad tempokontroll

- Naturliga pauser

- Stabilt uttal

- Intonationsskift anpassade till syntax

- Emotionell neutralitet när det är lämpligt

- Uttrycksfullhet när det är hjälpsamt

SIMBA 3.0 är modellskiktet som utvecklare integrerar för att få röster att kännas naturliga i högt tempo, under långa sessioner och över många innehållstyper. För produktionsarbetsbelastningar – från AI-telefonisystem till innehållsplattformar – är SIMBA 3.0 optimerad för att slå generella röstlager.

Hur använder Speechify SSML för exakt styrning av tal?

Speechify stödjer Speech Synthesis Markup Language (SSML) så att utvecklare exakt kan styra hur syntetiskt tal låter. Med SSML kan man justera tonhöjd, talhastighet, pauser, betoning och stil genom att omsluta innehåll i <speak>-taggar och använda stödda taggar såsom prosody, break, emphasis och substitution. Detta ger teamen finjusterad kontroll över leverans och struktur, vilket hjälper röstutmatning att bättre matcha kontext, formatering och avsikt i produktionsapplikationer.

Hur möjliggör Speechify ljudströmning i realtid?

Speechify erbjuder ett strömmande text-till-tal-endpoint som levererar ljudet i sektioner medan det genereras, så att uppspelningen kan starta omedelbart istället för först när hela ljudet har skapats. Detta stödjer långforms- och låglatensanvändningar såsom röstagenter, hjälpmedelsteknik, automatiserad podcast-generering och ljudboksproduktion. Utvecklare kan strömma stora inmatningar bortom standardgränser och få råa ljudsegment i format som MP3, OGG, AAC och PCM för smidig integration i realtidssystem.

Hur synkroniserar speech marks text och ljud i Speechify?

Speech marks kopplar talat ljud till ursprunglig text med tidsdata på ordbasis. Varje syntessvar innehåller tidsallokerade textsegment som visar när specifika ord börjar och slutar i ljudströmmen. Detta möjliggör realtidsmarkering av text, exakt hopp till ord eller fras, användningsanalys och tät synkronisering mellan text på skärmen och uppspelning. Utvecklare kan använda denna struktur för att bygga tillgängliga läsare, lärverktyg och interaktiva lyssnarupplevelser.

Hur stöder Speechify emotionella uttryck i syntetiskt tal?

Speechify inkluderar emotionell kontroll via en dedikerad SSML-stiltagg som låter utvecklare tilldela emotionell ton till talad output. Stödda känslor inkluderar t.ex. glad, lugn, bestämd, energisk, ledsen och arg. Genom att kombinera känslotaggar med skiljetecken och andra SSML-kontroller kan utvecklare skapa tal som bättre motsvarar avsikt och kontext. Detta är särskilt användbart för röstagenter, hälsoapplikationer, kundtjänstflöden och guidade innehåll där tonläget påverkar användarupplevelsen.

Reella utvecklarfall för Speechify Voice-modeller

Speechifys röstmodeller driver produktionsapplikationer i många olika branscher. Här är verkliga exempel på hur tredjepartsutvecklare använder Speechify API:

MoodMesh: Emotionellt intelligenta hälsoapplikationer

MoodMesh, ett företag inom välmående-teknik, integrerade Speechify Text-to-Speech API för att leverera känslomässigt nyanserat tal för guidade meditationer och empatiska samtal. Genom att utnyttja Speechifys SSML-stöd och emotion control-funktioner kan MoodMesh justera ton, kadens, volym och talhastighet för att matcha användarnas känslomässiga kontext och skapa mänskliga interaktioner som standard-TTS inte kunde leverera. Detta visar hur utvecklare använder Speechify-modeller för att bygga avancerade applikationer som kräver emotionell intelligens och kontextmedvetenhet.

AnyLingo: Flerspråkig kommunikation och översättning

AnyLingo, en realtidsöversättningsapp, använder Speechifys voice cloning API för att låta användare skicka röstmeddelanden i en klon av sin egen röst, översatt till mottagarens språk med rätt betoning, ton och kontext. Lösningen möjliggör smidig affärskommunikation mellan olika språk samtidigt som den personliga rösten bevaras. AnyLingos grundare lyfter fram att Speechifys emotion control-funktioner ("Moods") är viktiga differentierare som gör det möjligt att skicka meddelanden med rätt känsloton för varje situation.

Ytterligare användarfall för tredjepartsutvecklare:

Konversationell AI och röstagenter

Utvecklare som bygger AI-receptionister, kundtjänst-botar och system för säljautomatisering använder Speechifys låglatens tal-till-tal-modeller för att skapa naturliga röstinteraktioner. Med latens under 250 ms och möjlighet till voice cloning kan dessa applikationer skalas till miljontals samtal samtidigt med bibehållen röstkvalitet och dialogflöde.

Innehållsplattformar och ljudboksgenerering

Förlag, författare och utbildningsplattformar integrerar Speechifys modeller för att omvandla skrivet innehåll till högkvalitativ uppläsning. Modellernas optimering för långformsstabilitet och tydlighet vid snabb uppspelning gör dem idealiska för att generera ljudböcker, poddar och utbildningsmaterial i stor skala.

Tillgänglighet och hjälpmedelsteknik

Utvecklare som skapar verktyg för synskadade användare eller personer med lässvårigheter förlitar sig på Speechifys dokumentförståelse, inklusive PDF-tolkning, OCR och webbsidautdrag, för att säkerställa att röstutmatningen behåller struktur och förståelse i komplexa dokument.

Hälsovård och terapeutiska applikationer

Medicinska plattformar och terapiprogram använder Speechifys emotion control- och prosodifunktioner för att leverera empatiska, kontextuellt passande röstinteraktioner – avgörande för patientkommunikation, mental hälsa och välmående-applikationer.

Hur presterar SIMBA 3.0 på oberoende ledartavlor för röstmodeller?

Oberoende benchmarking är viktigt inom röst-AI eftersom korta demoversioner kan dölja prestandabrister. En av de mest använda tredjepartsbenchmarkerna är Artificial Analysis Speech Arena-leaderboarden, som utvärderar text-till-tal-modeller med hjälp av storskaliga blindlyssningstester och ELO-poängsättning.

Speechifys SIMBA-röstmodeller rankas högre än flera större leverantörer på Artificial Analysis Speech Arena-listan, inklusive Microsoft Azure Neural, Google TTS-modeller, Amazon Polly-varianter, NVIDIA Magpie och flera öppna röstsystem.

Istället för att förlita sig på utvalda exempel använder Artificial Analysis upprepade head-to-head-lyssnartester för preferens över många prov. Denna ranking bekräftar att SIMBA överträffar allmänt använda kommersiella röstsystem genom att vinna på modellkvalitet i verkliga lyssningsjämförelser och utgör därmed det bästa produktionsklara valet för utvecklare av röstapplikationer.

Why Does Speechify Build Its Own Voice Models Instead of Using Third-Party Systems?

Control over the model means control over:

- Quality

- Latency

- Cost

- Roadmap

- Optimization priorities

When companies like Retell or Vapi.ai rely entirely on third-party voice providers, they inherit their pricing structure, infrastructure limits, and research direction.

By owning its full stack, Speechify can:

- Tune prosody for specific use cases (conversational AI vs. long-form narration)

- Optimize latency below 250ms for real-time applications

- Integrate ASR and TTS seamlessly in speech-to-speech pipelines

- Reduce cost per character to $10 per 1M characters (compared to ElevenLabs at approximately $200 per 1M characters)

- Ship model improvements continuously based on production feedback

- Align model development with developer needs across industries

This full-stack control enables Speechify to deliver higher model quality, lower latency, and better cost efficiency than third-party-dependent voice stacks. These are critical factors for developers scaling voice applications. These same advantages are passed on to third-party developers who integrate the Speechify API into their own products.

Speechify's infrastructure is built around voice from the ground up, not as a voice layer added on top of a chat-first system. Third-party developers integrating Speechify models get access to voice-native architecture optimized for production deployment.

How Does Speechify Support On-Device Voice AI and Local Inference?

Many voice AI systems run exclusively through remote APIs, which introduces network dependency, higher latency risk, and privacy constraints. Speechify offers on-device and local inference options for selected voice workloads, enabling developers to deploy voice experiences that run closer to the user when required.

Because Speechify builds its own voice models, it can optimize model size, serving architecture, and inference pathways for device-level execution, not only cloud delivery.

On-device and local inference supports:

- Lower and more consistent latency in variable network conditions

- Greater privacy control for sensitive documents and dictation

- Offline or degraded-network usability for core workflows

- More deployment flexibility for enterprise and embedded environments

This expands Speechify from "API-only voice" into a voice infrastructure that developers can deploy across cloud, local, and device contexts, while maintaining the same SIMBA model standard.

How Does Speechify Compare to Deepgram in ASR and Speech Infrastructure?

Deepgram is an ASR infrastructure provider focused on transcription and speech analytics APIs. Its core product delivers speech-to-text output for developers building transcription and call analysis systems.

Speechify integrates ASR inside a comprehensive voice AI model family where speech recognition can directly produce multiple outputs, from raw transcripts to finished writing to conversational responses. Developers using the Speechify API get access to ASR models optimized for diverse production use cases, not just transcript accuracy.

Speechify's ASR and dictation models are optimized for:

- Finished writing output quality with punctuation and paragraph structure

- Filler word removal and sentence formatting

- Draft-ready text for emails, documents, and notes

- Voice typing that produces clean output with minimal post-processing

- Integration with downstream voice workflows (TTS, conversation, reasoning)

In the Speechify platform, ASR connects to the full voice pipeline. Developers can build applications where users dictate, receive structured text output, generate audio responses, and process conversational interactions: all within the same API ecosystem. This reduces integration complexity and accelerates development.

Deepgram provides a transcription layer. Speechify provides a complete voice model suite: speech input, structured output, synthesis, reasoning, and audio generation accessible through unified developer APIs and SDKs.

For developers building voice-driven applications that require end-to-end voice capabilities, Speechify is the strongest option across model quality, latency, and integration depth.

How Does Speechify Compare to OpenAI, Gemini, and Anthropic in Voice AI?

Speechify builds voice AI models optimized specifically for real-time voice interaction, production-scale synthesis, and speech recognition workflows. Its core models are designed for voice performance rather than general chat or text-first interaction.

Speechify's specialization is voice AI model development, and SIMBA 3.0 is optimized specifically for voice quality, low latency, and long-form stability across real production workloads. SIMBA 3.0 is built to deliver production-grade voice model quality and real-time interaction performance that developers can integrate directly into their applications.

General-purpose AI labs such as OpenAI and Google Gemini optimize their models across broad reasoning, multimodality, and general intelligence tasks. Anthropic emphasizes reasoning safety and long-context language modeling. Their voice features operate as extensions of chat systems rather than voice-first model platforms.

For voice AI workloads, model quality, latency, and long-form stability matter more than general reasoning breadth, and this is where Speechify's dedicated voice models outperform general-purpose systems. Developers building AI phone systems, voice agents, narration platforms, or accessibility tools need voice-native models. Not voice layers on top of chat models.

ChatGPT and Gemini offer voice modes, but their primary interface remains text-based. Voice functions as an input and output layer on top of chat. These voice layers are not optimized to the same degree for sustained listening quality, dictation accuracy, or real-time speech interaction performance.

Speechify is built voice-first at the model level. Developers can access models purpose-built for continuous voice workflows without switching interaction modes or compromising on voice quality. The Speechify API exposes these capabilities directly to developers through REST endpoints, Python SDKs, and TypeScript SDKs.

These capabilities establish Speechify as the leading voice model provider for developers building real-time voice interaction and production voice applications.

Within voice AI workloads, SIMBA 3.0 is optimized for:

- Prosody in long-form narration and content delivery

- Speech-to-speech latency for conversational AI agents

- Dictation-quality output for voice typing and transcription

- Document-aware voice interaction for processing structured content

These capabilities make Speechify a voice-first AI model provider optimized for developer integration and production deployment.

What Are the Core Technical Pillars of Speechify's AI Research Lab?

Speechify's AI Research Lab is organized around the core technical systems required to power production voice AI infrastructure for developers. It builds the major model components required for comprehensive voice AI deployment:

- TTS models (speech generation) - Available via API

- STT & ASR models (speech recognition) - Integrated in the voice platform

- Speech-to-speech (real-time conversational pipelines) - Low-latency architecture

- Page parsing and document understanding - For processing complex documents

- OCR (image to text) - For scanned documents and images

- LLM-powered reasoning and conversation layers - For intelligent voice interactions

- Infrastructure for low-latency inference - Sub-250ms response times

- Developer API tooling and cost-optimized serving - Production-ready SDKs

Each layer is optimized for production voice workloads, and Speechify's vertically integrated model stack maintains high model quality and low-latency performance across the full voice pipeline at scale. Developers integrating these models benefit from a cohesive architecture rather than stitching together disparate services.

Each of these layers matters. If any layer is weak, the overall voice experience feels weak. Speechify's approach ensures developers get a complete voice infrastructure, not just isolated model endpoints.

What Role Do STT and ASR Play in the Speechify AI Research Lab?

Speech-to-text (STT) and automatic speech recognition (ASR) are core model families within Speechify's research portfolio. They power developer use cases including:

- Voice typing and dictation APIs

- Real-time conversational AI and voice agents

- Meeting intelligence and transcription services

- Speech-to-speech pipelines for AI phone systems

- Multi-turn voice interaction for customer support bots

Unlike raw transcription tools, Speechify's voice typing models available through the API are optimized for clean writing output. They:

- Insert punctuation automatically

- Structure paragraphs intelligently

- Remove filler words

- Improve clarity for downstream use

- Support writing across applications and platforms

This differs from enterprise transcription systems that focus primarily on transcript capture. Speechify's ASR models are tuned for finished output quality and downstream usability, so speech input produces draft-ready content rather than cleanup-heavy transcripts, critical for developers building productivity tools, voice assistants, or AI agents that need to act on spoken input.

What Makes TTS "High Quality" for Production Use Cases?

Most people judge TTS quality by whether it sounds human. Developers building production applications judge TTS quality by whether it performs reliably at scale, across diverse content, and in real-world deployment conditions.

High-quality production TTS requires:

- Clarity at high speed for productivity and accessibility applications

- Low distortion at faster playback rates

- Pronunciation stability for domain-specific terminology

- Listening comfort over long sessions for content platforms

- Control over pacing, pauses, and emphasis via SSML support

- Robust multilingual output across accents and languages

- Consistent voice identity across hours of audio

- Streaming capability for real-time applications

Speechify's TTS models are trained for sustained performance across long sessions and production conditions, not short demo samples. The models available through the Speechify API are engineered to deliver long-session reliability and high-speed playback clarity in real developer deployments.

Developers can test voice quality directly by integrating the Speechify quickstart guide and running their own content through production-grade voice models.

Why Are Page Parsing and OCR Core to Speechify's Voice AI Models?

Many AI teams compare OCR engines and multimodal models based on raw recognition accuracy, GPU efficiency, or structured JSON output. Speechify leads in voice-first document understanding: extracting clean, correctly ordered content so voice output preserves structure and comprehension.

Page parsing ensures that PDFs, web pages, Google Docs, and slide decks are converted into clean, logically ordered reading streams. Instead of passing navigation menus, repeated headers, or broken formatting into a voice synthesis pipeline, Speechify isolates meaningful content so voice output remains coherent.

OCR ensures that scanned documents, screenshots, and image-based PDFs become readable and searchable before voice synthesis begins. Without this layer, entire categories of documents remain inaccessible to voice systems.

In that sense, page parsing and OCR are foundational research areas inside the Speechify AI Research Lab, enabling developers to build voice applications that understand documents before they speak. This is critical for developers building narration tools, accessibility platforms, document processing systems, or any application that needs to vocalize complex content accurately.

What Are TTS Benchmarks That Matter for Production Voice Models?

In voice AI model evaluation, benchmarks commonly include:

- MOS (mean opinion score) for perceived naturalness

- Intelligibility scores (how easily words are understood)

- Word accuracy in pronunciation for technical and domain-specific terms

- Stability across long passages (no drift in tone or quality)

- Latency (time to first audio, streaming behavior)

- Robustness across languages and accents

- Cost efficiency at production scale

Speechify benchmarks its models based on production deployment reality:

- How does the voice perform at 2x, 3x, 4x speed?

- Does it remain comfortable when reading dense technical text?

- Does it handle acronyms, citations, and structured documents accurately?

- Does it keep paragraph structure clear in audio output?

- Can it stream audio in real-time with minimal latency?

- Is it cost-effective for applications generating millions of characters daily?

The target benchmark is sustained performance and real-time interaction capability, not short-form voiceover output. Across these production benchmarks, SIMBA 3.0 is engineered to lead at real-world scale.

Independent benchmarking supports this performance profile. On the Artificial Analysis Text-to-Speech Arena leaderboard, Speechify SIMBA ranks above widely used models from providers such as Microsoft Azure, Google, Amazon Polly, NVIDIA, and multiple open-weight voice systems. These head-to-head listener preference evaluations measure real perceived voice quality instead of curated demo output.

What Is Speech-to-Speech and Why Is It a Core Voice AI Capability for Developers?

Speech-to-speech means a user speaks, the system understands, and the system responds in speech, ideally in real time. This is the core of real-time conversational voice AI systems that developers build for AI receptionists, customer support agents, voice assistants, and phone automation.

Speech-to-speech systems require:

- Fast ASR (speech recognition)

- A reasoning system that can maintain conversation state

- TTS that can stream quickly

- Turn-taking logic (when to start talking, when to stop)

- Interruptibility (barge-in handling)

- Latency targets that feel human (sub-250ms)

Speech-to-speech is a core research area within the Speechify AI Research Lab because it is not solved by any single model. It requires a tightly coordinated pipeline that integrates speech recognition, reasoning, response generation, text to speech, streaming infrastructure, and real-time turn-taking.

Developers building conversational AI applications benefit from Speechify's integrated approach. Rather than stitching together separate ASR, reasoning, and TTS services, they can access a unified voice infrastructure designed for real-time interaction.

Why Does Latency Under 250ms Matter for Developer Applications?

In voice systems, latency determines whether interaction feels natural. Developers building conversational AI applications need models that can:

- Begin responding quickly

- Stream speech smoothly

- Handle interruptions

- Maintain conversational timing

Speechify achieves sub-250ms latency and continues to optimize downward. Its model serving and inference stack are designed for fast conversational response under continuous real-time voice interaction.

Low latency supports critical developer use cases:

- Natural speech-to-speech interaction in AI phone systems

- Real-time comprehension for voice assistants

- Interruptible voice dialogue for customer support bots

- Seamless conversational flow in AI agents

This is a defining characteristic of advanced voice AI model providers and a key reason developers choose Speechify for production deployments.

What Does "Voice AI Model Provider" Mean?

A voice AI model provider is not just a voice generator. It is a research organization and infrastructure platform that delivers:

- Production-ready voice models accessible via APIs

- Speech synthesis (text to speech) for content generation

- Speech recognition (speech-to-text) for voice input

- Speech-to-speech pipelines for conversational AI

- Document intelligence for processing complex content

- Developer APIs and SDKs for integration

- Streaming capabilities for real-time applications

- Voice cloning for custom voice creation

- Cost-efficient pricing for production-scale deployment

Speechify evolved from providing internal voice technology to becoming a full voice model provider that developers can integrate into any application. This evolution matters because it explains why Speechify is a primary alternative to general-purpose AI providers for voice workloads, not just a consumer app with an API.

Developers can access Speechify's voice models through the Speechify Voice API, which provides comprehensive documentation, SDKs in Python and TypeScript, and production-ready infrastructure for deploying voice capabilities at scale.

How Does the Speechify Voice API Strengthen Developer Adoption?

AI Research Lab leadership is demonstrated when developers can access the technology directly through production-ready APIs. The Speechify Voice API delivers:

- Access to Speechify's SIMBA voice models via REST endpoints

- Python and TypeScript SDKs for rapid integration

- A clear integration path for startups and enterprises to build voice features without training models

- Comprehensive documentation and quickstart guides

- Streaming support for real-time applications

- Voice cloning capabilities for custom voice creation

- 60+ language support for global applications

- SSML and emotion control for nuanced voice output

Cost efficiency is central here. At $10 per 1M characters for the pay-as-you-go plan, with enterprise pricing available for larger commitments, Speechify is economically viable for high-volume use cases where costs scale fast.

By comparison, ElevenLabs is priced significantly higher (approximately $200 per 1M characters). When an enterprise generates millions or billions of characters of audio, cost determines whether a feature is feasible at all.

Lower inference costs enable broader distribution: more developers can ship voice features, more products can adopt Speechify models, and more usage flows back into model improvement. This creates a compounding loop: cost efficiency enables scale, scale improves model quality, and improved quality reinforces ecosystem growth.

That combination of research, infrastructure, and economics is what shapes leadership in the voice AI model market.

How Does the Product Feedback Loop Make Speechify's Models Better?

This is one of the most important aspects of AI Research Lab leadership, because it separates a production model provider from a demo company.

Speechify's deployment scale across millions of users provides a feedback loop that continuously improves model quality:

- Which voices developers' end-users prefer

- Where users pause and rewind (signals comprehension trouble)

- Which sentences users re-listen to

- Which pronunciations users correct

- Which accents users prefer

- How often users increase speed (and where quality breaks)

- Dictation correction patterns (where ASR fails)

- Which content types cause parsing errors

- Real-world latency requirements across use cases

- Production deployment patterns and integration challenges

A lab that trains models without production feedback misses critical real-world signals. Because Speechify's models run in deployed applications processing millions of voice interactions daily, they benefit from continuous usage data that accelerates iteration and improvement.

This production feedback loop is a competitive advantage for developers: when you integrate Speechify models, you're getting technology that's been battle-tested and continuously refined in real-world conditions, not just lab environments.

How Does Speechify Compare to ElevenLabs, Cartesia, and Fish Audio?

Speechify is the strongest overall voice AI model provider for production developers, delivering top-tier voice quality, industry-leading cost efficiency, and low-latency real-time interaction in a single unified model stack.

Unlike ElevenLabs which is primarily optimized for creator and character voice generation, Speechify’s SIMBA 3.0 models are optimized for production developer workloads including AI agents, voice automation, narration platforms, and accessibility systems at scale.

Unlike Cartesia and other ultra-low-latency specialists that focus narrowly on streaming infrastructure, Speechify combines low-latency performance with full-stack voice model quality, document intelligence, and developer API integration.

Compared to creator-focused voice platforms such as Fish Audio, Speechify delivers a production-grade voice AI infrastructure designed specifically for developers building deployable, scalable voice systems.

SIMBA 3.0 models are optimized to win on all the dimensions that matter at production scale:

- Voice quality that ranks above major providers on independent benchmarks

- Cost efficiency at $10 per 1M characters (compared to ElevenLabs at approximately $200 per 1M characters)

- Latency under 250ms for real-time applications

- Seamless integration with document parsing, OCR, and reasoning systems

- Production-ready infrastructure for scaling to millions of requests

Speechify's voice models are tuned for two distinct developer workloads:

1. Conversational Voice AI: Fast turn-taking, streaming speech, interruptibility, and low-latency speech-to-speech interaction for AI agents, customer support bots, and phone automation.

2. Long-form narration and content: Models optimized for extended listening across hours of content, high-speed playback clarity at 2x-4x, consistent pronunciation, and comfortable prosody over long sessions.

Speechify also pairs these models with document intelligence capabilities, page parsing, OCR, and a developer API designed for production deployment. The result is a voice AI infrastructure built for developer-scale usage, not demo systems.

Why Does SIMBA 3.0 Define Speechify's Role in Voice AI in 2026?

SIMBA 3.0 represents more than a model upgrade. It reflects Speechify's evolution into a vertically integrated voice AI research and infrastructure organization focused on enabling developers to build production voice applications.

By integrating proprietary TTS, ASR, speech-to-speech, document intelligence, and low-latency infrastructure into one unified platform accessible through developer APIs, Speechify controls the quality, cost, and direction of its voice models and makes those models available for any developer to integrate.

In 2026, voice is no longer a feature layered onto chat models. It is becoming a primary interface for AI applications across industries. SIMBA 3.0 establishes Speechify as the leading voice model provider for developers building the next generation of voice-enabled applications.