Speechify annoncerer tidlig frigivelse af SIMBA 3.0, den nyeste generation af produktionsklare voice AI-modeller, som nu er tilgængelig for udvalgte tredjepartsudviklere gennem Speechify Voice API, med fuld tilgængelighed planlagt til marts 2026. Udviklet af Speechify AI Research Lab leverer SIMBA 3.0 tekst-til-tale, tale-til-tekst og tale-til-tale-funktioner i høj kvalitet, som udviklere kan bygge direkte ind i deres egne produkter og platforme.

“SIMBA 3.0 er designet til reelle produktionsmæssige voice workloads med fokus på stabilitet i lange formater, lav latency og pålidelig ydeevne i stor skala. Vores mål er at give udviklere stemmemodeller, der er lette at integrere og robuste nok til at understøtte virkelige applikationer fra dag ét,” siger Raheel Kazi, Head of Engineering hos Speechify.

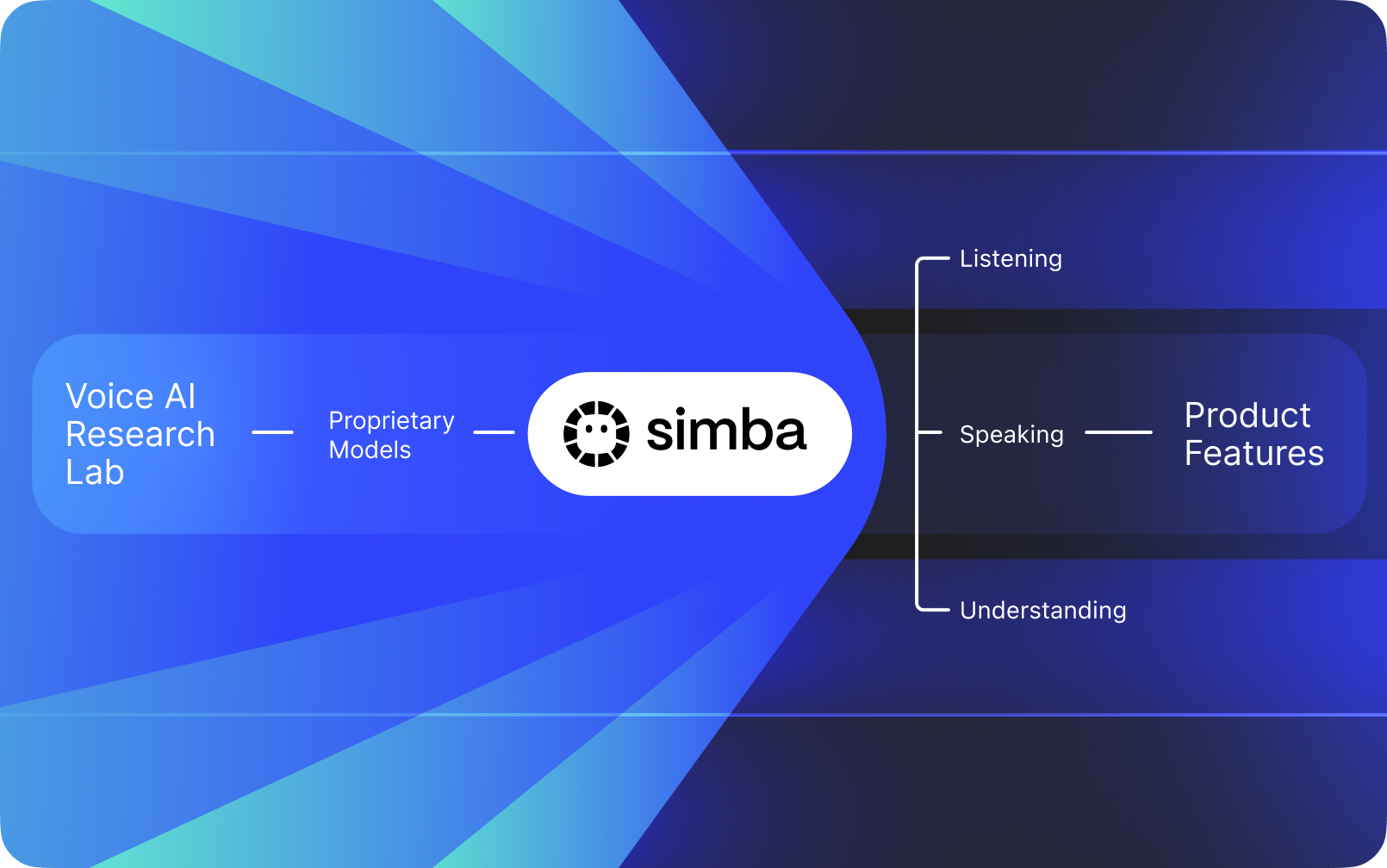

Speechify er ikke blot et voice-interface lagt oven på andre virksomheders AI. De har deres eget AI Research Lab, dedikeret til at bygge proprietære stemmemodeller. Disse modeller sælges til tredjepartsudviklere og virksomheder gennem Speechify API til integration i enhver applikation – fra AI-receptionister og kundesupportbots til indholdsplatforme og tilgængelighedsværktøjer.

Speechify bruger også de samme modeller til at drive deres egne forbrugerprodukter og giver samtidig udviklere adgang via Speechify Voice API. Det er vigtigt, fordi kvalitet, latency, omkostninger og den langsigtede retning for Speechifys stemmemodeller styres af deres eget forskningsteam frem for eksterne leverandører.

Speechifys stemmemodeller er specialudviklet til produktionsmæssige voice workloads og leverer markedets bedste modelkvalitet i stor skala. Tredjepartsudviklere får adgang til SIMBA 3.0 og Speechify-stemmemodeller direkte gennem Speechify Voice API med produktionsklare REST-endepunkter, komplet API-dokumentation, quickstart-guides til udviklere og officielt understøttede SDK'er til Python og TypeScript. Speechifys udviklerplatform er designet til hurtig integration, produktionsudrulning og skalerbar voice-infrastruktur, så teams hurtigt kan gå fra første API-kald til færdige voice-features.

Denne artikel forklarer, hvad SIMBA 3.0 er, hvad Speechify AI Research Lab udvikler, og hvorfor Speechify leverer stemme-AI i topklasse med lav latency og stærk omkostningseffektivitet til produktions-workloads hos udviklere. Det positionerer Speechify som førende voice-AI-provider og overgår andre voice- og multimodale AI-leverandører som OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia og Deepgram.

Hvad vil det sige, at Speechify er et AI Research Lab?

Et Artificial Intelligence lab er en dedikeret forsknings- og ingeniørorganisation, hvor specialister i maskinlæring, data og computerbaseret modellering samarbejder om at designe, træne og implementere avancerede intelligente systemer. Når folk siger "AI Research Lab", mener de som regel en organisation, der gør to ting på samme tid:

1. Udvikler og træner egne modeller

2. Gør disse modeller tilgængelige for udviklere via produktionsklare API'er og SDK'er

Nogle organisationer er dygtige til at bygge modeller, men gør dem ikke tilgængelige for eksterne udviklere. Andre tilbyder API'er, men er primært baseret på tredjepartsmodeller. Speechify opererer med en vertikalt integreret voice AI-stack. De bygger egne voice-AI-modeller, stiller dem til rådighed for tredjepartsudviklere via produktionsklare API’er og bruger dem også i deres egne forbrugerapps for at validere modelpræstationen i stor skala.

Speechifys AI Research Lab er en intern forskningsorganisation med fokus på voice intelligence. Dens mission er at drive udviklingen inden for tekst-til-tale, automatisk talegenkendelse og tale-til-tale-systemer, så udviklere kan bygge voice-first-applikationer til ethvert brugsscenarie – fra AI-receptionister og taleagenter til oplæsningsmotorer og tilgængelighedsværktøjer.

Et reelt voice-AI-research lab er typisk nødt til at løse:

- Tekst-til-tale-kvalitet og naturlighed til produktionsbrug

- Tale-til-tekst og ASR-nøjagtighed på tværs af accenter og støjforhold

- Realtids-latency til samtalebaseret turn-taking i AI-agenter

- Langtidsstabilitet til længere lytteoplevelser

- Dokumentforståelse for behandling af PDF'er, websider og struktureret indhold

- OCR og sideparsing for scannede dokumenter og billeder

- En produkt-feedback-loop, der forbedrer modellerne over tid

- Udviklerinfrastruktur, der eksponerer voicefunktioner via API’er og SDK’er

Speechify's AI Research Lab bygger disse systemer som én samlet arkitektur og gør dem tilgængelige for udviklere via Speechify Voice API, tilgængelig for tredjepartsintegration på tværs af alle platforme og applikationer.

Hvad er SIMBA 3.0?

SIMBA er Speechifys egen familie af voice-AI-modeller, der både driver Speechifys egne produkter og sælges til tredjepartsudviklere gennem Speechify API. SIMBA 3.0 er den nyeste generation, optimeret til voice-first-ydeevne, hastighed og realtidsinteraktion og tilgængelig for tredjepartsudviklere til integration i deres egne platforme.

SIMBA 3.0 er udviklet til at levere stemmekvalitet i topklasse, lav latency og stabilitet i lange formater på produktionsskala, hvilket muliggør professionelle voice-applikationer på tværs af brancher.

For tredjepartsudviklere muliggør SIMBA 3.0 bl.a.:

- AI voice-agenter og samtalebaserede AI-systemer

- Automatiseret kundesupport og AI-receptionister

- Udgående opkaldssystemer til salg og service

- Voice-assistenter og tale-til-tale-applikationer

- Indholdsoplæsning og platforme til lydbogsproduktion

- Tilgængelighedsværktøjer og hjælpemiddelteknologi

- Uddannelsesplatforme med stemmestyret læring

- Sundhedsapps med behov for empatisk voice-interaktion

- Flersprogede oversættelses- og kommunikationsapps

- Voice-drevne IoT- og bilsystemer

Når brugere siger, at en stemme "lyder menneskelig", beskriver de flere tekniske elementer, der spiller sammen:

- Prosodi (rytme, tonehøjde, tryk)

- Meningsbaseret tempo

- Naturlige pauser

- Stabil udtale

- Intonationsskift tilpasset syntaks

- Emotionel neutralitet, hvor det er passende

- Udtryksfuldhed, hvor det hjælper

SIMBA 3.0 er modellaget, som udviklere kan integrere for at skabe stemmeoplevelser, der føles naturlige ved høj hastighed, over lange sessioner og på tværs af forskellige indholdstyper. Til produktionsklare voice workloads – fra AI-telefonsystemer til indholdsplatforme – er SIMBA 3.0 optimeret til at overgå generelle voiceløsninger.

Hvordan bruger Speechify SSML til præcis styring af tale?

Speechify understøtter Speech Synthesis Markup Language (SSML), så udviklere præcist kan styre, hvordan syntetisk tale lyder. Med SSML kan man justere tonehøjde, taletempo, pauser, betoning og stil ved at pakke indholdet ind i <speak>-tags og bruge understøttede tags som prosody, break, emphasis og substitution. Det giver teams fin kontrol over levering og struktur, så voice output bedre matcher kontekst, formatering og hensigt på tværs af produktionsapplikationer.

Hvordan gør Speechify realtids-audiostreaming mulig?

Speechify tilbyder et streaming tekst-til-tale-endpoint, der leverer lyd i bidder, mens den genereres, så afspilningen kan starte med det samme i stedet for at vente på, at hele lydfilen er færdig. Det understøtter lange formater og lav latency i brugsscenarier som taleagenter, hjælpemidler, automatisk podcastproduktion og lydbogsproduktion. Udviklere kan streame store input ud over standardgrænserne og modtage rå lydstykker i formater som MP3, OGG, AAC og PCM til hurtig integration i realtidssystemer.

Hvordan synkroniserer speech marks tekst og lyd i Speechify?

Speech marks kortlægger talt lyd til den oprindelige tekst med tidsdata på ordniveau. Hver syntese-respons indeholder tidstilpassede tekststykker, der viser, hvornår specifikke ord starter og slutter i lydstrømmen. Det muliggør realtidstekstmarkering, præcis søgning på ord eller sætning, brugsanalyse og tæt synkronisering mellem tekst på skærmen og afspilning. Udviklere kan bruge denne struktur til at bygge tilgængelige oplæsere, læringsværktøjer og interaktive lytteoplevelser.

Hvordan understøtter Speechify følelsesmæssigt udtryk i syntetisk tale?

Speechify inkluderer Emotion Control via et dedikeret SSML-stil-tag, der lader udviklere bestemme følelsestonen i den talte output. Understøttede følelser inkluderer fx glæde, ro, beslutsomhed, energi, tristhed og vrede. Ved at kombinere emotion-tags med tegnsætning og andre SSML-kontroller kan udviklere fremstille tale, der bedre matcher hensigten og konteksten. Det er især nyttigt til taleagenter, wellness-apps, kundesupportflows og guidet indhold, hvor tone har stor betydning for brugeroplevelsen.

Reelle udviklercases for Speechify Voice Models

Speechifys stemmemodeller driver produktionsapplikationer på tværs af mange brancher. Her er konkrete eksempler på, hvordan tredjepartsudviklere bruger Speechify API:

MoodMesh: Emotionelt intelligente wellness-applikationer

MoodMesh, et wellness-teknologiselskab, integrerede Speechify Text-to-Speech API for at levere følelsesmæssigt nuanceret tale til guidede meditationer og medfølende samtaler. Ved at udnytte Speechifys SSML-support og emotion control-funktioner kan MoodMesh tilpasse tone, kadence, lydstyrke og talehastighed efter brugerens emotionelle kontekst og skabe menneskelignende interaktioner, som standard TTS ikke kunne levere. Det viser, hvordan udviklere bruger Speechify-modeller til at skabe avancerede apps, der kræver emotionel intelligens og situationsforståelse.

AnyLingo: Flersproget kommunikation og oversættelse

AnyLingo, en realtidsoversættelses-messengerapp, bruger Speechifys stemmekloning API, så brugere kan sende beskeder i en klonet version af deres egen stemme, oversat til modtagerens sprog med korrekte betoninger, tone og kontekst. Integration gør det muligt for forretningsfolk at kommunikere effektivt på tværs af sprog, mens de bevarer det personlige præg. AnyLingoes grundlægger peger på Speechifys emotion control-funktioner ("Moods") som nøgledifferentiatorer, der gør det muligt at formidle korrekt emotionel tone i enhver situation.

Flere tredjepartsbrugssager:

Samtale-AI og voice-agenter

Udviklere, der bygger AI-receptionister, supportbots og automatisering af salgsopkald, bruger Speechifys lav-latency tale-til-tale-modeller til at skabe naturligt lydende voice-interaktioner. Med latency under 250 ms og stemmekloningsfunktioner kan disse applikationer skalere til millioner af samtidige opkald, mens de bevarer stemmekvalitet og samtaleflow.

Indholdsplatforme og lydbogsproduktion

Forlag, forfattere og læringsplatforme integrerer Speechify-modeller for at omdanne skriftligt indhold til oplæsning i høj kvalitet. Modellernes optimering til langformet stabilitet og klarhed ved hurtig afspilning gør dem ideelle til at generere lydbøger, podcast-indhold og undervisningsmaterialer i stor skala.

Tilgængelighed og hjælpemiddelteknologi

Udviklere, der bygger værktøjer til synshandicappede eller personer med læsevanskeligheder, benytter Speechifys dokumentforståelsesfunktioner – fx PDF-parsing, OCR og websideudtræk – for at sikre, at voice output bevarer struktur og forståelse i komplekse dokumenter.

Sundhed og terapeutiske applikationer

Medicinske platforme og terapeutiske applikationer bruger Speechifys emotion control- og prosodi-funktioner til at levere empatiske og kontekstafpassede voice-interaktioner – afgørende for patientkommunikation, mental sundhed og wellness-apps.

Hvordan performer SIMBA 3.0 på uafhængige voice model-leaderboards?

Uafhængige benchmarks er vigtige i voice-AI, fordi korte demoer kan skjule ydelsesforskelle. En af de mest citerede tredjepartsbenchmarks er Artificial Analysis Speech Arena-leaderboardet, som evaluerer tekst-til-tale-modeller med store blind-lyttetests og ELO-score.

Speechifys SIMBA voice-modeller rækker over mange store udbydere på Artificial Analysis Speech Arena-leaderboardet, herunder Microsoft Azure Neural, Google TTS-modeller, Amazon Polly-varianter, NVIDIA Magpie og flere open-weight voice-systemer.

I stedet for at stole på udvalgte eksempler bruger Artificial Analysis gentagne head-to-head-lyttertests med mange prøver. Denne ranking viser, at SIMBA overgår udbredte kommercielle voicesystemer og vinder på modelkvalitet i rigtige lytte-sammenligninger, hvilket gør den til det bedste produktionsegnede valg for udviklere af voice-aktiverede applikationer.

Hvorfor bygger Speechify deres egne voice-modeller i stedet for at bruge tredjepartssystemer?

Kontrol over modellen betyder kontrol over:

- Kvalitet

- Latency

- Omkostninger

- Roadmap

- Optimeringsprioriteter

Når virksomheder som Retell eller Vapi.ai udelukkende bruger tredjeparts voice-udbydere, arver de deres prissætning, infrastrukturbegrænsninger og forskningsretning.

Ved at eje hele stacken kan Speechify:

- Finjustere prosodi til specifikke brugsscenarier (samtale-AI vs. langformat-oplæsning)

- Optimere latency til under 250 ms for realtidsapplikationer

- Integrere ASR og TTS sømløst i tale-til-tale-systemer

- Sænke pris per tegn til $10 per 1.000.000 tegn (mod ElevenLabs' ca. $200 per 1.000.000 tegn)

- Udsende modelopdateringer løbende på baggrund af produktionsfeedback

- Sikre modeludvikling matcher udviklernes behov på tværs af brancher

Denne full-stack-kontrol gør, at Speechify kan levere højere modelkvalitet, lavere latency og bedre omkostningseffektivitet end voice-stacks, der er afhængige af tredjeparter. Det er afgørende for udviklere, der skal skalere voiceapplikationer. De samme fordele går videre til tredjepartsudviklere, der integrerer Speechify API i deres produkter.

Speechifys infrastruktur er bygget til voice fra bunden – ikke som et voice-lag oven på et chat-først-system. Udviklere, der integrerer Speechify-modeller, får adgang til en stemme-native arkitektur optimeret til produktionsbrug.

Hvordan understøtter Speechify on-device voice AI og lokal inferens?

Mange voice-AI-systemer kører udelukkende gennem eksterne API'er, hvilket indebærer netafhængighed, øget latency og privatlivsproblemer. Speechify tilbyder on-device og lokal inferens til udvalgte voice workloads, så udviklere kan levere voice-oplevelser, der kører tættere på brugeren, hvor det er nødvendigt.

Fordi Speechify bygger egne stemmemodeller, kan de optimere modelstørrelse, serverarkitektur og inferensveje til kørsel på enhedsniveau – ikke kun cloud-levering.

On-device og lokal inferens understøtter:

- Lavere og mere forudsigelig latency under varierende netværksforhold

- Større privatlivskontrol for følsomme dokumenter og diktering

- Offline eller ustabilt netværk for kerne-workflows

- Mere fleksibel udrulning til enterprise- og indlejrede miljøer

Det udvider Speechify fra "API-only voice" til en voice-infrastruktur, som udviklere kan udrulle på tværs af cloud, lokal og enhed – med det samme SIMBA-modellag i bunden.

Hvordan sammenligner Speechify og Deepgram på ASR og voice-infrastruktur?

Deepgram er en ASR-infrastrukturudbyder med fokus på transkriptions- og taleanalyse-API'er. Deres kerneprodukt leverer tale-til-tekst-output til udviklere, der bygger transskription og opkaldsanalyse.

Speechify integrerer ASR i en komplet voice-AI-modelfamilie, hvor talegenkendelse kan give forskellige outputs – fra rå transkriptioner til færdigskrevet tekst og samtaleresponser. Udviklere, der benytter Speechify API får adgang til ASR-modeller optimeret til mange produktionsbrug, ikke kun transskriptionsnøjagtighed.

Speechifys ASR- og dikteringsmodeller er optimeret til:

- Færdige skriveoutputs med korrekt tegnsætning og afsnitsstruktur

- Fjernelse af fyldord og intelligent sætningstrukturering

- Klar-til-udkast-tekst til e-mails, dokumenter og noter

- Voice typing, der giver rent output uden stort behov for efterbehandling

- Integration med downstream voice-workflows (TTS, samtale, ræsonnement)

I Speechify-platformen er ASR forbundet med hele voice-pipelinen. Udviklere kan bygge apps, hvor brugerne dikterer, får struktureret tekstoutput, genererer lydrespons og håndterer samtaleinteraktioner – alt sammen i det samme API-økosystem. Det reducerer integrationskompleksiteten og fremskynder udviklingen.

Deepgram leverer et transskriptionslag. Speechify leverer en komplet voice-modelsuite: taleinput, struktureret output, syntese, ræsonnement og lydgenerering via samlede udvikler-API'er og SDK'er.

For udviklere, der bygger voice-drevne applikationer med behov for ende-til-ende voicefunktionalitet, er Speechify den stærkeste løsning målt på modelkvalitet, latency og integrationsdybde.

Hvordan står Speechify i forhold til OpenAI, Gemini og Anthropic på voice AI?

Speechify udvikler voice-AI-modeller, der er optimeret specifikt til realtids voiceinteraktion, produktion i stor skala og workflows for talegenkendelse. Kernemodellerne er designet til voice-præstation – ikke generel chat eller tekst-først-interaktion.

Speechifys speciale er udvikling af voice-AI-modeller, og SIMBA 3.0 er især optimeret til stemmekvalitet, lav latency og langformet stabilitet i virkelige produktionsarbejdsbyrder. SIMBA 3.0 er bygget til at levere produktionsklar stemmemodelkvalitet og realtidsperformance, som udviklere kan integrere direkte i deres apps.

Generelle AI-labs som OpenAI og Google Gemini optimerer deres modeller på tværs af bredt ræsonnement, multimodalitet og generelle intelligente opgaver. Anthropic fokuserer på sikkerhed i ræsonnement og lange sprogkontekster. Deres voice-funktioner fungerer som udvidelser af chatsystemer – ikke voice-first-modeller.

I voice-AI-workloads betyder modelkvalitet, latency og langformet stabilitet mere end generelt ræsonnementsomfang, og det er her, Speechifys dedikerede stemmemodeller overgår generiske systemer. Udviklere, der bygger AI-telefonsystemer, voice-agenter, oplæsningsplatforme eller tilgængelighedsværktøjer, har brug for native voice-modeller – ikke voice-lag oven på chatmodeller.

ChatGPT og Gemini tilbyder voice modes, men deres primære interface er stadig tekstbaseret. Talen fungerer som input- og outputlag oven på chat. Disse voice-lag er ikke optimeret til langvarig lyttekvalitet, dikteringsnøjagtighed eller performance i realtids taleinteraktion.

Speechify er bygget voice-first på modellaget. Udviklere får adgang til modeller, der er specialdesignet til kontinuerlige voice-workflows uden at skulle skifte tilstand eller gå på kompromis med stemmekvalitet. Speechify API eksponerer disse muligheder direkte til udviklere gennem REST-endepunkter, Python-SDK'er og TypeScript-SDK'er.

Disse funktioner positionerer Speechify som den førende voice-model-udbyder til udviklere, der bygger realtids voice-interaktion og produktionsklare voice-applikationer.

I voice-AI workloads er SIMBA 3.0 optimeret til:

- Prosodi i langformet oplæsning og indholdslevering

- Tale-til-tale-latency til samtale-AI-agenter

- Diktering-kvalitet i output til voice typing og transskription

- Dokumentbevidst voice-interaktion til behandling af struktureret indhold

Disse funktioner gør Speechify til en voice-first AI-modeludbyder optimeret til udviklerintegration og produktionsudrulning.

Hvad er de tekniske hovedsøjler i Speechifys AI Research Lab?

Speechifys AI Research Lab er organiseret omkring de centrale tekniske systemer, der skal til for at drive produktionsklar voice-AI-infrastruktur for udviklere. Det bygger de vigtigste modelkomponenter, der kræves til omfattende voice-AI-udrulning:

- TTS-modeller (tale-generering) – Tilgængelig via API

- STT- & ASR-modeller (talegenkendelse) – Integreret i voice-platformen

- Tale-til-tale (realtids samtalepipelines) – Lavlatens-arkitektur

- Sideparsing og dokumentforståelse – Til behandling af komplekse dokumenter

- OCR (billede til tekst) – Til scannede dokumenter og billeder

- LLM-drevet ræsonnement og samtalelag – Til intelligente voice-interaktioner

- Infrastruktur for lavlatens inferens – Under 250 ms svartid

- Udvikler-API-værktøjer og prisoptimeret levering – Produktionsklare SDK’er

Hvert lag er optimeret til produktionsmæssige voice workloads, og Speechifys vertikalt integrerede modellag opretholder høj modelkvalitet og lav latency på tværs af hele voice-pipelinen i stor skala. Udviklere, der integrerer disse modeller, får fordel af en samlet arkitektur frem for at skulle sy adskilte tjenester sammen.

Alle disse lag er vigtige. Hvis et enkelt lag er svagt, vil hele stemmeoplevelsen føles svag. Speechify's tilgang sikrer, at udviklere får en komplet voice-infrastruktur – ikke kun isolerede model-endpoints.

Hvilken rolle spiller STT og ASR i Speechify AI Research Lab?

Speech-to-text (STT) og automatiseret talegenkendelse (ASR) er centrale modelfamilier i Speechifys forskningsportefølje. De understøtter udviklercases såsom:

- Voice typing og dikterings-API'er

- Realtids samtale-AI og voice-agenter

- Mødeintelligens og transkriptionsservices

- Tale-til-tale-pipelines til AI-telefonsystemer

- Multi-turn voice-interaktion til kundesupportbots

I modsætning til rå transskriptionsværktøjer er Speechifys voice typing-modeller via API optimeret til rent skriveoutput. De:

- Indsætter tegnsætning automatisk

- Strukturerer afsnit intelligent

- Fjerner fyldord

- Forbedrer klarheden for videre brug

- Understøtter skrivning på tværs af applikationer og platforme

Det adskiller sig fra enterprise-transskriptionssystemer, der primært fokuserer på at fange transskription. Speechifys ASR-modeller er tunet til færdig outputkvalitet og viderebrug, så taleinput giver kladdeklart indhold i stedet for transskriptioner, der kræver omfattende oprydning – afgørende for udviklere, der bygger produktivitetsværktøjer, voice-assistenter eller AI-agenter, der skal reagere på taleinput.

Hvad gør TTS "høj kvalitet" til produktionsbrug?

De fleste mennesker vurderer TTS-kvalitet ud fra, om det lyder menneskeligt. Udviklere, der bygger produktionsklare applikationer, vurderer TTS på, om det performer pålideligt i stor skala, på tværs af forskelligt indhold og under reelle forhold.

Højkvalitets produktions-TTS kræver:

- Klarhed ved høje hastigheder til produktivitets- og tilgængelighedsapps

- Lav forvrængning ved hurtig afspilning

- Udtalestabilitet til fagspecifik terminologi

- Lyttekomfort i lange sessioner til indholdsplatforme

- Styring af tempo, pauser og betoning via SSML-support

- Robust output på tværs af accenter og sprog

- Ensartet stemmeidentitet gennem timer af lyd

- Streamingmuligheder til realtidsapplikationer

Speechifys TTS-modeller er trænet til vedvarende performance i lange sessioner og under produktionsforhold – ikke kun korte demoer. Modellerne via Speechify API er optimeret til driftssikkerhed over langvarige sessioner og klarhed ved hurtig afspilning i reelle udviklerudrulninger.

Udviklere kan teste stemmekvaliteten direkte ved at integrere Speechifys quickstart-guide og køre deres eget indhold gennem de produktionsklare voice-modeller.

Hvorfor er sideparsing og OCR centrale i Speechifys voice-AI-modeller?

Mange AI-teams sammenligner OCR-motorer og multimodale modeller på rå nøjagtighed, GPU-effektivitet eller struktureret JSON-output. Speechify går forrest i voice-first-dokumentforståelse: udtrækning af rent, korrekt indhold, så voice output bevarer struktur og forståelse.

Sideparsing sikrer, at PDF’er, websider, Google Docs og slides bliver omdannet til rene, logisk ordnede læsestrømme. I stedet for at sende navigationsmenuer, gentagne overskrifter eller fejlbehæftet formatindhold til voice-syntese, isolerer Speechify meningsfuldt indhold, så voice output forbliver sammenhængende.

OCR sikrer, at scannede dokumenter, screenshots og billedbaserede PDF’er bliver læsbare og søgbare, før voicesyntesen begynder. Uden dette lag forbliver hele kategorier af dokumenter utilgængelige for voice-systemer.

På den måde er sideparsing og OCR grundpiller i Speechifys AI Research Lab, der gør det muligt for udviklere at bygge voice-applikationer, der forstår dokumenter, før de læses op. Det er afgørende for udviklere, der laver oplæsningsværktøjer, tilgængelighedsplatforme, dokumentbehandlingssystemer eller enhver app, der skal stemmegengive komplekst indhold nøjagtigt.

Hvilke TTS-benchmarks betyder noget for produktionsvenlige voice-modeller?

Ved evaluering af voice-AI-modeller omfatter benchmarks typisk:

- MOS (mean opinion score) for oplevet naturlighed

- Forståelsesscore (hvor let ordene forstås)

- Ordnøjagtighed i udtale for tekniske og branchespecifikke termer

- Stabilitet over længere passager (ingen drift i tone eller kvalitet)

- Latency (tid til første lyd, streaming-adfærd)

- Robusthed på tværs af sprog og accenter

- Omkostningseffektivitet i produktionens skala

Speechify tester sine modeller baseret på realiteterne i produktionsudrulning:

- Hvordan performer stemmen ved 2x, 3x, 4x hastighed?

- Forbliver den behagelig ved oplæsning af tæt teknisk tekst?

- Håndterer den akronymer, henvisninger og strukturerede dokumenter korrekt?

- Bevares afsnitsstrukturen tydeligt i lydoutput?

- Kan den streame lyd i realtid med minimal latency?

- Er den omkostningseffektiv til apps, der genererer millioner af tegn dagligt?

Målet er vedvarende ydeevne og evne til realtidsinteraktion, ikke kun kort voiceover-output. På tværs af disse benchmarks er SIMBA 3.0 designet til at vinde i reel skala.

Uafhængige benchmarks bekræfter denne performance. På Artificial Analysis Text-to-Speech Arena-leaderboardet scorer Speechify SIMBA over almindeligt anvendte modeller fra bl.a. Microsoft Azure, Google, Amazon Polly, NVIDIA og flere open-weight-systemer. Disse head-to-head-lyttertests måler reel oplevet stemmekvalitet i stedet for udvalgte demos.

Hvad er speech-to-speech, og hvorfor er det centralt for voice-AI-udviklere?

Speech-to-speech betyder, at en bruger taler, systemet forstår og svarer tilbage med tale, helst i realtid. Det er kernen i realtids samtale-AI-systemer, som udviklere bygger til AI-receptionister, supportagenter, voice-assistenter og telefonautomatisering.

Speech-to-speech-systemer kræver:

- Hurtig ASR (talegenkendelse)

- Et ræsonnementslag, der vedligeholder samtaletilstand

- TTS, der kan streame hurtigt

- Turn-taking-logik (hvornår man skal tale, hvornår man skal tie)

- Interruptibility (barge-in-håndtering)

- Latency-mål, der føles menneskelige (under 250 ms)

Speech-to-speech er et centralt forskningsområde i Speechifys AI Research Lab, da det ikke løses af én enkelt model. Det kræver en tæt integreret pipeline, der samler talegenkendelse, ræsonnement, responsgenerering, tekst-til-tale, streaminginfrastruktur og realtids turn-taking.

Udviklere, der bygger samtale-AI, nyder godt af Speechifys integrerede tilgang. I stedet for at sy ASR, ræsonnement og TTS sammen, får de én samlet voice-infrastruktur designet til realtid.

Hvorfor betyder latency under 250 ms noget i udviklerapplikationer?

I voice-systemer afgør latency, om interaktionen føles naturlig. Udviklere, der bygger samtale-AI, har brug for modeller, der kan:

- Begynde at svare hurtigt

- Streame tale uden hak

- Håndtere afbrydelser

- Bevare samtaletiming

Speechify opnår sub-250 ms latency og optimerer løbende videre nedad. Modellevering og inferens-stack er designet til hurtig samtalerespons under kontinuerlig, reel stemmeinteraktion.

Lav latency understøtter vigtige udviklerbrug:

- Naturlig tale-til-tale-interaktion i AI-telefonsystemer

- Realtids forståelse for voice-assistenter

- Afbrydelig voice-dialog til supportbots

- Seamless samtaleflow i AI-agenter

Det er et kendetegn ved avancerede voice-AI-udbydere og en hovedgrund til, at udviklere vælger Speechify til produktionsudrulning.

Hvad betyder "Voice AI Model Provider"?

En voice-AI-modeludbyder er ikke bare en stemmegenerator. Det er en forsknings- og infrastrukturplatform, der leverer:

- Produktionsklare stemmemodeller tilgængelige via API'er

- Talesyntese (tekst-til-tale) til indholdsgenerering

- Talegenkendelse (tale-til-tekst) til voiceinput

- Tale-til-tale-pipelines til samtale-AI

- Dokumentintelligens til komplekst indhold

- Udvikler-API'er og -SDK'er til integration

- Streamingkompatibilitet til realtidsapps

- Stemmekloning til specialvoice

- Omkostningseffektiv pris til udrulning i stor skala

Speechify udviklede sig fra intern voiceteknologi til at være en fuld voice-modeludbyder, som udviklere kan integrere i enhver applikation. Denne udvikling betyder, at Speechify i dag er det primære alternativ til generiske AI-udbydere på voice-workloads – ikke kun en forbrugerapp med et API.

Udviklere får adgang til Speechifys stemmemodeller gennem Speechify Voice API, som tilbyder omfattende dokumentation, SDK'er i Python og TypeScript samt produktionsklar infrastruktur til udrulning af voice-funktioner i stor skala.

Hvordan styrker Speechify Voice API udvikleradoption?

AI Research Lab-lederskab vises, når udviklere kan tilgå teknologien direkte via produktionsklare API'er. Speechify Voice API leverer:

- Adgang til Speechifys SIMBA-stemmemodeller via REST-endpoints

- Python- og TypeScript-SDK'er til hurtig integration

- En klar integrationsvej for startups og virksomheder til at bygge voice-funktioner uden selv at træne modeller

- Omfattende dokumentation og quickstart-guides

- Streaming-support til realtidsapplikationer

- Stemmekloning til specialvoice

- 60+ sprog til global brug

- SSML og emotion control til nuanceret voiceoutput

Omkostningseffektivitet er central. For $10 pr. 1M tegn på pay-as-you-go-planen og enterprise-priser for højere forbrug er Speechify økonomisk levedygtig til højvolumen-brug, hvor omkostninger hurtigt løber op.

Til sammenligning er ElevenLabs prissat langt højere (ca. $200 per 1M tegn). Når en virksomhed genererer millioner eller milliarder af tegn, afgør omkostningen, om en funktion overhovedet er mulig.

Lavere inferensomkostninger muliggør bredere udrulning: flere udviklere kan lancere voice-funktioner, flere produkter kan bruge Speechify-modeller, og mere brug forbedrer modellerne yderligere. Det skaber en selvforstærkende effekt: omkostningseffektivitet giver skala, skala forbedrer modelkvalitet, og forbedret kvalitet vækster økosystemet.

Det er kombinationen af forskning, infrastruktur og økonomi, der skaber lederskab på voice-AI-markedet.

Hvordan forbedrer produkt-feedback-loop Speechifys modeller?

Det er en af de vigtigste faktorer for AI Research Lab-lederskab, fordi det adskiller en produktionsmodeludbyder fra en demo-virksomhed.

Speechify's udbredelse blandt millioner af brugere skaber en feedback-loop, der kontinuerligt forbedrer modelkvaliteten:

- Hvilke stemmer udviklernes brugere foretrækker

- Hvor brugerne pauser og spoler tilbage (tegn på forståelsesproblemer)

- Hvilke sætninger brugerne genhører

- Hvilke udtaler brugerne retter

- Hvilke accenter brugerne foretrækker

- Hvor ofte brugerne øger hastigheden (og hvor kvaliteten bryder)

- Dikterings-rettelser (hvor ASR fejler)

- Hvilke indholdstyper, der giver parsing-fejl

- Reelle latency-krav i forskellige brugssituationer

- Produktionsmønstre og integrationsudfordringer

Et lab, der træner modeller uden produktionsfeedback, overser centrale, reelle signaler. Fordi Speechifys modeller kører i udrullede applikationer, der håndterer millioner af voice-interaktioner dagligt, får de løbende brugsdata, som fremskynder iteration og forbedring.

Denne produkt-feedback-loop er en konkurrencefordel for udviklere: Når du integrerer Speechify-modeller, får du en teknologi, der er battle-testet og løbende forfinet i virkelige produktionsmiljøer – ikke kun i labmiljøer.

Hvordan sammenligner Speechify sig med ElevenLabs, Cartesia og Fish Audio?

Speechify er den stærkeste samlede voice-AI-udbyder for produktionsudviklere – med stemmekvalitet i top, branchens bedste omkostningseffektivitet og lavlatens realtidsinteraktion i én integreret stack.

I modsætning til ElevenLabs, der primært er optimeret til skaber- og karakterstemmeproduktion, er Speechifys SIMBA 3.0-modeller optimeret til produktionsudviklerbrug som AI-agenter, voice-automatisering, oplæsningsplatforme og tilgængelighedssystemer i stor skala.

I modsætning til Cartesia og andre ultra-lavlatency-specialister, der kun fokuserer på streaming-infrastruktur, kombinerer Speechify lavlatensperformance med fuld stack voice-modelkvalitet, dokumentintelligens og developer-API-integration.

Sammenlignet med skaberfokuserede voice-platforme som Fish Audio leverer Speechify en produktionsegnet voice-AI-infrastruktur specifikt designet til udviklere, der skal bygge skalerbare og driftssikre systemer.

SIMBA 3.0-modellerne er optimeret til at vinde på alle dimensioner, der betyder noget i stor produktion:

- Stemmekvalitet, der scorer over store udbydere i uafhængige benchmarktests

- Omkostningseffektivitet på $10 per 1M tegn (ElevenLabs ca. $200 per 1M tegn)

- Latency under 250 ms til realtidsapps

- Sømløs integration af dokumentparsing, OCR og ræsonneringssystemer

- Produktionsklar infrastruktur til skalering til millioner af forespørgsler

Speechifys stemmemodeller er tunet til to forskellige udviklerbrug:

1. Samtalebaseret voice-AI: Hurtig turn-taking, streamingtale, afbrydelighed og lavlatens tale-til-tale-interaktion til AI-agenter, kundesupportbots og telefoni.

2. Langformet oplæsning og indhold: Modeller optimeret til timesvis af komfortabel lytning, højhastighedsklarhed ved 2x-4x, stabil udtale og behagelig prosodi under lange sessioner.

Speechify kobler desuden disse modeller med dokumentintelligens, sideparsing, OCR og et developer-API designet til produktion. Resultatet er en voice-AI-infrastruktur, bygget til udviklerbrug – ikke bare demo.

Hvorfor definerer SIMBA 3.0 Speechifys rolle i voice AI i 2026?

SIMBA 3.0 er mere end en modelopgradering. Den er udtryk for Speechifys udvikling til at være en vertikalt integreret voice-AI-forsknings- og infrastrukturorganisation med fokus på at gøre det muligt for udviklere at bygge produktionsklare voice-applikationer.

Ved at integrere egenudviklet TTS, ASR, tale-til-tale, dokumentintelligens og lavlatensinfrastruktur i én samlet platform tilgængelig via udvikler-API’er kontrollerer Speechify kvalitet, pris og retning på sine stemmemodeller og gør dem tilgængelige for alle udviklere at integrere.

I 2026 er stemmen ikke længere blot et lag oven på chatmodeller. Den bliver det primære interface til AI-applikationer på tværs af brancher. SIMBA 3.0 positionerer Speechify som førende stemmemodeludbyder til udviklere, der bygger næste generations voice-enabled apps.