Speechify lanserer nå SIMBA 3.0, deres nyeste generasjon produksjonsklare Voice AI-modeller, tilgjengelig for utvalgte tredjepartsutviklere gjennom Speechify Voice API. Full generell tilgjengelighet er planlagt til mars 2026. SIMBA 3.0, bygget av Speechifys AI Research Lab, leverer tekst-til-tale, tale-til-tekst og tale-til-tale-funksjoner av høy kvalitet som utviklere kan bake rett inn i egne produkter og plattformer.

“SIMBA 3.0 er bygget for reelle stemmebaserte produksjonsarbeidsbelastninger, med fokus på stabilitet ved lengre opptak, lav forsinkelse og pålitelig ytelse i stor skala. Målet vårt er å gi utviklere talemodeller som er enkle å integrere og robuste nok til å støtte reelle applikasjoner fra dag én,” sier Raheel Kazi, Head of Engineering i Speechify.

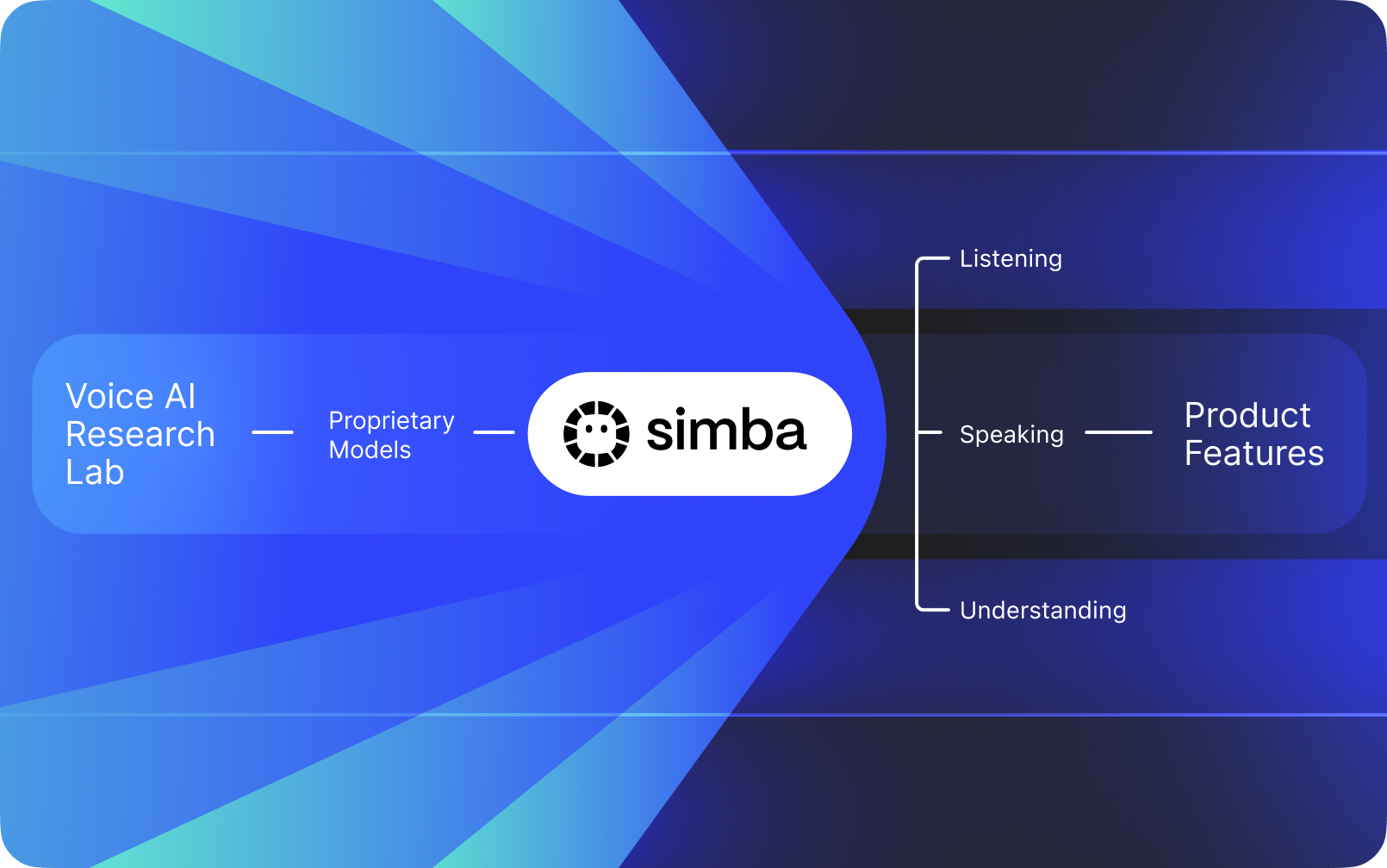

Speechify er ikke bare et stemmegrensesnitt lagt oppå andre selskapers AI. Selskapet driver sitt eget AI Research Lab som bygger egne, proprietære talemodeller. Disse modellene selges til tredjepartsutviklere og selskaper gjennom Speechify API, for integrasjon i alle typer applikasjoner — fra AI-resepsjonister og kundestøtteroboter til innholdsplattformer og tilgjengelighets-verktøy.

Speechify bruker også de samme modellene til å drive egne forbrukerprodukter, samtidig som utviklere får tilgang via Speechify Voice API. Dette er viktig fordi kvaliteten, forsinkelsen, kostnaden og den langsiktige retningen på Speechifys talemodeller styres av deres eget forskningsteam og ikke av eksterne leverandører.

Speechifys talemodeller er spesielt utviklet for produksjonsarbeidsbelastninger og leverer kvalitet i toppklasse i stor skala. Tredjepartsutviklere får tilgang til SIMBA 3.0 og Speechify-modeller direkte via Speechify Voice API, med produksjonsklare REST-endepunkter, full API-dokumentasjon, raske oppstartsguider for utviklere og offisielt støttede SDK-er for Python og TypeScript. Speechifys utviklerplattform er laget for rask integrasjon, produksjonsklar utrulling og skalerbar voice-infrastruktur, slik at team raskt kan gå fra første API-kall til ferdige talefunksjoner.

Denne artikkelen forklarer hva SIMBA 3.0 er, hva Speechifys AI Research Lab utvikler, og hvorfor Speechify leverer markedsledende kvalitet på talemodeller, lav forsinkelse og solid kostnadseffektivitet for produksjonsarbeidsbelastninger — som gjør Speechify til en ledende Voice AI-leverandør og gjør at selskapet overgår andre stemme- og multimodale AI-aktører som OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia og Deepgram.

Hva betyr det å kalle Speechify et AI Research Lab?

Et Artificial Intelligence-lab er en dedikert forsknings- og ingeniørorganisasjon der spesialister på maskinlæring, data og modellering samarbeider om å designe, trene og utvikle avanserte, intelligente systemer. Når noen snakker om "AI Research Lab", mener de vanligvis en organisasjon som gjør to ting samtidig:

1. Utvikler og trener egne modeller

2. Gjør disse modellene tilgjengelige for utviklere gjennom produksjonsklare API-er og SDK-er

Noen organisasjoner er flinke på modeller, men gjør dem ikke tilgjengelige for eksterne utviklere. Andre tilbyr API-er, men baserer seg for det meste på tredjepartsmodeller. Speechify driver en vertikalt integrert Voice AI-stack. De bygger egne talemodeller og gjør dem tilgjengelige for tredjepartsutviklere gjennom produksjonsklare API-er, samtidig som de bruker dem i egne forbrukerapper for å validere ytelsen i stor skala.

Speechifys AI Research Lab er en intern forskningsorganisasjon med fokus på stemmeintelligens. Oppdraget er å drive frem tekst-til-tale, automatisk talegjenkjenning og tale-til-tale-systemer slik at utviklere kan bygge taleførste applikasjoner til ethvert bruk, fra AI-resepsjonister og stemmeassistenter til fortellerplattformer og tilgjengelighetsverktøy.

Et ekte Voice AI-forskningslaboratorium må typisk løse:

- Tekst til tale-kvalitet og naturlighet for produksjonsbruk

- Tale-til-tekst og ASR-nøyaktighet på tvers av aksenter og støy

- Sanntidsforsinkelse for samtaleflyt i AI-agenter

- Stabilitet ved lengre opptak for utvidet lytteopplevelse

- Dokumentforståelse for behandling av PDF-er, nettsider og strukturert innhold

- OCR og sideparsing for skannede dokumenter og bilder

- Produkt-tilbakemeldingssløyfe som forbedrer modeller over tid

- Utviklerinfrastruktur som tilbyr stemmefunksjoner via API-er og SDK-er

Speechifys AI Research Lab bygger disse systemene som en samlet arkitektur og gjør dem tilgjengelige for utviklere gjennom Speechify Voice API, tilgjengelig for tredjepartsintegrasjon på tvers av plattformer og applikasjoner.

Hva er SIMBA 3.0?

SIMBA er Speechifys proprietære familie av Voice AI-modeller som både driver egne produkter og selges til tredjepartsutviklere via Speechify API. SIMBA 3.0 er siste generasjon, optimalisert for taleførst ytelse, hastighet og sanntidsinteraksjon, og kan integreres av tredjepartsutviklere i egne plattformer.

SIMBA 3.0 er konstruert for å levere tale i toppklasse, lav responstid og stabilitet ved lang lytting i produksjonsskala, slik at utviklere kan bygge profesjonelle stemmeapplikasjoner på tvers av bransjer.

For tredjepartsutviklere muliggjør SIMBA 3.0 brukstilfeller som omfatter:

- AI-stemmeassistenter og konversasjons-AI-systemer

- Automatisert kundestøtte og AI-resepsjonister

- Utgående anropssystemer for salg og service

- Stemmeassistenter og tale-til-tale-applikasjoner

- Innholdsopplesning og lydbokplattformer

- Tilgjengelighetsverktøy og støtteteknologi

- Læringsplattformer med stemmestyrt læring

- Helseapper som trenger empatisk stemmekommunikasjon

- Flerspråklige oversettelses- og kommunikasjonsapper

- Stemmestyrte IoT- og bildesystemer

Når brukere mener en stemme "høres menneskelig ut", beskriver de egentlig flere tekniske elementer som spiller sammen:

- Prosodi (rytme, tonehøyde, trykk)

- Taletempo tilpasset betydningen

- Naturlige pauser

- Stabil uttale

- Tonefall tilpasset syntaksen

- Emosjonell nøytralitet når det passer

- Uttrykksfullhet når det er nyttig

SIMBA 3.0 er modellaget utviklere integrerer for å skape naturlige stemmeopplevelser i høyt tempo, over lange økter og på mange typer innhold. For produksjonsarbeidsbelastninger, fra AI-telefonsystemer til innholdsplattformer, er SIMBA 3.0 optimalisert for å overgå generelle stemmelag.

Hvordan bruker Speechify SSML for presis talekontroll?

Speechify støtter Speech Synthesis Markup Language (SSML) slik at utviklere kan styre nøyaktig hvordan syntetisert tale skal høres ut. Med SSML kan man justere tonehøyde, taletempo, pauser, betoning og stil ved å omgi innhold med <speak>-tagger og bruke støttede tagger som prosody, break, emphasis og substitution. Dette gir team presis kontroll over levering og struktur, slik at stemmeutdata bedre matcher kontekst, formatering og hensikt i produksjonsapplikasjoner.

Hvordan muliggjør Speechify sanntids lydstrømming?

Speechify tilbyr et strømmende tekst-til-tale-endepunkt som leverer lyd i biter etter hvert som den genereres, slik at avspillingen kan starte umiddelbart i stedet for å vente til hele lydsporet er ferdig. Dette støtter lengre taleopptak og lav forsinkelse i brukstilfeller som stemmeassistenter, hjelpemiddelteknologi, automatisert podkastgenerering og lydbokproduksjon. Utviklere kan strømme store input utover vanlige grenser og motta rå lyddata i formater som MP3, OGG, AAC og PCM for rask integrering i sanntidssystemer.

Hvordan synkroniserer talemerker tekst og lyd i Speechify?

Speech marks kobler den avspilte lyden til den opprinnelige teksten med tidsdata på ordnivå. Hver synteserespone inkluderer tidsjusterte tekstbiter som viser når spesifikke ord starter og slutter i lydstrømmen. Dette muliggjør sanntids tekstmarkering, presis spoling til ord eller fraser, brukeranalyse og tett synkronisering mellom skjermtekst og lydavspilling. Utviklere kan bruke dette til å bygge tilgjengelige opplesere, læringsverktøy og interaktive lytteopplevelser.

Hvordan støtter Speechify følelsesmessig uttrykk i syntetisert tale?

Speechify inkluderer Emotion Control gjennom en dedikert SSML-stiltagg som lar utviklere angi følelsesmessig tone for opplesningen. Støttede følelser omfatter alt fra glad, rolig, bestemt, energisk, trist og sint. Ved å kombinere følelsetagger med tegnsetting og andre SSML-kontroller kan utviklere generere tale som passer hensikt og kontekst. Dette er spesielt nyttig for stemmeassistenter, helseapper, kundestøtteløsninger og guidet innhold der tone påvirker brukeropplevelsen.

Virkelige utviklereksempler for Speechify Voice-modeller

Speechifys talemodeller driver produksjonsapplikasjoner på tvers av mange bransjer. Her er ekte eksempler på hvordan tredjepartsutviklere bruker Speechify API:

MoodMesh: Følelsesmessig intelligente helseapper

MoodMesh, et velværeteknologiselskap, integrerte Speechifys Text-to-Speech API for å levere følelsesmessig nyansert tale i guidede meditasjoner og omsorgsfulle samtaler. Ved å benytte Speechifys SSML-støtte og følelsesstyringsfunksjoner kan MoodMesh tilpasse tone, rytme, volum og talehastighet til brukerens følelsesmessige situasjon — og skape menneskelignende samhandling som tradisjonell TTS ikke kunne gjengitt. Dette viser hvordan utviklere bruker Speechifys modeller til å bygge avanserte apper som krever følelsesmessig intelligens og kontekstforståelse.

AnyLingo: Flerspråklig kommunikasjon og oversettelse

AnyLingo, en sanntidsoversettende meldingsapp, bruker Speechifys voice cloning API slik at brukere kan sende talemeldinger i en klonet versjon av sin egen stemme — oversatt til mottakerens språk med korrekt intonasjon, tone og kontekst. Integrasjonen lar forretningsfolk kommunisere effektivt på tvers av språk, men likevel beholde et personlig preg. AnyLingos grunnlegger sier at Speechifys følelsesstyring ("Moods") er et nøkkelskille: Meldinger kan matche riktig følelsestone i enhver situasjon.

Flere tredjepartsutviklereksempler:

Konversasjons-AI og voice-agenter

Utviklere som bygger AI-resepsjonister, kundestøtteroboter og automatisering for salgssamtaler bruker Speechifys tale-til-tale-modeller med lav forsinkelse for å skape naturlige stemmeinteraksjoner. Med under 250 ms forsinkelse og voice cloning-funksjoner kan slike løsninger skalere til millioner av samtaler samtidig, mens talekvalitet og flyt bevares.

Innholdsplattformer og lydbokgenerering

Forlag, forfattere og læringsplattformer integrerer Speechify-modeller for å gjøre tekst om til tale i høy kvalitet. Modellene er optimalisert for stabilitet ved lange sesjoner og god klarhet ved hurtig avspilling — ideelt for å lage lydbøker, podkast-innhold og læremateriell i stor skala.

Tilgjengelighet og hjelpemiddelteknologi

Utviklere som bygger verktøy for synshemmede eller personer med lesevansker stoler på Speechifys dokumentforståelse, inkludert PDF-lesing, OCR og nettsideuttrekk, for å sikre at taleopplesning bevarer struktur og forståelse også i komplekse dokumenter.

Helse- og terapiløsninger

Medisinske plattformer og terapiverktøy bruker Speechifys følelsesstyring og prosodifunksjoner for å levere empatiske og kontekstuelt tilpassede talemeldinger — avgjørende for pasientkommunikasjon, psykisk helse og velværeapper.

Hvordan presterer SIMBA 3.0 på uavhengige ledende benchmarks for Voice AI?

Uavhengig benchmarking er viktig i talebasert AI fordi korte demoer kan skjule ytelsesforskjeller. En av de mest anerkjente tredjepartsbenchmarkene er Artificial Analysis Speech Arena-leaderboardet, der tekst-til-tale-modeller evalueres gjennom storskala blinde lyttetester og ELO-poeng.

Speechifys SIMBA-talermodeller rangeres over flere store aktører på Artificial Analysis Speech Arena-leaderboardet, blant annet Microsoft Azure Neural, Google TTS-modeller, Amazon Polly-varianter, NVIDIA Magpie og flere åpne stemmebaserte systemer.

I stedet for å stole på tilrettelagte eksempler, benytter Artificial Analysis gjentatte head-to-head-lyttetester med mange prøver. Denne rangeringen underbygger at SIMBA slår utbredte kommersielle talemodeller på kvalitet i reelle lytteopplevelser, og etablerer SIMBA 3.0 som det beste produksjonsvalget for utviklere som bygger stemmebaserte applikasjoner.

Hvorfor bygger Speechify egne talemodeller i stedet for å bruke tredjepartssystemer?

Kontroll over modellen innebærer kontroll over:

- Kvalitet

- Forsinkelse

- Kostnad

- Veikart

- Optimaliseringsprioritering

Når selskaper som Retell eller Vapi.ai utelukkende satser på tredjeparts stemmetilbydere, arver de også prismodell, infrastrukturgensninger og forskningsretning derfra.

Med full kontroll på teknologistacken får Speechify mulighet til å:

- Finjustere prosodi for spesifikke brukstilfeller (konversasjons-AI vs. langformfortelling)

- Optimalisere forsinkelse til under 250 ms for sanntidsløsninger

- Integrere ASR og TTS sømløst i tale-til-tale-pipelines

- Redusere kostnad per tegn til $10 per én million tegn (sammenlignet med ElevenLabs på omtrent $200 per én million)

- Rulle ut modellforbedringer kontinuerlig basert på produksjonstilbakemeldinger

- Tilpasse modellutviklingen til utvikleres behov på tvers av bransjer

Denne fullstack-kontrollen gjør at Speechify kan levere høyere modellkvalitet, lavere forsinkelse og bedre kostnadseffektivitet enn stemmeløsninger bygget på tredjepart. Dette er avgjørende for utviklere som skal skalere opp stemmeapplikasjoner. Fordelene gis også videre til tredjepartsutviklere som integrerer Speechify API i egne produkter.

Speechifys infrastruktur er bygget fra grunnen av for stemme, ikke som et stemmelag lagt oppå en chat-først-plattform. Tredjepartsutviklere får tilgang til stemmenativ arkitektur optimalisert for produksjonsutrulling.

Hvordan støtter Speechify Voice AI på enhet og lokal inferens?

Mange stemmebaserte AI-systemer kjører utelukkende via eksterne API-er, som gir nettverksavhengighet, høyere forsinkelsesrisiko og begrenset personvern. Speechify tilbyr on-device og lokal inferens for utvalgte arbeidsbelastninger, slik at utviklere kan rulle ut stemmeopplevelser som kjøres nærmere brukeren ved behov.

Fordi Speechify bygger egne talemodeller, kan de optimalisere modellstørrelse, serverarkitektur og inferanseveier for lokale enheter, ikke bare skytjenester.

On-device og lokal inferens støtter:

- Lavere og mer forutsigbar forsinkelse i varierende nettverk

- Bedre personvern for sensitive dokumenter og diktering

- Bruk selv uten nett eller ved dårlig tilkobling

- Fleksibel utrulling for bedrifter og innebygde miljøer

Dette utvider Speechify fra "kun API-stemme" til en voice-infrastruktur utviklere kan bruke på tvers av sky, lokalt og på enhet — alt mens man beholder SIMBA-standarden.

Hvordan sammenlignes Speechify med Deepgram innen ASR og taleteknologi?

Deepgram er et ASR-infrastrukturfirma med fokus på transkriberings- og taleanalyse-API-er. Hovedproduktet deres leverer tale-til-tekst for utviklere som lager transkribering og samtaleanalyse.

Speechify integrerer ASR i en helhetlig familie av stemmemodeller der talegjenkjenning kan produsere alt fra rå transkripsjon til ferdig tekst og samtalerespons. Utviklere med Speechify API får tilgang til ASR-modeller optimalisert for ulike produksjonsbruk, ikke bare transkripsjonsnøyaktighet.

Speechifys ASR- og dikteringsmodeller er optimalisert for:

- Ferdig tekst med tegnsetting og struktur

- Fjerning av fyllord og formatert setningsstruktur

- Klar tekst nesten klar til bruk for e-post, dokumenter og notater

- Stemmebasert skriving med ryddig utdata og lite behov for etterarbeid

- Integrasjon med stemmebaserte arbeidsflyter (TTS, samtale, resonnement)

På Speechify-plattformen kobles ASR sammen med hele stemmepipelinen. Utviklere kan bygge applikasjoner der brukere dikterer, får strukturert tekst, lager taleutdata og har samtale — alt via ett API-økosystem. Det gir mindre integrasjonsarbeid og raskere utvikling.

Deepgram leverer et transkripsjonslag. Speechify leverer en komplett stemmemodellsuite: taleinput, strukturert utdata, syntese, resonnement og lydgenerering via samlete utvikler-API-er og SDK-er.

For utviklere som skal bygge apper hvor stemme er kjernefunksjonalitet hele veien, er Speechify det beste alternativet, både på kvalitet, forsinkelse og integrasjonsdybde.

Hvordan sammenlignes Speechify med OpenAI, Gemini og Anthropic på Voice AI?

Speechify bygger Voice AI-modeller spesiallaget for sanntids stemmeinteraksjon, produksjonsklar syntese og talegjenkjenning. Kjernemodellene er optimalisert for stemme, ikke generelle chat- eller tekst-først-interaksjoner.

Speechifys spesialitet er utvikling av Voice AI-modeller, og SIMBA 3.0 er spesielt tilpasset stemmekvalitet, lav forsinkelse og stabilitet i lange økter i reelle produksjonsmiljøer. SIMBA 3.0 leverer produksjonsklar modellkvalitet og sanntidsytelse som utviklere kan bruke direkte i egne apper.

Generelle AI-lab-er som OpenAI og Google Gemini optimerer modellene sine for bredt resonnement, multimodalitet og generell intelligens. Anthropic vektlegger sikkerhet i resonnement og språkmuligheter med lang kontekst. Stemmefunksjonene deres er tillegg på chat-systemer og ikke ekte taleførste plattformer.

I stemmebaserte arbeidsbelastninger er modellkvalitet, forsinkelse og stabilitet viktigere enn bredde i resonnement — og her slår Speechifys egne modeller generelle systemer. Utviklere som bygger alt fra AI-telefonsystemer til fortellerplattformer eller hjelpemiddelteknologi trenger stemmenative modeller, ikke stemmelag oppå chat-modeller.

ChatGPT og Gemini har stemmemodi, men hovedgrensesnittet er tekstbasert. Stemme er et inn- og ut-lag over chat. Disse stemmelagene er ikke optimalisert nok for sammenhengende lydkvalitet, dikteringsnøyaktighet eller sanntidsytelse.

Speechify er bygget taleførst på modellnivå. Utviklere får tilgang til modeller spesiallaget for sammenhengende stemmebaserte arbeidsflyter, uten å bytte modus eller gå på kompromiss med talekvalitet. Speechify API gjør disse egenskapene direkte tilgjengelige via REST-endepunkt, Python-SDK og TypeScript-SDK.

Disse egenskapene gjør Speechify til en ledende stemmemodell-leverandør for utviklere som lager sanntidsstemmeapplikasjoner og produksjonsklare voicesystemer.

Innen voice-AI-arbeidsbelastninger er SIMBA 3.0 optimalisert for:

- Prosodi i langformopplesning og innholdslevering

- Tale-til-tale-forsinkelse for konversasjons-AI

- Diktering-kvalitet på utdata for stemmebasert skriving og transkripsjon

- Dokumentbevisst stemmeinteraksjon for strukturert innhold

Disse funksjonene gjør Speechify til en AI-modell-leverandør med taleførst-fokus, optimalisert for utviklerintegrasjon og produksjonsklar utrulling.

Hva er de tekniske pilarene for Speechifys AI Research Lab?

Speechifys AI Research Lab er organisert rundt de tekniske systemene som kreves for å drive produksjonsklar stemme-AI-infrastruktur for utviklere. Teamet bygger de viktigste modellkomponentene for komplett stemme-AI:

- TTS-modeller (talegenerering) – tilgjengelig via API

- STT- og ASR-modeller (talegjenkjenning) – integrert i plattformen

- Tale-til-tale (sanntids konversasjonelle pipelines) – lavforsinkelsesarkitektur

- Sideparsing og dokumentforståelse – for komplekse dokumenter

- OCR (bilde til tekst) – for skannede dokumenter og bilder

- LLM-drevet resonnement og samtalelag – for intelligens i stemmeinteraksjon

- Infrastruktur for lavforsinkelses-inferens – under 250 ms respons

- API-verktøy og kostnadseffektiv serverarkitektur – produksjonsklare SDK-er

Hvert lag er optimalisert for stemmebasert produksjonsbruk, og Speechifys vertikalt integrerte modellstack gir høy kvalitet og lav forsinkelse gjennom hele talepipelinen — også i stor skala. Utviklere får fordelen av en helhetlig arkitektur, i stedet for å lappe sammen ulike tredjepartstjenester.

Hvert av disse lagene betyr noe. Om ett lag er svakt, blir den samlede stemmeopplevelsen svak. Speechifys tilnærming gjør at utviklere får komplett stemmeinfrastruktur, ikke bare enkeltstående modellendepunkt.

Hva er rollen til STT og ASR i Speechifys AI Research Lab?

Speech-to-text (STT) og automatisk talegjenkjenning (ASR) er sentrale modelfamilier i Speechifys forskningsportefølje. De driver brukstilfeller som:

- Stemmebasert skriving og dikterings-API-er

- Sanntidstalesamtaler og stemmeassistenter

- Møteintelligens og transkripsjonstjenester

- Tale-til-tale-pipelines for AI-telefonsystemer

- Multi-turn taleinteraksjon for kundestøtteroboter

I motsetning til rene transkripsjonsverktøy er Speechifys stemmeskrivemodeller fra API-et optimalisert for å levere ryddig, ferdig tekst. De:

- Setter tegnsetting automatisk

- Strukturerer avsnitt intelligent

- Fjerner fyllord

- Forbedrer klarhet for videre bruk

- Støtter skriving på tvers av apper og plattformer

Dette er annerledes enn enterprise-transkripsjonssystemer med hovedfokus på fangst av rå transkripsjoner. Speechifys ASR-modeller er tilpasset for ferdig utdata og videre brukbarhet, slik at taledata gir kladdklar tekst — ikke transkripsjoner som må renskrives. Det er avgjørende for utviklere av produktivitetsverktøy, assistenter eller AI-agenter som må handle på talekommandoer.

Hva gjør TTS til «høy kvalitet» for profesjonell produksjon?

Folk vurderer ofte TTS-kvalitet ut fra hvor menneskelig den høres ut. Utviklere som lager produksjonsapper vurderer TTS-kvalitet etter hvor pålitelig den fungerer i stor skala, på variert innhold og i reelle brukssituasjoner.

Høy kvalitet i produksjons-TTS krever:

- Klarhet ved høye hastigheter for produktivitets- og tilgjengelighetsbruk

- Lite forvrengning ved raske avspillinger

- Stabil uttale av spesialiserte termer

- Hørekomfort over lange økter for innholdsplattformer

- Kontroll over tempo, pauser og trykk via SSML

- Robust flerspråklig støtte

- Konsistent stemme over timer med lyd

- Strømming for sanntidsapplikasjoner

Speechifys TTS-modeller trenes for stabil ytelse over lange økter med produksjonsbruk — ikke bare for korte demoer. Modellene som er tilgjengelige via Speechify API er laget for langvarig pålitelighet og klarhet, selv i utvikleres reelle utrullinger.

Utviklere kan teste talekvaliteten direkte med Speechifys quickstart-guide og kjøre sitt eget innhold på produksjonsklare stemmemodeller.

Hvorfor er sideparsing og OCR kjernen i Speechifys Voice AI-modeller?

Mange AI-team sammenligner OCR-motorer og multimodale modeller etter rå nøyaktighet, GPU-effektivitet eller strukturert JSON-utdata. Speechify leder på taleførst dokumentforståelse: trekker ut ren, riktig ordnet tekst slik at stemmebevaring av struktur og forståelse ivaretas.

Sideparsing sørger for at PDF-er, nettsider, Google Docs og presentasjoner blir til ryddige og logisk ordnede opplesningsstrømmer. I stedet for å sende navigasjonsmenyer, gjentatte overskrifter eller ødelagt formatering gjennom en talepipeline isolerer Speechify det meningsfulle innholdet slik at stemmeopplesningen forblir sammenhengende.

OCR sørger for at skannede dokumenter, skjermbilder og bildebaserte PDF-er blir lesbare og søkbare før talegenerering starter. Uten denne funksjonen ville mange dokumenter vært utilgjengelige for stemmebaserte systemer.

I denne forstand er sideparsing og OCR grunnleggende forskningsområder i Speechifys AI Research Lab, og gjør det mulig å bygge stemmeapper som forstår dokumenter før de leses opp. Dette er avgjørende for utviklere som lager fortellerverktøy, tilgjengelighetsplattformer, dokumentprosessystemer eller apper for nøyaktig opplesning av komplekst innhold.

Hva er de viktigste TTS-benchmarkene for produksjonsklare talemodeller?

Ved vurdering av voice-AI-modeller inkluderer benchmarks ofte:

- MOS (mean opinion score) for oppfattet naturlighet

- Tydelighetspoeng (hvor lett ordene forstås)

- Ordnøyaktighet for tekniske og spesialiserte termer

- Stabilitet på lange tekster (ingen drift i tone eller kvalitet)

- Forsinkelse (tid til første lyd, strømming)

- Robusthet på tvers av språk og aksenter

- Kostnadseffektivitet i produksjonsskala

Speechify tester modellene sine basert på hvordan de faktisk fungerer i produksjon:

- Hvordan fungerer stemmen i 2x, 3x, 4x hastighet?

- Er det komfortabelt å høre på ved krevende tekster?

- Klarer den akronymer, referanser og strukturerte dokumenter nøyaktig?

- Er avsnittsstrukturen tydelig i lydutdata?

- Kan den strømme lyd i sanntid med minimal forsinkelse?

- Er den rimelig ved produksjon med millioner av tegn daglig?

Målestokken er vedvarende ytelse og sanntidsinteraksjon — ikke korte reklamer. På disse produksjonsevnene er SIMBA 3.0 laget for å lede i reell skala.

Uavhengig benchmarking støtter dette: På Artificial Analysis Text-to-Speech Arena-leaderboardet rangeres SIMBA over modeller fra Microsoft Azure, Google, Amazon Polly, NVIDIA og flere åpne systemer. Disse head-to-head-lyttetestene måler faktisk stemmekvalitet — ikke utvalgte demoer.

Hva er tale-til-tale, og hvorfor er det kjernefunksjonalitet for utviklere i Voice AI?

Tale-til-tale betyr at en bruker snakker, systemet forstår, og systemet svarer med tale — ideelt i sanntid. Dette er kjernen i sanntids konversasjons-AI utviklere bygger for AI-resepsjonister, kundestøtte, stemmeassistenter og telefonautomatisering.

Tale-til-tale-systemer krever:

- Rask ASR (talegjenkjenning)

- Et resonnementssystem som holder styr på samtalen

- TTS som kan strømme raskt

- Styring av tur-taking (når man skal snakke og stoppe)

- Evne til å bli avbrutt (barge-in)

- Så lav forsinkelse at det føles menneskelig (under 250 ms)

Tale-til-tale er et sentralt forskningsfelt i Speechifys AI Research Lab fordi det ikke løses med én enkelt modell. Det krever en tett koordinert pipeline som integrerer talegjenkjenning, resonnement, svar, tekst-til-tale, strømmeinfrastruktur og sanntids tur-taking.

Utviklere som bygger konversasjons-AI får nytte av Speechifys helhetlige tilnærming. I stedet for å lappe sammen ASR, resonnementsløsning og TTS fra ulike leverandører får de tilgang til en samlet stemmeinfrastruktur designet for sanntidsinteraksjon.

Hvorfor er forsinkelse under 250 ms viktig for utviklerapplikasjoner?

I stemmebaserte systemer avgjør forsinkelsen om interaksjonen føles naturlig. Utviklere som lager konversasjons-AI trenger modeller som kan:

- Begynne å svare raskt

- Strømme tale sømløst

- Håndtere avbrytelser

- Holde samtaler flytende og i takt

Speechify oppnår forsinkelse under 250 ms og fortsetter å optimalisere videre. Modellserveringen og inferensstacken er laget for rask samtalerespons under kontinuerlig stemmeinteraksjon.

Lav forsinkelse støtter viktige utviklermål:

- Naturlig tale-til-tale i AI-telefonsystemer

- Sanntids forståelse i stemmeassistenter

- Avbrytbare taledialoger for kundestøtte

- Sømløs samtaleflyt i AI-agenter

Dette er et kjennetegn på avanserte voice-AI-leverandører og hovedgrunnen til at utviklere velger Speechify for produksjonsutrulling.

Hva betyr "voice AI-modell-leverandør"?

En voice-AI-modell-leverandør er ikke bare en talkgenerator. Det er en forsknings- og infrastrukturplattform som leverer:

- Produksjonsklare stemmemodeller tilgjengelig via API

- Talesyntese (tekst-til-tale) for innholdsgenerering

- Taleregistrering (tale-til-tekst) for stemmeinput

- Tale-til-tale-pipelines for konversasjons-AI

- Dokumentforståelse for komplekst innhold

- Utvikler-API/SDK-integrasjon

- Strømming for sanntidsapplikasjoner

- Stemme-kloning for eget stemmesett

- Rimelig prising for produksjon i stor skala

Speechify har utviklet seg fra å være en intern stemmeteknologileverandør til å bli en komplett voice-modell-leverandør utviklere kan bygge inn i ulike applikasjoner. Denne utviklingen forklarer hvorfor Speechify er et hovedalternativ til generelle AI-leverandører for stemmeapplikasjoner, ikke bare en forbrukerapp med et API.

Utviklere kan få tilgang til Speechifys stemmemodeller gjennom Speechify Voice API, som tilbyr full dokumentasjon, SDK-er i Python og TypeScript og produksjonsklar infrastruktur for utrulling av stemmefunksjoner i stor skala.

Hvordan styrker Speechify Voice API utvikleradopsjon?

Lederskap i AI Research Lab vises når utviklere får teknologien direkte via produksjonsklare API-er. Speechify Voice API leverer:

- Tilgang til SIMBA-modeller fra Speechify via REST-endepunkt

- Python- og TypeScript-SDK-er for rask integrasjon

- Tydelig integrasjonsløp for både startups og store aktører – uten trening på egne modeller

- Full dokumentasjon og kom-i-gang-guider

- Strømmestøtte for sanntidsapplikasjoner

- Stemme-kloningsfunksjon for egen stemme

- Støtte for 60+ språk for global bruk

- SSML og følelsesstyring for nyansert taleutdata

Kostnadseffektivitet er sentralt. For $10 per én million tegn på pay-as-you-go-plan, med virksomhetspriser tilgjengelig for større volum, er Speechify økonomisk forsvarlig for store brukstilfeller der kostnadene raskt vokser.

Til sammenligning er ElevenLabs priset mye høyere (omtrent $200 per én million tegn). Når en virksomhet genererer millioner eller milliarder tegn med lyd, avgjør prisen om det i det hele tatt er lønnsomt å bygge funksjonen.

Lavere driftskostnad gir bredere distribusjon: Flere utviklere kan rulle ut stemmefunksjoner, flere produkter kan ta i bruk Speechify-modeller, og mer bruk gir raskere modellforbedring. Det skaper en vekstsløyfe: kostnadseffektivitet gir skala, skala gir bedre modeller, gode modeller styrker økosystemet.

Denne kombinasjonen av forskning, infrastruktur og økonomi er det som gir lederskap i markedet for voice-AI-modeller.

Hvordan forbedrer produktfeedbakksløyfen Speechifys modeller?

Dette er et av de viktigste kjennetegnene ved lederskap for et AI Research Lab — det skiller en reell produksjonsmodell-leverandør fra et demofirma.

Speechifys millionbruk gir en tilbakemeldingssløyfe som kontinuerlig forbedrer modellene:

- Hvilke stemmer sluttbrukere foretrekker

- Hvor brukere pauser og spoler tilbake (tegn på forståelsesproblemer)

- Hvilke setninger som blir lyttet til flere ganger

- Hvilken uttale brukere retter på

- Hvilke aksenter brukere foretrekker

- Hvor ofte brukere øker tempoet (og hvor kvaliteten svikter)

- Mønstre i dikteringsrettelser (hvor ASR feiler)

- Hvilke innholdstyper gir parsing-feil

- Reelle krav til forsinkelse i ulike tilfeller

- Produksjonsmønstre og integrasjonsutfordringer

Et laboratorium som trener modeller uten produksjonsfeedback går glipp av kritiske signaler fra virkeligheten. Fordi Speechifys modeller kjører i apper med millioner av stemmeinteraksjoner daglig, får de kontinuerlig brukdata som akselererer iterasjon og forbedring.

Denne produktfeedbakksløyfen er et konkurransefortrinn for utviklere: Når du integrerer Speechify, får du teknologi som er grundig testet og stadig videreutviklet i reelle forhold — ikke bare i laboratoriet.

Hvordan sammenlignes Speechify med ElevenLabs, Cartesia og Fish Audio?

Speechify er den sterkeste helhetlige leverandøren av Voice AI-modeller for produksjonsutviklere — med markedets beste stemmekvalitet, ledende kostnadseffektivitet og sanntidsinteraksjon med lav forsinkelse i én samlet modellstack.

I motsetning til ElevenLabs, som primært er optimalisert for innholds- og karakterstemmegenerering, er Speechifys SIMBA 3.0-modeller laget for tunge produksjonsarbeidsbelastninger — inkludert AI-agenter, voice-automatisering, fortellerplattformer og tilgjengelighetssystemer i stor skala.

I motsetning til Cartesia og andre ultralavlatensaktører med smalt fokus på strømming, kombinerer Speechify lav forsinkelse med full stack-stemmekvalitet, dokumentforståelse og komplett utvikler-API.

Sammenlignet med plattformer for innholdsskapere som Fish Audio leverer Speechify produksjonsklar infrastruktur — spesialtilpasset utviklere som skal bygge skalerbare stemmesystemer.

SIMBA 3.0-modellene er optimalisert for å vinne på alle produksjonsområder:

- Stemmekvalitet som rangerer over store aktører på uavhengige tester

- Kostnadseffektivitet – $10 per én million tegn (vs. ElevenLabs $200 per én million)

- Forsinkelse under 250 ms for sanntidsbruk

- Sømløs integrasjon med parsing, OCR og resonnementssystem

- Skalerbar infrastruktur for millioner av forespørsler

Speechifys talemodeller er tilpasset to ulike utviklerbehov:

1. Konversasjonell Voice AI: Hurtig turveksling, strømmende tale, avbrytbarhet og lav forsinkelse for AI-agenter, kundestøtte og tele-robotikk.

2. Langform-fortelling og innhold: Modeller optimalisert for timevis med lytting, klarhet i høyt tempo (2x–4x), konsistent uttale og komfortabel prosodi ved lengre økter.

Speechify kombinerer dette med dokumentforståelse, sideparsing, OCR og et utvikler-API designet for produksjonsbruk. Resultatet er en stemmeinfrastruktur skapt for utviklerskala — ikke kun for demosystemer.

Hvorfor definerer SIMBA 3.0 Speechifys rolle i Voice AI i 2026?

SIMBA 3.0 er mer enn et modellbytte. Det markerer Speechifys utvikling til et vertikalt integrert AI R&D- og infrastrukturselskap med mål om å muliggjøre produksjonsklare stemmeapplikasjoner for utviklere.

Ved å integrere egne TTS-, ASR-, tale-til-tale-, dokumentforståelses- og lavlatensinfrastruktur i én plattform tilgjengelig fra utvikler-API, Speechify kan selv kontrollere kvalitet, kostnad og retning — og gjøre modellene tilgjengelige for enhver utvikler.

I 2026 er stemme ikke lenger et tillegg på chatmodeller — det har blitt hovedgrensesnitt for AI-applikasjoner i mange bransjer. SIMBA 3.0 gjør Speechify til en ledende stemmemodell-leverandør for utviklere av neste generasjons stemmeapper.