Speechify anuncia o lançamento antecipado do SIMBA 3.0, sua mais nova geração de modelos de voz IA para produção, agora disponível para desenvolvedores selecionados por meio da Speechify Voice API, com disponibilidade geral completa prevista para março de 2026. Construído pelo Laboratório de Pesquisa em IA da Speechify, o SIMBA 3.0 oferece recursos avançados de leitura em voz alta, reconhecimento de voz e conversão de fala para fala, que os desenvolvedores podem integrar diretamente em seus próprios produtos e plataformas.

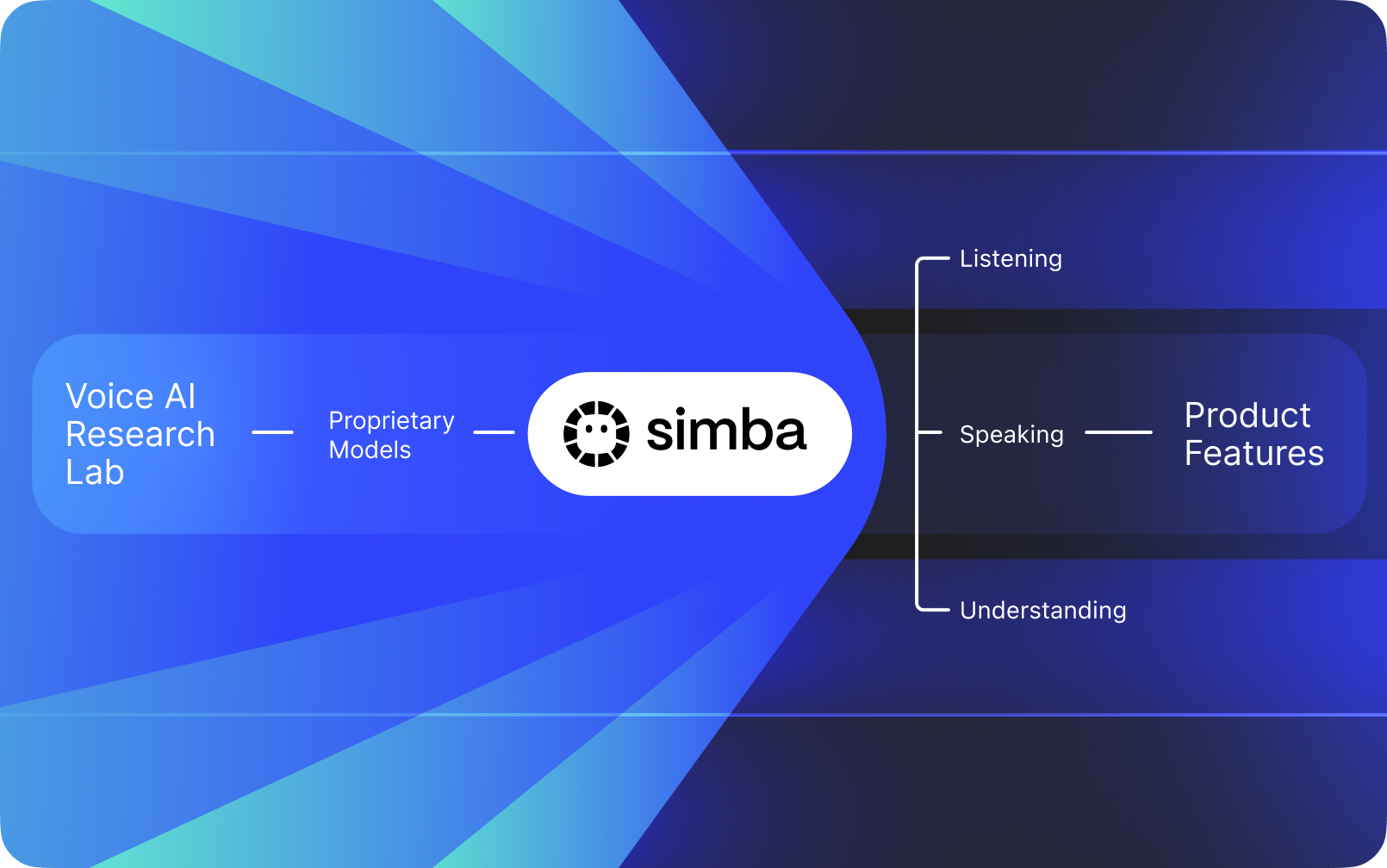

A Speechify não é apenas uma interface de voz conectada a IA de outras empresas. Ela opera seu próprio Laboratório de Pesquisa em IA dedicado à criação de modelos de voz proprietários. Esses modelos são comercializados para desenvolvedores e empresas de terceiros por meio da API da Speechify, podendo ser integrados em qualquer aplicação, desde recepcionistas IA e bots de atendimento a clientes até plataformas de conteúdo e ferramentas de acessibilidade.

A Speechify também utiliza esses mesmos modelos para impulsionar seus próprios produtos de consumo, além de fornecer acesso a desenvolvedores através da Speechify Voice API. Isso é importante porque a qualidade, latência, custo e direcionamento a longo prazo dos modelos de voz da Speechify são controlados por sua própria equipe de pesquisa, e não por fornecedores externos.

Os modelos de voz da Speechify são projetados especificamente para cargas de trabalho de voz em produção, oferecendo qualidade de modelo líder de mercado em grande escala. Desenvolvedores de terceiros acessam o SIMBA 3.0 e modelos de voz da Speechify diretamente pela Voice API, com endpoints REST para produção, documentação completa, guias de início rápido para desenvolvedores e SDKs oficiais para Python e TypeScript. A plataforma da Speechify foi criada para integração rápida, implantação em produção e infraestrutura de voz escalável, permitindo que equipes evoluam de um teste inicial da API a recursos de voz ao vivo em pouco tempo.

Este artigo explica o que é o SIMBA 3.0, o que o Speechify Laboratório de Pesquisa em IA desenvolve e por que a Speechify oferece modelos de voz IA de alta qualidade, baixa latência e excelente relação custo-benefício para workloads de produção de desenvolvedores, tornando-se referência no segmento – superando outros provedores de IA de voz e IA multimodal como OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia e Deepgram.

O Que Significa Chamar a Speechify de Laboratório de Pesquisa em IA?

Um laboratório de Inteligência Artificial é uma organização de pesquisa e engenharia dedicada, onde especialistas em aprendizado de máquina, dados e modelagem computacional trabalham juntos para projetar, treinar e implementar sistemas inteligentes avançados. Quando falamos em "Laboratório de Pesquisa em IA", normalmente nos referimos a uma organização que faz duas coisas simultaneamente:

1. Desenvolve e treina seus próprios modelos

2. Disponibiliza esses modelos para desenvolvedores por meio de APIs e SDKs para produção

Algumas organizações são excelentes em criar modelos, mas não os liberam para desenvolvedores externos. Outras oferecem APIs, porém dependem majoritariamente de modelos de terceiros. A Speechify opera uma stack de voz IA totalmente integrada — ela constrói seus próprios modelos de voz IA e os disponibiliza para desenvolvedores terceiros via APIs de produção, além de utilizá-los em seus próprios aplicativos de consumo para validar o desempenho do modelo em escala.

O Laboratório de Pesquisa em IA da Speechify é uma organização interna de pesquisa focada em inteligência de voz. Sua missão é avançar em leitura em voz alta, reconhecimento automático de fala e sistemas de conversão de fala para fala para que desenvolvedores possam criar aplicações "voice-first" para qualquer caso de uso – desde recepcionistas IA e agentes de voz até motores de narração e ferramentas de acessibilidade.

Um verdadeiro laboratório de pesquisa em IA de voz normalmente precisa resolver desafios como:

- Leitura em voz alta com qualidade e naturalidade para uso em produção

- Reconhecimento de fala e precisão de ASR em diferentes sotaques e ruídos

- Baixa latência em tempo real para agentes conversacionais IA

- Estabilidade em textos extensos para experiências de escuta prolongada

- Compreensão de documentos para processar PDFs, páginas web e conteúdos estruturados

- OCR e análise de página para documentos e imagens digitalizadas

- Ciclo de feedback de produto para aprimorar modelos ao longo do tempo

- Infraestrutura para desenvolvedores, expondo recursos de voz via APIs e SDKs

O Laboratório de Pesquisa em IA da Speechify constrói esses sistemas em uma arquitetura unificada e os torna acessíveis aos desenvolvedores pela Speechify Voice API, disponível para integração com terceiros em qualquer plataforma ou aplicação.

O Que é o SIMBA 3.0?

SIMBA é a linha proprietária de modelos de voz IA da Speechify, que impulsiona os próprios produtos da empresa e também é comercializada para desenvolvedores terceiros via API Speechify. O SIMBA 3.0 é a geração mais recente, otimizada para desempenho, velocidade e interatividade em tempo real em contextos "voice-first" e disponível para integração de terceiros em suas próprias plataformas.

O SIMBA 3.0 foi desenvolvido para fornecer alta qualidade de voz, resposta com baixa latência e estabilidade para escuta de longa duração em escala de produção, permitindo que desenvolvedores criem aplicações profissionais de voz para diferentes setores.

Para desenvolvedores terceiros, o SIMBA 3.0 possibilita casos de uso como:

- Agentes de voz IA e sistemas conversacionais

- Automação de suporte ao cliente e recepcionistas IA

- Sistemas de chamadas ativas para vendas e serviços

- Assistentes de voz e aplicações de fala para fala

- Narração de conteúdo e geração de audiolivros

- Ferramentas de acessibilidade e tecnologia assistiva

- Plataformas educacionais com aprendizagem por voz

- Aplicações de saúde que exigem interação de voz empática

- Aplicativos de tradução e comunicação multilíngue

- Sistemas IoT e automotivos ativados por voz

Quando usuários dizem que uma voz "soa humana", eles se referem a diversos elementos técnicos funcionando juntos:

- Prosódia (ritmo, entonação, ênfase)

- Ritmo ajustado ao significado

- Pausas naturais

- Pronúncia estável

- Mudanças de entonação alinhadas à estrutura sintática

- Neutralidade emocional quando apropriado

- Expressividade quando útil

O SIMBA 3.0 é a camada de modelo que os desenvolvedores integram para que experiências de voz continuem naturais mesmo em alta velocidade, sessões longas e variados tipos de conteúdo. Para workloads de voz em produção, de sistemas telefônicos IA a plataformas de conteúdo, o SIMBA 3.0 é otimizado para superar camadas de voz genéricas.

Como a Speechify Utiliza SSML para Controle Preciso da Voz?

A Speechify oferece suporte ao Speech Synthesis Markup Language (SSML), possibilitando que desenvolvedores controlem com precisão como a fala sintetizada será reproduzida. O SSML permite ajuste de tom, velocidade da fala, pausas, ênfase e estilo envolvendo o conteúdo em tags <speak> e utilizando tags suportadas como prosody, break, emphasis e substitution. Isso dá às equipes controle detalhado sobre a entrega e a estrutura, ajudando a saída de voz a se alinhar melhor ao contexto, formatação e intenção em aplicativos de produção.

Como a Speechify Possibilita Transmissão de Áudio em Tempo Real?

A Speechify oferece um endpoint de leitura em voz alta via streaming que entrega o áudio em blocos assim que ele é gerado, permitindo a reprodução imediata sem esperar o áudio completo. Isso atende a casos de uso de longa duração e baixa latência, como agentes de voz, tecnologia assistiva, geração automatizada de podcasts e produção de audiolivros. Desenvolvedores podem transmitir grandes entradas além dos limites padrões e receber blocos de áudio bruto nos formatos MP3, OGG, AAC e PCM para integração rápida em sistemas de tempo real.

Como as Speech Marks Sincronizam Texto e Áudio na Speechify?

Speech marks vinculam o áudio falado ao texto original com dados de tempo a nível de palavra. Cada resposta de síntese traz trechos de texto alinhados ao tempo, mostrando onde palavras específicas começam e terminam no fluxo de áudio. Isso permite destaque de texto em tempo real, busca precisa por palavra ou frase, análise de uso e sincronização perfeita entre texto na tela e reprodução. Desenvolvedores podem usar essa estrutura para criar leitores acessíveis, ferramentas de aprendizado e experiências de escuta interativas.

Como a Speechify Suporta Expressão Emocional na Fala Sintetizada?

A Speechify possui Controle de Emoção via uma tag de estilo SSML dedicada, permitindo que desenvolvedores atribuam tons emocionais à fala sintetizada. As emoções suportadas incluem opções como alegre, calmo, assertivo, enérgico, triste e irritado. Combinando essas tags com pontuação e outros controles SSML, é possível produzir fala que corresponda melhor à intenção e ao contexto. Isso é especialmente útil para agentes de voz, aplicativos de bem-estar, fluxos de suporte ao cliente e conteúdos guiados, onde o tom influencia diretamente a experiência do usuário.

Casos de Uso Reais dos Modelos de Voz Speechify por Desenvolvedores

Os modelos de voz da Speechify impulsionam aplicações de produção em setores diversos. Veja exemplos reais de como desenvolvedores de terceiros estão usando a API da Speechify:

MoodMesh: Aplicativos de Bem-Estar com Inteligência Emocional

MoodMesh, uma empresa de tecnologia de bem-estar, integrou a Speechify Text-to-Speech API para oferecer falas emocionalmente ricas em meditações guiadas e conversas compassivas. Ao utilizar os recursos de SSML e controle de emoção da Speechify, o MoodMesh ajusta tom, cadência, volume e velocidade da fala conforme o contexto emocional dos usuários, criando interações muito mais humanas do que um TTS padrão. Isso mostra como desenvolvedores utilizamSpeechify modelos para criar aplicações sofisticadas que exigem inteligência emocional e percepção de contexto.

AnyLingo: Comunicação e Tradução Multilíngue

AnyLingo, um aplicativo de tradução em tempo real, utiliza a API de clonagem de voz da Speechify para permitir que usuários enviem mensagens de voz com uma versão clonada de sua própria voz, traduzida para o idioma do destinatário com inflexão, tom e contexto corretos. A integração permite a profissionais de negócios se comunicarem com eficiência em diferentes idiomas, mantendo o toque pessoal da própria voz. O fundador da AnyLingo destaca que os controles de emoção (“Moods”) da Speechify são grandes diferenciais, permitindo mensagens que combinam o tom emocional apropriado para cada situação.

Outros Casos de Uso por Desenvolvedores Terceirizados:

IA Conversacional e Agentes de Voz

Desenvolvedores que constroem recepcionistas IA, bots de atendimento ao cliente e sistemas de automação de vendas utilizam os modelos de fala para fala em baixa latência da Speechify para criar interações de voz naturais. Com latência abaixo de 250ms e capacidade de clonagem de voz, essas aplicações podem escalar para milhões de chamadas simultâneas mantendo qualidade de voz e fluidez conversacional.

Plataformas de Conteúdo e Geração de Audiolivros

Editoras, autores e plataformas educacionais integram modelos da Speechify para converter conteúdo escrito em narração de alta qualidade. A estabilidade em textos longos e clareza de reprodução rápida dos modelos faz deles a escolha ideal para gerar audiolivros, conteúdos de podcasts e materiais didáticos em grande escala.

Acessibilidade e Tecnologia Assistiva

Desenvolvedores de ferramentas para pessoas com deficiência visual ou transtornos de leitura confiam na capacidade da Speechify de entender documentos, incluindo análise de PDFs, OCR e extração de páginas web, garantindo que a saída de voz preserve a estrutura e a compreensão em documentos complexos.

Aplicações de Saúde e Terapia

Plataformas médicas e aplicativos terapêuticos usam o controle de emoção e recursos de prosódia da Speechify para oferecer interações de voz empáticas e contextualmente adequadas: fator crítico para comunicação com pacientes, suporte de saúde mental e apps de bem-estar.

Como o SIMBA 3.0 se Sai em Rankings Independentes de Modelo de Voz?

Benchmarks independentes importam em IA de voz porque demonstrações curtas podem esconder lacunas de desempenho. Um dos benchmarks de terceiros mais citados é o Artificial Analysis Speech Arena, que avalia modelos de leitura em voz alta usando comparativos de escuta às cegas em larga escala e pontuação ELO.

Os modelos de voz SIMBA da Speechify ficam acima de diversos grandes provedores nesse ranking, incluindo Microsoft Azure Neural, modelos Google TTS, Amazon Polly, NVIDIA Magpie e diversos sistemas de voz open-weight.

Em vez de exemplos selecionados, o Artificial Analysis usa testes repetidos de preferência de ouvintes, frente a frente, com muitas amostras. Esse ranking reforça que o SIMBA supera amplamente sistemas comerciais de voz, liderando em qualidade real de modelo em situações de uso prático e tornando-se a melhor escolha pronta para produção para desenvolvedores que querem aplicações com voz nativa.

Por Que a Speechify Cria Seus Próprios Modelos de Voz em vez de Usar Sistemas de Terceiros?

Ter controle sobre o modelo significa ter controle sobre:

- Qualidade

- Latência

- Custo

- Evolução do roadmap

- Prioridades de otimização

Quando empresas como Retell ou Vapi.ai dependem totalmente de provedores de voz de terceiros, passam a herdar estrutura de preços, limitações de infraestrutura e direcionamento de pesquisa desses fornecedores.

Ao possuir toda a stack, a Speechify pode:

- Ajustar prosódia para cenários específicos (IA conversacional vs. narração longa)

- Otimizar latência abaixo de 250ms para aplicações em tempo real

- Integrar ASR e leitura em voz alta em pipelines de fala para fala

- Reduzir o custo por caractere para US$ 10 a cada 1M caracteres (em comparação ao ElevenLabs, cerca de US$ 200 por 1M caracteres)

- Lançar melhorias de modelo continuamente, com base no feedback real

- Sincronizar evolução do modelo com as necessidades dos desenvolvedores em diferentes setores

Esse controle de stack completo permite à Speechify entregar modelos de voz com qualidade superior, menor latência e melhor economia do que stacks dependentes de terceiros. Esses fatores são fundamentais para desenvolvedores que desejam escalar aplicações de voz. As mesmas vantagens são oferecidas para quem integra a API da Speechify em seus produtos.

A infraestrutura da Speechify é construída desde o início para voz, e não como uma camada de voz adicionada por cima de sistemas orientados a chat. Desenvolvedores terceiros integrando modelos Speechify acessam uma arquitetura nativa de voz otimizada para produção.

Como a Speechify Apoia Voz IA On-Device e Inferência Local?

Muitos sistemas de voz IA rodam exclusivamente por APIs remotas, gerando dependência de rede, maior risco de latência e restrições de privacidade. A Speechify oferece opções de inferência local e on-device para cargas de trabalho selecionadas de voz, permitindo que desenvolvedores implementem experiências de voz próximas do usuário quando necessário.

Como cria seus próprios modelos de voz, a Speechify consegue otimizar tamanho dos modelos, arquitetura de entrega e rotas de inferência para execução em dispositivos, não apenas na nuvem.

Inferência local e on-device oferece:

- Latência menor e mais estável mesmo em redes variáveis

- Maior controle de privacidade para documentos sensíveis e ditado

- Usabilidade offline ou em redes instáveis para fluxos essenciais

- Mais flexibilidade de implantação para empresas e dispositivos embarcados

Isso expande a Speechify do "voz só via API" para infraestrutura de voz que pode ser implantada em nuvem, local ou dispositivo, mantendo o padrão SIMBA de modelo.

Como a Speechify se Compara à Deepgram em ASR e Infraestrutura de Voz?

Deepgram é uma fornecedora de infraestrutura ASR voltada para transcrição e APIs de análise de fala. Seu produto principal gera transcrição de voz para desenvolvedores que constroem sistemas de transcrição e análise de chamadas.

A Speechify integra ASR em uma família abrangente de modelos IA de voz, onde o reconhecimento da fala pode gerar múltiplos resultados, desde transcrições brutas até textos finalizados ou respostas conversacionais. Desenvolvedores usando a Speechify API têm acesso a modelos ASR otimizados para diferentes usos, não só acurácia de transcrição.

Os modelos de ASR e ditado da Speechify são otimizados para:

- Qualidade de texto finalizado com pontuação e parágrafo

- Remoção de palavras desnecessárias e estrutura das frases

- Texto pronto para rascunho de e-mails, documentos e anotações

- Digitação por voz que produz resultados limpos e com mínima necessidade de edição

- Integração com fluxos de voz (leitura em voz alta, conversação, raciocínio)

Na plataforma Speechify, ASR integra toda a jornada de voz. Desenvolvedores podem criar apps onde o usuário dita, recebe texto estruturado, gera áudio-resposta e processa conversas: tudo no ecossistema da mesma API, reduzindo a complexidade de integração e acelerando o desenvolvimento.

Deepgram oferece uma camada de transcrição. Speechify oferece toda uma suíte de voz: entrada de fala, saída estruturada, síntese, raciocínio e geração de áudio acessível via APIs e SDKs unificados para desenvolvedores.

Para desenvolvedores criando aplicações impulsionadas por voz que precisam de recursos completos de fala, a Speechify é, de longe, a melhor opção em qualidade, latência e profundidade de integração.

Como a Speechify Se Compara à OpenAI, Gemini e Anthropic em Voz IA?

A Speechify desenvolve modelos de IA voltados especificamente para interação de voz em tempo real, síntese para produção em massa e fluxos de reconhecimento de fala. Seus modelos centrais são projetados para desempenho de voz, não para interação geral via chat ou texto.

A especialidade da Speechify é desenvolvimento de IA de voz, e o SIMBA 3.0 é otimizado visando qualidade vocal, baixa latência e estabilidade em uso prolongado, em cenários reais de produção. O SIMBA 3.0 foi criado para entregar qualidade de voz em padrão de produção e interação em tempo real para integração direta em aplicações de desenvolvedores.

Laboratórios de IA generalistas como OpenAI e Google Gemini otimizam seus modelos para tarefas de raciocínio abrangente, multimodalidade e inteligência geral. A Anthropic destaca segurança e modelagem de linguagem de contexto longo. Os recursos de voz funcionam como extensões de sistemas de chat, não como plataformas nativas de modelos de voz.

Para workloads de IA de voz, o que conta é qualidade do modelo, latência e estabilidade em longas sessões, e é aí que os modelos dedicados da Speechify superam os sistemas generalistas. Quem desenvolve sistemas de telefonia IA, agentes de voz, plataformas de narração ou ferramentas de acessibilidade precisa de modelos nativos de voz — não camadas de voz em cima de chatbots.

ChatGPT e Gemini oferecem modos de voz, mas sua interface principal permanece baseada em texto. A voz funciona como uma camada de entrada e saída sobre o chat, não sendo otimizada para qualidade sustentada de escuta, precisão de ditado ou desempenho em fala em tempo real.

A Speechify é construída para voz desde o nível do modelo. Desenvolvedores têm acesso a modelos feitos sob medida para fluxos contínuos de voz, sem trocar modo de interação ou perder qualidade. A API Speechify expõe essas capacidades diretamente aos desenvolvedores via endpoints REST, SDKs para Python e TypeScript.

Esses recursos tornam a Speechify líder em modelos de voz para desenvolvedores que buscam interação em tempo real e aplicações de voz para produção.

No contexto de IA de voz, o SIMBA 3.0 é otimizado para:

- Prosódia em narração longa e entrega de conteúdo

- Latência de fala para fala em agentes de IA conversacional

- Qualidade de ditado para digitação por voz e transcrição

- Interação de voz consciente do documento, para processar conteúdos estruturados

Esses recursos fazem da Speechify uma fornecedora de IA de voz "voice-first" otimizada para integração de desenvolvedor e implantação em produção.

Quais são os Pilares Técnicos do Laboratório de IA da Speechify?

O Laboratório de Pesquisa em IA da Speechify é estruturado em torno dos sistemas técnicos centrais necessários para sustentar infraestrutura de voz IA de produção para desenvolvedores. Ele constrói os principais componentes de modelo para uma implantação completa de IA de voz:

- Modelos de leitura em voz alta (geração de voz) – Disponível via API

- Modelos STT & ASR (reconhecimento) – Integrados na plataforma de voz

- Fala para fala (pipelines conversacionais em tempo real) – Arquitetura de baixa latência

- Análise de página e compreensão de documentos – Para processar documentos complexos

- OCR (imagem para texto) – Para documentos e imagens digitalizadas

- LLM e camadas de conversação com raciocínio – Para interações inteligentes

- Infraestrutura para inferência de baixa latência – Tempos de resposta abaixo de 250ms

- Ferramentas de API e serving otimizado para custo – SDKs prontos para produção

Cada camada é otimizada para workloads de voz em produção, e a stack verticalmente integrada da Speechify garante alta qualidade de modelo e performance de baixa latência em toda a jornada de voz em escala. Desenvolvedores que integram esses modelos se beneficiam de uma arquitetura coesa em vez de "remendar" serviços isolados.

Cada camada faz diferença. Se alguma for fraca, toda a experiência de voz é comprometida. A abordagem da Speechify garante infraestrutura de voz completa para desenvolvedores, não apenas linhas isoladas de modelo.

Qual o Papel dos Modelos STT e ASR no Laboratório da Speechify?

Leitura para texto (STT) e reconhecimento automático de fala (ASR) são linhas centrais do portfólio de pesquisa da Speechify. Eles viabilizam casos de uso como:

- Digitação por voz e APIs de ditado

- IA conversacional em tempo real e agentes de voz

- Inteligência de reuniões e transcrição

- Pipelines de fala para fala para sistemas telefônicos IA

- Voz interativa multi-turn para bots de suporte ao cliente

Diferente de transcrições cruas, os modelos de digitação por voz da Speechify expostos via API são otimizados para escrita limpa. Eles:

- Inserem pontuação automaticamente

- Estruturam parágrafos de forma inteligente

- Removem palavras desnecessárias

- Melhoram a clareza para uso posterior

- Apoiam escrita multiplataforma

Isso difere dos sistemas de transcrição corporativa que focam na captura do texto apenas. Os modelos de ASR da Speechify são ajustados para qualidade de saída finalizada e usabilidade, resultando em conteúdo pronto para uso e não transcrições que pedem limpeza, essencial para quem desenvolve ferramentas de produtividade, assistentes de voz ou agentes IA que precisam agir sobre a fala do usuário.

O Que é TTS "de Alta Qualidade" para Produção?

A maioria das pessoas julga a qualidade de leitura em voz alta (TTS) por quão humana ela soa. Desenvolvedores, entretanto, avaliam a qualidade pelo desempenho confiável em escala, volume de conteúdo variado e cenários reais de produção.

Um TTS de alta qualidade em produção exige:

- Clareza em alta velocidade para produtividade e acessibilidade

- Baixa distorção em taxas rápidas de reprodução

- Estabilidade na pronúncia de termos técnicos

- Conforto auditivo ao longo de horas de reprodução

- Controle do ritmo, pausas e ênfase via SSML

- Saída robusta e multilíngue em diversos sotaques

- Consistência da identidade vocal em horas seguidas de áudio

- Capacidade de streaming para aplicações em tempo real

Os modelos de leitura em voz alta da Speechify são treinados para desempenho duradouro, mesmo em sessões longas e condições reais de produção — não só para demos curtas. Os modelos disponíveis na API Speechify são projetados para confiabilidade em sessões prolongadas e clareza em velocidades elevadas de reprodução em implantações reais.

Desenvolvedores podem testar a qualidade vocal integrando o guia rápido Speechify e rodando conteúdos reais nos modelos de voz em padrão de produção.

Por que Parsing de Página e OCR são Centrais para IA de Voz da Speechify?

Muitas equipes de IA comparam motores de OCR e modelos multimodais por acurácia, eficiência de GPU ou saída JSON. A Speechify lidera na compreensão de documentos focada em voz: extrai conteúdo limpo e ordenado para que a saída de voz preserve a estrutura e a compreensão.

Parsing de página garante que PDFs, páginas web, Google Docs e apresentações sejam convertidos em fluxos de leitura limpos e ordenados logicamente. Em vez de enviar menus de navegação, cabeçalhos repetidos e formatações confusas para a síntese de voz, a Speechify isola o conteúdo relevante para que a narração mantenha coerência.

O OCR garante que documentos digitalizados, capturas de tela e PDFs baseados em imagem fiquem legíveis e pesquisáveis antes da síntese de voz. Sem esse recurso, muitos tipos de documentos continuariam inacessíveis para sistemas de voz.

Por isso, parsing de página e OCR são áreas fundamentais de pesquisa dentro do Laboratório da Speechify, capacitando desenvolvedores a criar apps de voz que "entendem" documentos antes de falar. Isso é essencial para quem desenvolve ferramentas de narração, plataformas de acessibilidade, processamento documental ou qualquer app que precise vocalizar conteúdo complexo com precisão.

Quais Benchmarks Realmente Importam em Voz TTS para Produção?

Na avaliação de modelos de voz IA, benchmarks comuns incluem:

- MOS (mean opinion score) para naturalidade percebida

- Scores de inteligibilidade (facilidade de compreensão)

- Precisão em palavras técnicas e de domínio

- Estabilidade em passagens longas (sem alterações de tom ou qualidade)

- Latência (tempo até o primeiro áudio, comportamento de streaming)

- Robustez em idiomas e sotaques

- Eficiência de custo em larga escala

A Speechify avalia seus modelos com foco em realidade produtiva:

- Como a voz se comporta em 2x, 3x, 4x de velocidade?

- Permanece confortável lendo textos técnicos densos?

- Lida bem com siglas, citações e documentos estruturados?

- Mantém a estrutura de parágrafo no áudio?

- Consegue transmitir áudio em tempo real, com baixa latência?

- O custo permite uso em apps de milhões de caracteres diários?

O que importa é performance sustentada e capacidade de interação em tempo real, não apenas voz para um vídeo curto. O SIMBA 3.0 foi criado para liderar nesses benchmarks reais e em produção.

Benchmarks independentes confirmam esse perfil. No ranking Artificial Analysis Text-to-Speech Arena, o SIMBA da Speechify supera modelos amplamente usados como Microsoft Azure, Google, Amazon Polly, NVIDIA e várias opções open-weight. Essas comparações reais de preferência avaliam qualidade percebida em vez de demos selecionadas a dedo.

O Que é Fala para Fala e Por Que Isso é Essencial para Desenvolvedores?

Fala para fala significa que o usuário fala, o sistema entende e responde em voz — de preferência em tempo real. É o núcleo de sistemas IA conversacionais de voz, como recepcionistas IA, agentes de suporte, assistentes de voz e automação telefônica.

Sistemas de fala para fala exigem:

- ASR rápido (reconhecimento de fala)

- Sistema de raciocínio capaz de manter o estado da conversa

- Leitura em voz alta capaz de transmitir rapidamente

- Lógica de alternância de fala (quando começar/parar de falar)

- Capacidade de ser interrompido (barge-in)

- Latência humana (<250ms)

Fala para fala é área de pesquisa central no Laboratório de Pesquisa em IA da Speechify, pois não é resolvido com um modelo só. Exige um pipeline integrado, com reconhecimento de fala, raciocínio, resposta, leitura em voz alta, infraestrutura de streaming e turnos de fala em tempo real.

Desenvolvedores de IA conversacional se beneficiam do modelo integrado da Speechify: em vez de juntar ASR, raciocínio e TTS separados, eles acessam infraestrutura unificada já criada para interações em tempo real.

Por Que a Latência Menor que 250ms é Importante em Aplicações?

Em sistemas de voz, latência determina se a interação soa natural ou não. Desenvolvedores de IA conversacional precisam de modelos que consigam:

- Começar a resposta rapidamente

- Transmitir a fala perfeitamente

- Lidar com interrupções

- Manter o ritmo da conversa

A Speechify atinge latência menor que 250ms e segue otimizando para menos. Sua arquitetura de entrega e inferência foi projetada para resposta ágil em conversação por voz contínua.

Baixa latência viabiliza usos críticos:

- Interação fala para fala natural em telefonia IA

- Compreensão em tempo real em assistentes de voz

- Diálogo de voz interruptível em bots de suporte ao cliente

- Conversação fluida em IA conversacionais

Este é um diferencial dos provedores de IA de voz avançados e um dos principais motivos pelos quais os desenvolvedores escolhem a Speechify para implantações em produção.

O Que é um Provedor de Modelo de Voz IA?

Ser provedor de modelo de IA de voz não significa só ser um gerador de voz. É ser uma organização de pesquisa e uma infraestrutura que entrega:

- Modelos de voz prontos para produção por API

- Síntese de fala (leitura em voz alta) para gerar conteúdo

- Reconhecimento (fala para texto) para entrada de voz

- Pipelines de fala-para-fala para IA conversacional

- Inteligência de documentos para conteúdo complexo

- APIs e SDKs para integração

- Streaming para tempo real

- Clonagem de voz para vozes personalizadas

- Custo viável para escala de produção

A Speechify evoluiu de provedora de tecnologia interna de voz para ser um fornecedor de modelo de voz completo, que pode ser integrado a qualquer aplicação. Isso é fundamental para explicar por que a Speechify é alternativa real aos provedores de IA generalistas para usos de voz, e não só um app com API.

Desenvolvedores podem acessar os modelos de voz da Speechify através da Voice API da Speechify, que conta com documentação detalhada, SDKs em Python e TypeScript e infraestrutura pronta para produção para implantar recursos de voz em escala.

Como a API de Voz da Speechify Impulsiona a Adoção pelos Desenvolvedores?

A liderança em pesquisa IA é comprovada quando desenvolvedores podem acessar a tecnologia via APIs de produção. A Speechify Voice API oferece:

- Acesso aos modelos de voz SIMBA via endpoints REST

- SDKs para Python e TypeScript para integração rápida

- Caminho claro para startups e empresas criarem recursos de voz sem treinar modelos

- Documentação e guias de início rápido completos

- Suporte a streaming para aplicações em tempo real

- Recursos de clonagem de voz para criar vozes sob medida

- Mais de 60 idiomas para aplicações globais

- Controle SSML e de emoção para saída vocal refinada

Eficiência de custo é central aqui. Por US$ 10 por 1M de caracteres no plano pré-pago, com opções para grandes volumes empresariais, a Speechify é viável economicamente para usos em larga escala onde o custo pode crescer rapidamente.

A título de comparação, a ElevenLabs é muito mais cara (em torno de US$ 200 por 1M caracteres). Empresas que geram milhões ou bilhões de caracteres em áudio dependem do custo para viabilizar o recurso.

Custos de inferência mais baixos permitem ampla adoção: mais desenvolvedores conseguem lançar recursos de voz, mais produtos adotam modelos Speechify e mais uso reforça a melhoria dos modelos. Isso gera um ciclo virtuoso: escala melhora a qualidade, que por sua vez fortalece o ecossistema.

É essa combinação de pesquisa, infraestrutura e economia que define a liderança da Speechify no mercado de IA de voz.

Como o Ciclo de Feedback dos Produtos Melhora os Modelos da Speechify?

Esse é um dos pontos mais importantes na liderança de Laboratórios de Pesquisa em IA, pois diferencia um fornecedor de modelo de produção de uma empresa que só faz demos.

A escala da Speechify, atendendo milhões de usuários, viabiliza um ciclo de feedback que melhora continuamente a qualidade dos modelos:

- Quais vozes os usuários finais dos desenvolvedores preferem

- Onde usuários pausam e retrocedem (indícios de dificuldade de compreensão)

- Quais sentenças são ouvidas novamente

- Quais pronúncias são corrigidas pelo usuário

- Quais sotaques agradam mais

- Com que frequência aumentam a velocidade (e onde a qualidade cai)

- Padrões de correção de ditado (pontos onde o ASR falha)

- Quais tipos de conteúdo geram erros de parsing

- Requisitos reais de latência entre casos de uso

- Desafios na integração e padrões de implantação real

Um laboratório que treina modelos sem feedback de produção perde sinais críticos do uso real. Como os modelos da Speechify estão rodando em aplicações reais e processando milhões de interações diárias, eles se beneficiam de dados de uso contínuo, acelerando melhorias.

Esse ciclo de feedback de produção é uma vantagem competitiva para desenvolvedores: ao integrar modelos da Speechify, você adquire tecnologia testada e refinada em uso real, não apenas em laboratório.

Como a Speechify se Compara a ElevenLabs, Cartesia e Fish Audio?

A Speechify é o fornecedor de modelos IA de voz mais forte para produção, entregando voz de alto nível, custo líder no setor e interação em tempo real com baixa latência em uma stack unificada de modelo.

Diferente da ElevenLabs, focada em criação de vozes para criadores e personagens, os modelos SIMBA 3.0 da Speechify são otimizados para workloads de produção, como agentes IA, automação de voz, plataformas de narração e sistemas de acessibilidade em grande escala.

Diferente da Cartesia e outros especialistas ultra-low-latency focados em streaming, a Speechify combina performance de baixa latência à qualidade total de modelo de voz, inteligência documental e integração API para desenvolvedores.

Comparada a plataformas voltadas para criadores, como a Fish Audio, a Speechify entrega infraestrutura IA de voz pronta para produção, criada especificamente para desenvolvedores que desejam sistemas escaláveis e implantáveis.

Os modelos SIMBA 3.0 são otimizados para vencer em todas as dimensões que realmente importam em escala de produção:

- Qualidade vocal acima dos grandes provedores em benchmarks

- Custo de US$ 10 por 1M caracteres (vs. ElevenLabs, ~US$ 200)

- Latência abaixo de 250ms para tempo real

- Integração fluida com análise documental, OCR e sistemas de raciocínio

- Infraestrutura pronta para escalar a milhões de requisições

Os modelos de voz da Speechify são ajustados para dois cenários principais de desenvolvedores:

1. IA Conversacional em Voz: alternância de turnos rápida, fluxo de fala por streaming, interruptibilidade e interação fala-para-fala com baixa latência em agentes IA, bots e telefonia.

2. Narração longa e conteúdo: modelos otimizados para escuta prolongada por horas de conteúdo, clareza em velocidades de 2x a 4x, pronúncia consistente e prosódia confortável em sessões extensas.

A Speechify também combina esses modelos com inteligência de documentos, parsing de página, OCR e uma API criada para produção. O resultado é uma infraestrutura de voz de fato, pronta para escala – não um sistema de demonstração.

Por Que o SIMBA 3.0 Define o Papel da Speechify em Voz IA em 2026?

O SIMBA 3.0 vai além de uma simples atualização de modelo. Ele representa a evolução da Speechify para uma organização de pesquisa e infraestrutura integrada de IA de voz, focada em capacitar desenvolvedores a criar aplicações de voz para produção.

Unindo TTS proprietário, ASR, fala para fala, inteligência documental e infraestrutura de baixa latência numa plataforma unificada acessível por APIs para desenvolvedores, a Speechify controla a qualidade, custo e evolução dos modelos, tornando-os acessíveis para integração em qualquer app.

Em 2026, voz não é só um recurso extra em modelos de chat. Ela passa a ser interface principal de IA em todos os setores. O SIMBA 3.0 posiciona a Speechify como referência para desenvolvedores que constroem a nova geração de aplicações orientadas por voz.