Speechify 宣布提前推出 SIMBA 3.0——旗下新一代生產級語音 AI 模型,現已經由 Speechify Voice API 開放給特選第三方開發者搶先試用,預計將於 2026 年 3 月全面上市。SIMBA 3.0 由 Speechify AI 研究實驗室打造,提供高品質文字轉語音、語音辨識與語音轉語音功能,讓開發者能直接整合至自家產品或平台。

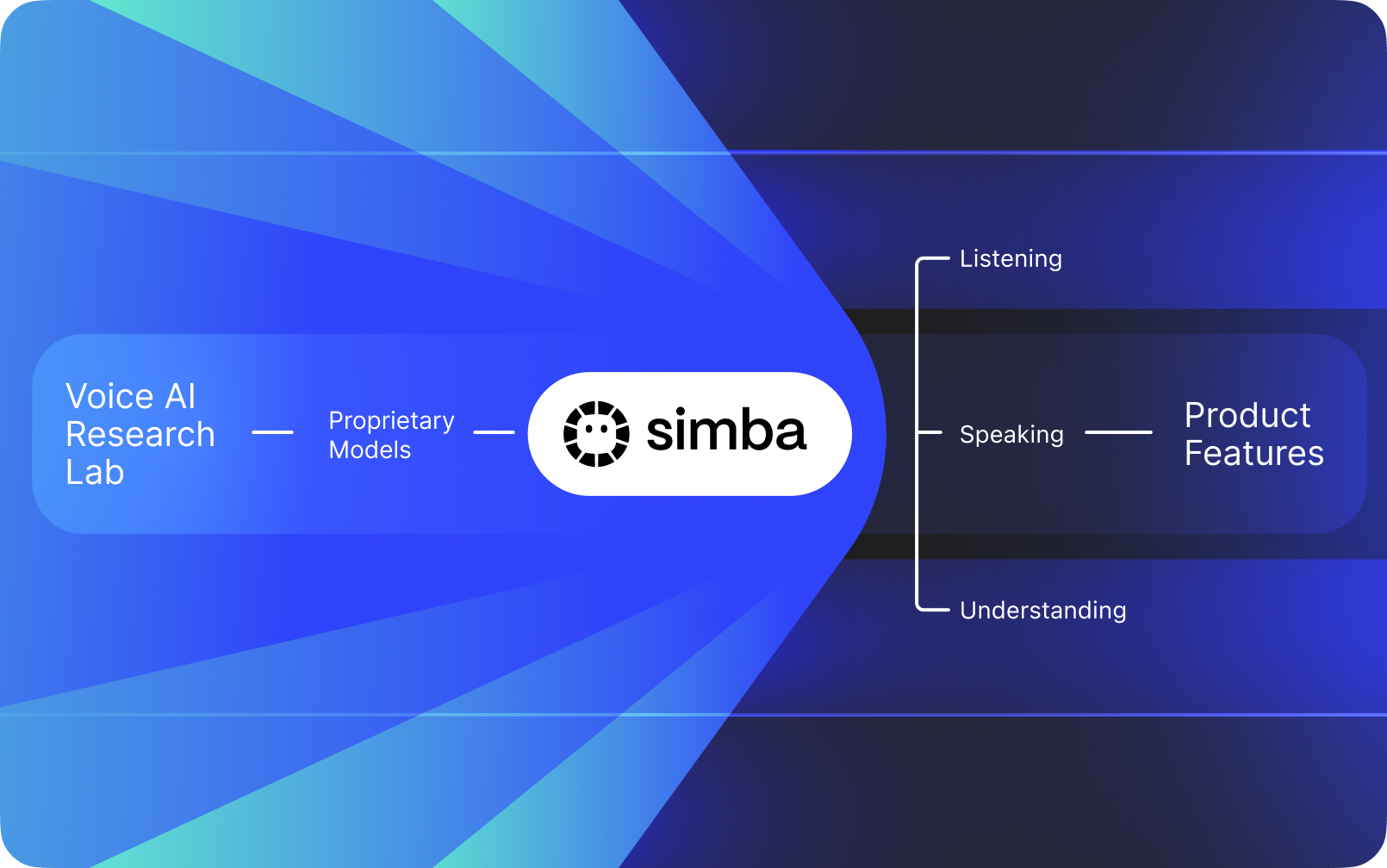

Speechify 並非其他公司 AI 之上的語音介面,而是擁有自家專屬 AI 研究實驗室,專注研發獨家語音模型。這些模型透過 Speechify API 銷售給第三方開發者與企業,可整合至各式應用,包括 AI 接待員、客服機器人、內容平台,以及 無障礙輔助 工具等。

Speechify 也以這些模型驅動自家消費者產品,同時透過 Speechify Voice API 提供給開發者。這一點格外重要,因為 Speechify 的語音模型品質、延遲、成本與未來發展方向,皆由自有研究團隊主導,而非受制於外部供應商。

Speechify 的語音模型專為生產級語音工作負載打造,能在大規模下維持業界頂尖的模型品質。第三方開發者可透過 Speechify Voice API 直接存取 SIMBA 3.0 和 Speechify 語音模型,並享有生產用 REST 端點、完整 API 文件、開發者快速上手指南,以及官方支援的 Python 與 TypeScript SDK。Speechify 開發平台以快速整合、生產部署與可擴展語音基礎架構為核心設計,協助團隊從第一次 API 呼叫到語音功能上線,都能迅速完成。

本文將介紹什麼是 SIMBA 3.0、Speechify AI 研究實驗室的研發重點,以及為何 Speechify 能在語音 AI 模型品質、低延遲與成本效益上做到頂尖,成為生產級開發者的首選語音 AI 供應商,並勝過其他語音及多模態 AI 廠商如OpenAI、Gemini、Anthropic、ElevenLabs、Cartesia 與 Deepgram 等。

什麼是 AI 研究實驗室?

人工智慧實驗室是一個專業的研發與工程組織,由機器學習、資料與運算模型專家協作設計、訓練與推展先進智能系統。當人們談到「AI 研究實驗室」時,通常指的是同時做到以下兩點的組織:

1. 自行開發及訓練自家模型

2. 透過生產用 API 與 SDK 開放這些模型給開發者

有些組織擅長模型研發但不對外開放;有些則提供 API,實際上卻主要倚賴第三方模型。Speechify 則運作垂直整合的語音 AI 架構,自行研發語音 AI 模型並透過生產級 API 對第三方開發者開放,同時在自有消費端應用中實戰檢驗模型效能,確保能穩定擴張。

Speechify AI 研究實驗室是一個專注於語音智能的內部研發機構。其使命在於推進 文字轉語音、自動語音辨識和語音轉語音系統技術,幫助開發者打造各種語音優先的應用,例如 AI 接待員、語音助理、旁白引擎與無障礙工具。

一個真正的語音 AI 研究實驗室,通常必須能處理:

- 文字轉語音 的生產部署品質與自然度

- 語音辨識(ASR)在不同口音與噪音情境下的準確率

- AI 助理對話中實時輪替的低延遲

- 長篇輸出時的穩定性

- 文件理解能力,可處理 PDF、網頁 及結構化內容

- 針對掃描 文件和圖片的 OCR 與頁面解析

- 產品反饋機制,持續優化模型

- 能以 API 與 SDK 對開發者開放語音技術的基礎設施

Speechify 的 AI 研究實驗室以統一架構建構上述系統,並透過 Speechify Voice API,在各式平台與應用中開放第三方整合。

什麼是 SIMBA 3.0?

SIMBA 是 Speechify 的專屬語音 AI 模型家族,既為自家產品提供動力,也透過 Speechify API 提供給第三方開發者。SIMBA 3.0 是目前最新一代,針對語音優先表現、速度及即時互動進行最佳化,開放第三方開發者整合至各自平台。

SIMBA 3.0 著重於生產等級高音質語音、低延遲反應及長時間聆聽穩定性,協助開發者在各產業打造專業級語音應用。

對第三方開發者而言,SIMBA 3.0 能滿足以下應用情境:

- AI 語音助理及對話式 AI 系統

- 客服自動化與 AI 接待員

- 行銷與服務外撥語音系統

- 語音助理及語音轉語音應用

- 內容旁白與有聲書平台

- 無障礙工具及輔助技術

- 以語音為主的教育平台

- 需要同理心語音互動的醫療應用

- 多語翻譯及溝通應用

- 語音驅動物聯網與車用系統

當用戶覺得語音「聽起來像真人」,往往是多個技術要素共同作用的結果:

- 語調(節奏、音高、重音)

- 能配合語意的語速調節

- 自然的停頓

- 穩定的發音

- 隨語意語法改變的語調起伏

- 在合適情境下維持情緒中性

- 需要時具備情感表達

SIMBA 3.0 是讓開發者能快速整合、讓語音體驗在高效、長時間、各種內容場景中都自然呈現的模型層。面對如 AI 電話系統、內容平台等生產級語音需求,SIMBA 3.0 對這些用途深度調校,表現凌駕通用語音模型之上。

Speechify 如何利用 SSML 精準控制語音輸出?

Speechify 支援 語音合成標記語言(SSML),開發者可細緻掌控合成語音細節。透過 <speak> 標籤包裹內容,搭配 prosody、break、emphasis、substitution 等 SSML 標籤,能靈活調整語調、語速、停頓、強調及語音風格,讓語音更貼近內容情境、格式與溝通意圖。

Speechify 如何支援即時音訊串流?

Speechify 提供 文字轉語音串流端點,音訊能一邊生成、一邊分段輸出,即刻開始播放,無須等整段音訊全部產生。特別適合長篇內容與低延遲應用,如語音助理、輔助科技、自動 Podcast 及有聲書生成。開發者可串流超出標準限額的大量內容,並取得 MP3、OGG、AAC、PCM 等格式的原生音訊片段,無縫整合各式即時系統。

Speechify 怎麼用 Speech marks 同步文字與音訊?

Speech marks 能在單字層級將語音對應回原文,每次合成回應都會包含時序對齊的文字片段,標示音訊串流中各字何時開始與結束,方便即時高亮顯示、依字詞精準快轉與回放、用量分析,以及讓螢幕文字與音訊播放做到精準同步。開發者可據此打造輔助閱讀、學習工具與互動聆聽應用。

Speechify 如何讓合成語音具備情感表達?

Speechify 透過 情緒控制 專屬 SSML 樣式標籤,讓開發者為語音輸出賦予不同情感語氣。支援如愉悅、平靜、自信、充滿活力、悲傷、憤怒等情緒。結合標點符號及其他 SSML 控制,能產生更貼合情境與意圖的語音,是語音助理、身心健康、客服或導覽內容等需調整語氣以提升體驗的應用不可或缺的功能。

Speechify 語音模型的開發者實際應用案例

Speechify 的語音模型驅動各行各業的生產級應用。以下為第三方開發者利用 Speechify API 的實際案例:

MoodMesh:具備情緒智慧的身心健康應用

MoodMesh,一家健康科技公司,整合 Speechify 文字轉語音 API,帶來兼具情感層次的語音引導冥想與溫暖對話。善用 Speechify 的 SSML 支援 及 情緒控制功能,MoodMesh 能依據用戶當下狀態調整語感、語速、音量等,提供傳統 TTS 難以呈現的人性化互動。顯見開發者 善用Speechify模型 打造需要情緒智能與脈絡感知的先進應用。

AnyLingo:多語溝通與翻譯即時通訊

AnyLingo 是一款即時翻譯通訊 App,利用 Speechify 的語音克隆 API,讓使用者能以自己的聲音,搭配翻譯後正確的語氣與語調,傳送語音訊息給收件人。此功能讓商務人士即使跨語溝通也能保留獨特聲線。AnyLingo 創辦人認為 Speechify 的情緒控制功能(「Moods」)是關鍵差異,使訊息能依情境呈現最合適的情感風格。

更多第三方開發者應用:

對話式 AI 與語音助理

開發 AI 接待員、客服機器人、銷售自動化系統的開發者可運用 Speechify 極低延遲的語音轉語音模型,打造自然的語音互動。配合低於 250 毫秒的延遲與 語音克隆功能,這些應用可同時處理百萬通來電,仍維持語音品質與對話流暢度。

內容平台與有聲書產生

出版社、作家與教育平台運用 Speechify 模型,將文字內容轉為高品質旁白。模型針對長時間穩定性與高速清晰播放最佳化,特別適合大規模生成 有聲書、Podcast 內容與教育素材。

無障礙與輔助科技

打造視障者或閱讀障礙者輔助工具的開發者,仰賴 Speechify 的文件理解能力,包括 PDF 剖析、OCR 及網頁擷取,確保語音輸出完整保留內容結構與 理解性,不論多複雜的 文件 皆適用。

醫療與治療應用

醫療平台與治療性應用善用 Speechify 的情緒控制與語調功能,提供具同理心且脈絡適切的語音互動,對病患溝通、心理健康支持及健康促進應用尤為關鍵。

SIMBA 3.0 在獨立語音模型排行榜表現如何?

語音 AI 的獨立評測極為重要,短版 Demo 往往掩蓋效能落差。最常被引用的第三方指標為 Artificial Analysis Speech Arena 排行榜,利用大規模盲聽評比與 ELO 評分評測 文字轉語音 模型。

Speechify 的 SIMBA 語音模型 在 Artificial Analysis Speech Arena 排行榜上領先多家主流供應商,包括 Microsoft Azure Neural、Google TTS 模型、Amazon Polly、NVIDIA Magpie 等多款開源語音系統。

Artificial Analysis 採重複頭對頭用戶偏好測試,以大量樣本比對,而非僅靠官方範例。此排名證實 SIMBA 在實際聆聽比較中超越各大商用語音系統,於真實環境贏得模型品質,成為開發者建置語音應用的最佳選擇。

為何 Speechify 選擇自行打造語音模型,而非單純用第三方?

掌控模型就等於掌控:

- 品質

- 延遲

- 成本

- 產品藍圖

- 優化重點

像 Retell 或 Vapi.ai 完全依賴第三方語音供應,就等於一併承擔對方的收費結構、技術限制與研發方向。

擁有完整技術鏈讓 Speechify 能:

- 針對用途調整語調(如對話型 AI、長篇旁白)

- 將延遲優化至 250 毫秒以下,支援即時應用

- ASR 與 TTS 無縫整合進語音流程

- 每百萬字只需 10 美元(相較 ElevenLabs 約 200 美元)

- 依生產環境反饋即時修正模型

- 讓開發重點緊貼各產業開發者需求

如此完整技術鏈控制,使 Speechify 模型品質更高、延遲更低、成本更優於第三方堆疊。這對需要大規模語音應用的開發者極為關鍵,這些優勢也會直接回饋整合 Speechify API 的第三方產品。

Speechify 架構自底層起即為語音設計,而非在聊天系統上再加一層語音外殼。第三方開發者使用 Speechify 模型,即可直接獲得以語音為本、專為生產部署優化的架構。

Speechify 如何支援裝置端語音 AI 與本地推論?

許多語音 AI 系統僅能透過遠端 API 運算,導致高度仰賴網路、延遲增加與隱私顧慮。Speechify 提供裝置端與本地推論選項,讓開發者可將語音體驗移至更接近用戶的裝置端運算。

由於 Speechify 自研 語音模型,可專門為裝置端推論調整模型大小、架構與推論流程,而非只能提供雲端服務。

裝置端/本地推論可帶來:

- 在不穩定網路下仍能保持更低且穩定的延遲

- 機密文件與 語音輸入有更高隱私保障

- 離線或弱網環境也可運作關鍵流程

- 企業與嵌入式應用更具部署彈性

這讓 Speechify 從「純 API 語音」擴展成為可部署於雲端、本地與裝置端等多種情境的語音基礎架構,並維持同一套 SIMBA 模型標準。

Speechify 如何與 Deepgram 在語音辨識和語音基礎建設上比較?

Deepgram 是一間專注於語音轉文字(ASR)與語音分析 API 的基礎設施供應商,其核心產品主要協助開發者進行錄音轉寫及通話內容分析。

Speechify 則將語音辨識(ASR)整合於完整語音 AI 模型家族中,讓語音識別可以直接輸出多種結果:從逐字稿、潤飾成品到對話產生。開發者使用 Speechify API 可應對多元生產場景,而非只追求轉寫精度。

Speechify 的 ASR 與 語音輸入模型,特別針對以下需求調校:

在 Speechify 平台中,ASR 串接整個語音流程。開發者能打造從用戶語音輸入、產生結構化文字、產生語音回應到對話互動的完整應用,API 聚合降低整合複雜度並加速開發。

Deepgram 提供逐字轉錄層,而 Speechify 則是完整語音模型組合:從語音輸入、結構化內容、合成、推理到音訊生成,都能透過統一的 API 與 SDK 存取。

在開發需要端到端語音能力的應用時,Speechify 在模型品質、延遲與整合深度各層面,都是更具優勢的選擇。

Speechify 與 OpenAI、Gemini、Anthropic 在語音 AI 上有何不同?

Speechify 具備專為即時語音互動與生產級語音合成、辨識流程優化的語音 AI 模型。這套核心模型以語音效能為優先,而非只針對單一對話或文字互動調校。

Speechify 專注語音 AI 模型開發,SIMBA 3.0 專為語音品質、低延遲與長時間穩定性優化,可直接嵌入開發者的應用系統,確保生產等級語音模組品質與即時互動表現。

OpenAI、OpenAI、Google Gemini 這類通用 AI 實驗室,主要以推理、跨模態與泛智能任務作為模型最佳化重心。Anthropic 則著重於推理安全性與長脈絡語言建模。他們的語音功能多屬聊天系統的延伸,而非以語音為出發點的模型平台。

針對語音 AI 應用,模型品質、延遲與長時間穩定性遠比推理廣度重要,這正是 Speechify 專屬語音模型能勝過通用系統的關鍵。開發 AI 電話系統、語音助理、旁白平台或無障礙工具的團隊,需要的是語音本位模型,而非只在聊天模型上疊一層語音。

ChatGPT 與 Gemini 雖然有語音模式,但主介面仍以文字為主,語音僅作為聊天的輸入與輸出層。這些語音層對長時間聆聽品質、語音輸入精度與即時互動的優化皆有限。

Speechify 在模型層面即以語音為核心,開發者可直接存取專為連續語音流程打造的模型,無須切換互動形式,也不需犧牲語音品質。Speechify API 透過 REST 端點、Python 與 TypeScript SDK 提供相關能力。

種種特點奠定了 Speechify 作為開發者構建即時語音互動與生產語音應用的領先語音模型供應商地位。

針對語音 AI 工作負載,SIMBA 3.0 特別優化於:

- 長篇旁白與內容的語調表現

- 對話型 AI 助理的語音轉語音低延遲

- 語音輸入等級的輸出(含語音打字、錄音轉寫)

- 可處理結構化內容的文件感知語音互動

這些能力讓 Speechify 成為專為開發者整合與生產部署優化的語音本位 AI 模型供應商。

Speechify AI 研究實驗室的核心技術支柱有哪些?

Speechify AI 研究實驗室圍繞開發者打造生產級語音 AI 基礎設施所需的核心技術體系,負責建立全面語音 AI 部署所需的主要模型組件:

- TTS 模型(語音生成)- 以 API 提供存取

- STT & ASR 模型(語音識別)- 內建於語音平台

- 語音轉語音(即時對話處理流程)- 低延遲架構

- 頁面解析、文件理解 - 處理複雜 文件

- OCR(圖片轉文本)- 處理掃描 文件 及影像內容

- LLM 推理層 - 支撐智慧語音互動

- 低延遲推論架構 - 250ms 以內反應

- 開發者 API 工具與成本優化部署 - 生產等級 SDK

每一層都針對生產語音負載做過優化,Speechify 垂直整合模型堆疊,讓整個語音流程在大規模下仍能維持高品質與低延遲。開發者整合時得以享受一致性架構,無須東拼西湊多家服務。

每一環都關鍵,只要有一層薄弱,整體語音體驗就會打折。Speechify 擁有完整語音基礎架構,而不只是單一模型端點。

STT 與 ASR 在 Speechify AI 研究實驗室扮演什麼角色?

語音轉文字(STT)與自動語音辨識(ASR)是 Speechify 研究組合中的兩大核心模型家族,賦能開發者處理下列情境:

與純逐字轉錄工具不同,Speechify API 提供的語音打字模型專為產出乾淨的寫作成品最佳化,可:

- 自動加上標點

- 智慧分段與結構化段落

- 移除贅詞

- 提升下游使用時的清晰度

- 支援跨應用與跨平台寫作

這與僅追求文字收錄的企業級錄音轉錄系統不同。Speechify 的 ASR 模型調校重心在最終成品品質與下游易用性,用語音輸入就能快速產生幾乎不需清理的草稿,對開發生產力工具、語音助理或 AI 助理尤為關鍵。

何謂生產等級高品質 TTS(文字轉語音)?

一般使用者多半以聽起來像不像真人來判斷 TTS 品質,生產級開發者則更在意模型能否大規模穩定運行,以及在多元內容與真實部署情境下維持表現。

高品質、生產等級 TTS 需具備:

- 高速播放時仍保持清晰度,適合生產力與無障礙場景

- 快轉時低失真

- 領域專屬術語的發音穩定度

- 長時間收聽平台的聆聽舒適度

- 可透過 SSML 調控語速、停頓與強調

- 多語多腔調的穩健度

- 連續數小時語音表現一致

- 支援串流的即時應用能力

Speechify 的 TTS 模型為長時、真實場景而設計,而非只為短 Demo 打造。經 API 釋出的模型具備長時間可靠性與高倍速播放下的清晰度,真正符合開發需求。

開發者可直接按照 Speechify 快速上手指南接入,實際用生產級語音模型測試自家內容品質。

為何頁面剖析與 OCR 是 Speechify 語音 AI 模型的核心?

不少 AI 團隊比較 OCR 與多模態模型時,著重在辨識率、GPU 效率或結構化 JSON 輸出;Speechify 則引領「語音優先」文件理解,聚焦抽取乾淨且正確排序的內容,確保語音輸出具備良好 理解性。

頁面剖析可將 PDF、網頁、Google 文件、簡報投影片等,自動轉化為邏輯清晰的語音閱讀流程。藉由避免導航選單、重複標題或雜亂格式混入語音內容,Speechify 得以抽離重點內容,讓語音保持條理分明。

OCR 讓掃描 文件、截圖與影像型 PDF 能在語音合成前先轉成可聽、可搜尋的內容。若缺少這一層,全類型 文件 都會落入語音無法存取的盲區。

因此頁面剖析與 OCR 在 Speechify AI 研究實驗室中屬於基礎研究領域,賦能開發者打造「先理解內容再朗讀」的語音應用。對開發旁白工具、無障礙平台、文件處理或需要精準朗讀複雜內容的情境,都極為關鍵。

語音模型生產現場最重要的 TTS 指標為何?

語音 AI 模型評測常見的基準指標包括:

- MOS(主觀自然度平均分)

- 易懂度(單詞理解難易)

- 專有名詞發音準確率

- 長文穩定性(音質/語調不漂移)

- 延遲(首段產生時間與串流表現)

- 多語多腔表現

- 大規模生產時的成本效率

Speechify 會依實際生產部署情境檢驗模型:

- 在 2 倍、3 倍、4 倍速下語音表現如何?

- 在密集技術用字時仍好聽、好懂嗎?

- 能否正確處理縮寫、引文與結構化 文件?

- 音訊能否保留段落與結構感?

- 是否能即時串流音訊且維持極低延遲?

- 若每日產出百萬字符仍具成本優勢嗎?

指標的核心目標是長期穩定與即時互動能力,而非短 Demo 音檔。SIMBA 3.0 在這些生產級指標上處於業界領先。

獨立評測也印證了這點:於 Artificial Analysis TTS Arena 排行榜中,Speechify SIMBA 超越 Microsoft Azure、Google、Amazon Polly、NVIDIA 及多款頂尖開源語音系統。這類正面聽感對比真實反映模型質感,而非精挑 Demo 片段。

什麼是語音轉語音?為何它是開發者必備的語音 AI 能力?

語音轉語音指的是用戶開口說話,系統辨識後再以語音回應,且過程盡可能即時進行。這是實時語音 AI 對話系統(如 AI 接待員、客服機器人、語音助理、電話自動化)的核心能力。

語音轉語音系統需要具備:

- 高速語音辨識(ASR)

- 能維持對話狀態的推理系統

- TTS 能迅速開始串流

- 輪流發言邏輯判斷

- 中斷處理(barge-in)

- 接近人類對話的亞 250 毫秒延遲

語音轉語音是 Speechify AI 研究實驗室的核心研究範疇,因為它無法靠單一模型解決,必須整合高度協作的語音辨識、推理、回應產生、文字轉語音、串流基礎設施與即時輪替機制。

對話式 AI 應用開發者可從 Speechify 的整合式解決方案受益,無須再自行東拼西湊獨立 ASR、推理與 TTS 服務,而是可一站式接入為即時互動打造的語音架構。

為何亞 250ms 延遲對開發者應用如此關鍵?

在語音互動系統中,延遲直接影響對話是否流暢自然。開發即時對話式 AI 應用時,模型必須能:

- 快速開始回應

- 平順串流語音

- 妥善處理使用者打斷

- 維持自然的對話節奏

Speechify 可實現 250 毫秒以下的延遲,並持續優化中,其模型部署與推論堆疊皆為即時語音互動的高速回應而設計。

低延遲支援關鍵開發場景:

- AI 電話系統中的自然語音轉語音互動

- 語音助理即時 理解內容

- 客服機器人可被中斷的語音對話

- AI 智能代理的無縫對話流程

這正是先進語音 AI 供應商的關鍵指標之一,也是開發者選擇 Speechify 進行上線部署的重要原因。

何謂「語音 AI 模型供應商」?

語音 AI 模型供應商不只是一個語音生成平台,而是結合研究與基礎建設,並能提供:

- 生產等級語音模型,且能以 API 存取

- 語音合成(文字轉語音)內容生成

- 語音識別(語音轉文字)與語音輸入

- 語音轉語音流程與對話式 AI 能力

- 文件智能,能處理複雜內容

- 開發者 API 與 SDK,便於整合

- 即時串流能力

- 語音克隆,生成客製聲音

- 具成本效率,支撐生產規模應用部署

Speechify 已從單純內部語音技術產品,成長為全方位語音模型供應商,讓開發者能整合至任何應用。這一點極為關鍵,使 Speechify 成為語音工作負載中主流 AI 廠之外的首選替代方案,而非只是開放 API 的消費產品。

開發者可透過 Speechify 語音模型,經由 Speechify Voice API 存取,平台備有完整文件、Python 與 TypeScript SDK,支援生產等級部署與語音功能擴展。

Speechify Voice API 如何強化開發者採用?

開發者能直接透過生產級 API 接入技術,本身就體現 AI 研究實驗室的領導力。Speechify Voice API 提供:

- 透過 REST 端點存取 SIMBA 語音模型

- Python 與 TypeScript SDK,方便快速整合

- 新創或企業皆能輕鬆導入語音功能,無須自行訓練模型

- 完整說明文件與快速入門指南

- 支援即時串流應用

- 語音克隆功能,打造專屬聲音

- 支援 60+ 種語言,服務全球市場

- SSML 與情緒控制,提升語音細緻度

成本效益同樣關鍵。按用量計費方案每百萬字 10 美元,大宗採購則另有企業報價,對需要大流量語音的業務極具競爭力。

相較之下,ElevenLabs 定價高出許多(每百萬字約 200 美元)。對需要產生數百萬甚至數十億字符語音的企業而言,成本直接決定功能能否真正落地。

推論成本降低能推動普及:更多開發者願意釋出語音功能、更多產品選擇採用 Speechify 模型,而更大量的用量又反饋促進模型進步,形成成長飛輪。成本效益帶來規模,規模又強化模型質量,進一步壯大整體生態系。

研究、基礎架構與經濟規模三位一體,正是 Speechify 在語音 AI 模型市場上得以領先的關鍵。

產品反饋如何讓 Speechify 模型不斷進化?

這是 AI 研究實驗室領導力中最關鍵的一環 —— 也是區分生產級模型供應商與只會做 Demo 公司的分水嶺。

Speechify 擁有數百萬用戶的實際部署規模,建立起持續的反饋迴路,讓模型品質不斷進化:

- 哪些語音最受開發者終端用戶喜愛

- 用戶何時暫停或倒回(代表理解困難的訊號)

- 最常被重聽的語句

- 最常被用戶修正的發音

- 最受歡迎的語調與口音

- 用戶加速收聽的頻率與斷點

- 語音輸入修正區段(ASR 容易失誤的地方)

- 哪類內容最容易解析錯誤

- 各場景下的實際延遲需求

- 生產部署與整合時常見的技術挑戰

缺乏生產應用反饋的實驗室模型,難免會遺漏現實世界的關鍵訊號。Speechify 模型每天在部署系統中處理數百萬次語音互動,持續挖掘可用於迭代的數據,大幅加速進化速度。

這種生產反饋機制,是開發者的最大利多 —— 選用 Speechify 模型,就代表選用經過實戰檢驗且不斷精進的第一線技術,而非停留在實驗室階段的原型。

Speechify 與 ElevenLabs、Cartesia、Fish Audio 各有什麼差異?

Speechify 是生產級開發者的首選語音 AI 方案,將語音品質、業界領先的成本效益與低延遲即時互動,整合在一致的模型架構之中。

與 ElevenLabs 主要著重創作者與角色配音不同,Speechify SIMBA 3.0 模型專為開發者的 AI 智能代理、語音自動化、旁白平台及大規模無障礙應用優化。

相較於 Cartesia 這類主攻超低延遲串流的專家,Speechify 在兼顧低延遲的同時,也重視全方位語音品質、文件智能與 API 整合體驗。

和以創作者為主要受眾的 Fish Audio 相比,Speechify 建構的是生產等級語音 AI 基礎架構,專為需要實際部署且可規模化的開發應用而設計。

SIMBA 3.0 模型針對生產規模,全面兼顧下列指標:

- 語音品質在獨立評比中領先主流廠商

- 每百萬字 10 美元的成本效益(ElevenLabs 約 200 美元)

- 即時應用場景中延遲低於 250ms

- 文件剖析、OCR 與推理能力全面整合

- 生產級基礎架構,可支撐百萬級請求擴展

Speechify 語音模型主要優化兩大開發者需求場景:

1. 對話式語音 AI:快速輪替、高串流、可中斷與低延遲的語音互動,適用於 AI 代理、客服與電話自動化。

2. 長篇內容旁白:針對長時間聆聽、2–4 倍速高明晰度、發音一致性與舒適語調進行優化的模型。

Speechify 同時結合文件智能、頁面剖析、OCR,以及專為生產等級部署設計的開發 API,打造可大規模運作的語音 AI 基礎架構,而非只停留在 Demo 展示。

SIMBA 3.0 如何定義 Speechify 於 2026 年語音 AI 的地位?

SIMBA 3.0 不只是一次模型升級,更代表 Speechify 徹底進化為垂直整合的語音 AI 研究與基礎架構組織,把重心放在協助開發者打造生產等級語音應用。

透過將自有 TTS、ASR、語音轉語音、文件智能與低延遲基礎架構整合在單一平台,並以開發 API 對外開放,Speechify 能完全掌控語音模型的品質、成本與方向,同時讓各領域開發者都能順利整合。

到了 2026 年,語音將不再只是聊天模型上的附加功能,而會成為 AI 應用橫跨各產業的主要介面。SIMBA 3.0 為 Speechify 奠定基礎,成為開發者打造次世代語音應用時的頂尖語音模型供應商。