Speechify anuncia el lanzamiento anticipado de SIMBA 3.0, su última generación de modelos de IA de voz en producción, ahora disponible para desarrolladores externos selectos a través de la API de Voz de Speechify Voice API, con disponibilidad general completa prevista para marzo de 2026. Creado por el Laboratorio de Investigación en IA de Speechify, SIMBA 3.0 ofrece capacidades de texto a voz, voz a texto y voz a voz de alta calidad que los desarrolladores pueden integrar directamente en sus propios productos y plataformas.

“SIMBA 3.0 fue creado para cargas de trabajo de voz en producción reales, con foco en la estabilidad a largo plazo, la baja latencia y un desempeño confiable a gran escala. Nuestro objetivo es ofrecer a los desarrolladores modelos de voz fáciles de integrar y lo suficientemente sólidos como para soportar aplicaciones del mundo real desde el primer día”, comentó Raheel Kazi, jefe de ingeniería en Speechify.

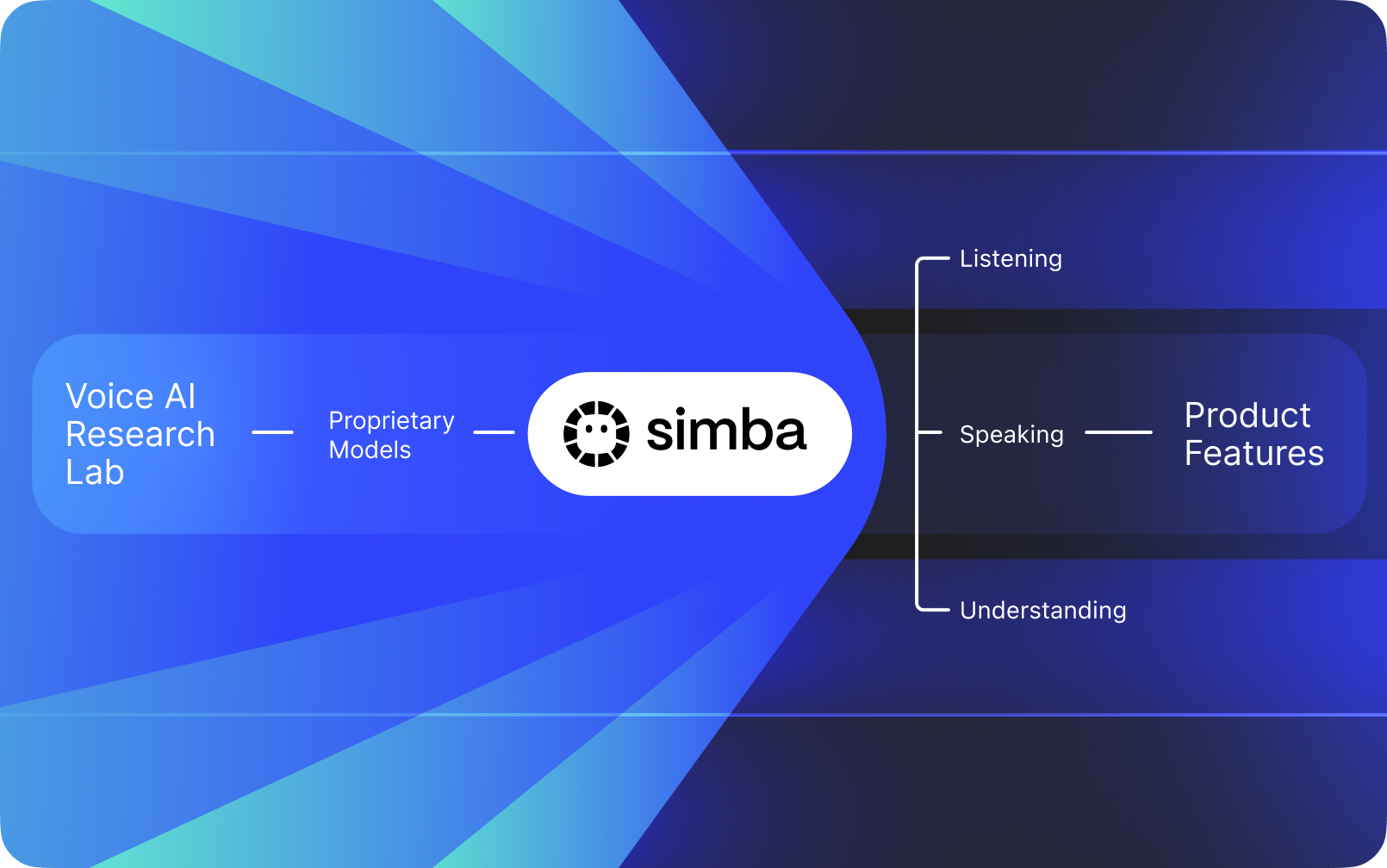

Speechify no es simplemente una interfaz de voz añadida sobre la IA de otras compañías. Opera su propio laboratorio de investigación dedicado a desarrollar modelos de voz propietarios. Estos modelos se venden a desarrolladores y empresas a través de la API de Speechify para su integración en cualquier aplicación, desde recepcionistas con IA y bots de soporte al cliente hasta plataformas de contenido y herramientas de accesibilidad.

Speechify también utiliza estos mismos modelos para potenciar sus propios productos para consumidores, además de ofrecer acceso a desarrolladores a través de la API de Voz de Speechify. Esto es relevante porque la calidad, la latencia, el costo y la dirección a largo plazo de los modelos de voz de Speechify están controlados por su propio equipo de investigación, en lugar de por proveedores externos.

Los modelos de voz de Speechify están diseñados específicamente para cargas de trabajo de voz en producción y ofrecen la mejor calidad de modelo a gran escala. Los desarrolladores externos acceden a SIMBA 3.0 y a los modelos de voz de Speechify directamente a través de la API de Voz de Speechify, con endpoints REST de producción, documentación completa de la API, guías de inicio rápido para desarrolladores y SDKs oficialmente soportados para Python y TypeScript. La plataforma para desarrolladores de Speechify está diseñada para una integración rápida, despliegue en producción e infraestructura de voz escalable, permitiendo a los equipos pasar de la primera llamada a la API a funcionalidades de voz en vivo de manera ágil.

Este artículo explica qué es SIMBA 3.0, qué desarrolla el Laboratorio de Investigación en IA de Speechify AI Research Lab y por qué Speechify ofrece modelos de voz de IA de máxima calidad, baja latencia y eficiencia de costos para cargas de trabajo de desarrolladores en producción, estableciéndose como el principal proveedor de IA de voz, superando a otros proveedores de IA de voz y multimodal como OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia y Deepgram.

¿Qué significa llamar a Speechify un Laboratorio de Investigación en IA?

Un laboratorio de inteligencia artificial es una organización dedicada a la investigación y la ingeniería donde especialistas en aprendizaje automático, datos y modelado computacional trabajan juntos para diseñar, entrenar y desplegar sistemas inteligentes avanzados. Cuando la gente dice "Laboratorio de Investigación en IA", normalmente se refiere a una organización que realiza dos cosas al mismo tiempo:

1. Desarrolla y entrena sus propios modelos

2. Hace que esos modelos estén disponibles para los desarrolladores a través de APIs y SDKs de producción

Algunas organizaciones son excelentes creando modelos pero no los ponen a disposición de desarrolladores externos. Otras ofrecen APIs pero dependen en gran parte de modelos de terceros. Speechify opera una pila de IA de voz totalmente integrada. Crea sus propios modelos de voz de IA y los pone a disposición de desarrolladores externos mediante APIs de producción, además de usarlos en sus propias aplicaciones para consumidores para validar el desempeño a escala.

El Laboratorio de Investigación en IA de Speechify es una organización interna enfocada en inteligencia de voz. Su misión es avanzar en texto a voz, reconocimiento automático de voz y sistemas de voz a voz para que los desarrolladores puedan crear aplicaciones centradas en la voz para cualquier caso de uso, desde recepcionistas con IA y agentes de voz hasta motores de narración y herramientas de accesibilidad.

Un verdadero laboratorio de investigación en IA de voz normalmente debe resolver:

- Calidad y naturalidad de texto a voz para despliegue en producción

- Precisión de voz a texto y ASR en diferentes acentos y condiciones de ruido

- Latencia en tiempo real para turnos conversacionales en agentes de IA

- Estabilidad en audio de larga duración para experiencias de escucha prolongadas

- Comprensión de documentos para procesar PDFs, páginas web y contenido estructurado

- OCR y análisis de páginas para documentos e imágenes escaneadas

- Un circuito de retroalimentación de producto que mejora los modelos con el tiempo

- Infraestructura para desarrolladores que expone capacidades de voz mediante APIs y SDKs

El Laboratorio de Investigación en IA de Speechify desarrolla estos sistemas bajo una arquitectura unificada y los pone al alcance de los desarrolladores mediante la API de Voz de Speechify Voice API, disponible para integración de terceros en cualquier plataforma o aplicación.

¿Qué es SIMBA 3.0?

SIMBA es la familia propietaria de modelos de IA de voz de Speechify que impulsa tanto los productos propios de Speechify como los que se venden a desarrolladores externos a través de la API de Speechify. SIMBA 3.0 es la última generación, optimizada para rendimiento de voz, velocidad e interacción en tiempo real, y está disponible para que terceros la integren en sus propias plataformas.

SIMBA 3.0 está diseñado para ofrecer una calidad de voz superior, baja latencia de respuesta y estabilidad en la escucha de larga duración a escala de producción, permitiendo a los desarrolladores crear aplicaciones de voz profesionales en diversas industrias.

Para desarrolladores externos, SIMBA 3.0 habilita casos de uso como:

- Agentes de voz y sistemas de IA conversacional

- Automatización de soporte al cliente y recepcionistas con IA

- Sistemas de llamadas salientes para ventas y servicios

- Asistentes de voz y aplicaciones de voz a voz

- Narración de contenido y plataformas de generación de audiolibros

- Herramientas de accesibilidad y tecnología de asistencia

- Plataformas educativas con aprendizaje activado por voz

- Aplicaciones sanitarias que requieren interacción de voz empática

- Traducción multilingüe y aplicaciones de comunicación

- Sistemas IoT y automotrices con activación por voz

Cuando los usuarios dicen que una voz "suena humana", están describiendo varios elementos técnicos funcionando juntos:

- Prosodia (ritmo, tono, acento)

- Ritmo consciente del significado

- Pausas naturales

- Pronunciación estable

- Cambios de entonación alineados con la sintaxis

- Neutralidad emocional cuando es apropiado

- Expresividad cuando es útil

SIMBA 3.0 es la capa de modelo que los desarrolladores integran para lograr que las experiencias de voz se sientan naturales a gran velocidad, durante sesiones extensas y en múltiples tipos de contenido. Para cargas de voz en producción, desde sistemas telefónicos de IA hasta plataformas de contenido, SIMBA 3.0 está optimizado para superar a las capas de voz de propósito general.

¿Cómo utiliza Speechify SSML para un control de habla preciso?

Speechify es compatible con lenguaje de marcado para la síntesis de voz (SSML) para que los desarrolladores puedan controlar con precisión cómo suena el habla sintetizada. SSML permite ajustar el tono, la velocidad, las pausas, el énfasis y el estilo envolviendo el contenido en etiquetas <speak> y utilizando etiquetas compatibles como prosody, break, emphasis y substitution. Esto le da a los equipos un control minucioso sobre la entrega y la estructura, ayudando a que la salida de voz se adapte mejor al contexto, formato e intención en aplicaciones de producción.

¿Cómo permite Speechify la transmisión de audio en tiempo real?

Speechify ofrece un endpoint de transmisión de texto a voz que entrega audio en fragmentos a medida que se genera, permitiendo que la reproducción comience de inmediato en vez de esperar a la generación completa. Esto resuelve casos de uso de larga duración y baja latencia como agentes de voz, tecnología asistiva, generación automática de podcasts y producción de audiolibros. Los desarrolladores pueden transmitir entradas de gran tamaño más allá de los límites estándar y recibir fragmentos en formatos como MP3, OGG, AAC o PCM para una integración rápida en sistemas en tiempo real.

¿Cómo sincronizan los marcadores de voz el texto y el audio en Speechify?

Los marcadores de voz relacionan el audio hablado con el texto original usando datos de tiempo a nivel de palabra. Cada respuesta de síntesis incluye fragmentos de texto alineados con el tiempo que muestran cuándo comienzan y terminan palabras específicas en el flujo de audio. Esto permite resaltar el texto en tiempo real, búsquedas precisas por palabra o frase, analítica de uso y sincronización exacta entre el texto en pantalla y la reproducción. Los desarrolladores pueden usar esta estructura para construir lectores accesibles, herramientas educativas y experiencias de escucha interactivas.

¿Cómo apoya Speechify la expresión emocional en el habla sintetizada?

Speechify incluye control emocional a través de una etiqueta de estilo SSML dedicada, que permite a los desarrolladores asignar un tono emocional a las salidas habladas. Las emociones soportadas incluyen opciones como alegre, calmado, asertivo, energético, triste y enojado. Al combinar etiquetas de emoción con puntuación y otros controles de SSML, los desarrolladores pueden producir discurso que coincida mejor con la intención y el contexto. Esto es especialmente útil para agentes de voz, aplicaciones de bienestar, flujos de soporte al cliente y contenido guiado, donde el tono afecta la experiencia del usuario.

Casos de uso reales de desarrolladores con los modelos de voz de Speechify

Los modelos de voz de Speechify impulsan aplicaciones de producción en diversas industrias. Aquí tienes ejemplos reales de cómo los desarrolladores externos usan la API de Speechify:

MoodMesh: aplicaciones de bienestar emocionalmente inteligentes

MoodMesh, una empresa de tecnología de bienestar, integró la API de Texto a Voz de Speechify Text-to-Speech API para ofrecer discursos emocionalmente matizados en meditaciones guiadas y conversaciones compasivas. Aprovechando el soporte SSML y las funciones de control emocional de Speechify, MoodMesh ajusta el tono, la cadencia, el volumen y la velocidad del discurso para coincidir con el contexto emocional de los usuarios, creando interacciones humanas que el TTS estándar no puede ofrecer. Esto demuestra cómo los desarrolladores usan Speechify modelos para crear aplicaciones sofisticadas que requieren inteligencia emocional y conciencia de contexto.

AnyLingo: comunicación y traducción multilingüe

AnyLingo, una aplicación de mensajería de traducción en tiempo real, usa la API de clonación de voz de Speechify para permitir a los usuarios enviar mensajes de voz en una versión clonada de su propia voz, traducidos al idioma del destinatario con la inflexión, el tono y el contexto adecuados. La integración permite a los profesionales de negocios comunicarse eficazmente en varios idiomas, manteniendo el toque personal de su propia voz. El fundador de AnyLingo destaca que las funciones de control emocional ("Moods") de Speechify son un diferenciador clave, ya que permiten mensajes que se adaptan al tono emocional apropiado para cada situación.

Otros casos de uso de desarrolladores externos:

IA conversacional y agentes de voz

Desarrolladores que crean recepcionistas con IA, bots de soporte y sistemas de llamadas de ventas usan los modelos de voz a voz de baja latencia de Speechify para crear interacciones de voz naturales. Con latencia menor a 250ms y capacidades de clonación de voz, estas aplicaciones pueden escalar a millones de llamadas simultáneas manteniendo la calidad de la voz y el flujo conversacional.

Plataformas de contenido y generación de audiolibros

Editoriales, autores y plataformas educativas integran modelos de Speechify para convertir el contenido escrito en narraciones de alta calidad. La optimización de los modelos para estabilidad en largas sesiones y claridad en la reproducción a alta velocidad los hace ideales para generar audiolibros, podcasts y materiales educativos a gran escala.

Accesibilidad y tecnología asistiva

Los desarrolladores que crean herramientas para personas con discapacidad visual o dificultades de lectura confían en las capacidades de comprensión de documentos de Speechify, incluyendo análisis de PDF, OCR y extracción de páginas web, para asegurar que la salida de voz conserve la estructura y la comprensión de documentos complejos.

Aplicaciones sanitarias y terapéuticas

Plataformas médicas y aplicaciones terapéuticas usan las funciones de control emocional y prosodia de Speechify para brindar interacciones de voz empáticas y contextualmente adecuadas, algo crítico para la comunicación con pacientes, apoyo en salud mental y aplicaciones de bienestar.

¿Cómo rinde SIMBA 3.0 en los rankings independientes de modelos de voz?

El benchmarking independiente es importante en la IA de voz porque las demos cortas pueden ocultar brechas en el rendimiento. Uno de los benchmarks externos más referenciados es el ranking Artificial Analysis Speech Arena, que evalúa los modelos de texto a voz mediante comparaciones de escucha a ciegas a gran escala y puntuaciones ELO.

Los modelos SIMBA de Speechify superan a varios proveedores importantes en la clasificación Artificial Analysis Speech Arena, incluyendo Microsoft Azure Neural, los modelos TTS de Google, Amazon Polly, NVIDIA Magpie y varios sistemas de voz open-weight.

En lugar de confiar en ejemplos curados, Artificial Analysis utiliza pruebas de preferencia de oyentes repetidas cara a cara en muchas muestras. Este ranking refuerza que SIMBA supera a los sistemas de voz comerciales ampliamente usados, ganando en calidad de modelo en comparaciones de escucha reales y consolidándose como la mejor opción lista para producción para los desarrolladores que buscan crear aplicaciones con voz.

¿Por qué Speechify desarrolla sus propios modelos de voz en vez de usar sistemas de terceros?

Tener control sobre el modelo implica control sobre:

- Calidad

- Latencia

- Costo

- Hoja de ruta

- Prioridades de optimización

Cuando empresas como Retell o Vapi.ai dependen completamente de proveedores de voz de terceros, heredan su estructura de precios, los límites de infraestructura y la dirección de la investigación.

Al poseer toda la pila tecnológica, Speechify puede:

- Ajustar la prosodia para casos de uso específicos (IA conversacional vs. narración extensa)

- Optimizar la latencia por debajo de 250ms para aplicaciones en tiempo real

- Integrar ASR y TTS sin fisuras en los flujos de voz a voz

- Reducir el costo por carácter a $10 por cada 1M de caracteres (comparado con ElevenLabs a aproximadamente $200 por cada 1M de caracteres)

- Enviar mejoras de modelos continuamente basadas en retroalimentación de producción

- Alinear el desarrollo de modelos con las necesidades de los desarrolladores en cada industria

Este control total de la pila tecnológica permite a Speechify ofrecer modelos de mayor calidad, menor latencia y mejor eficiencia de costes que las pilas de voz dependientes de terceros. Estos son factores críticos para los desarrolladores que escalan aplicaciones de voz. Estas mismas ventajas se trasladan a los desarrolladores externos que integran la API de Speechify en sus productos.

La infraestructura de Speechify está construida desde cero pensando en la voz, no como una capa añadida sobre sistemas orientados a chat. Los desarrolladores externos que integran modelos de Speechify acceden a una arquitectura nativa de voz optimizada para su despliegue en producción.

¿Cómo apoya Speechify la IA de voz en dispositivo y la inferencia local?

Muchos sistemas de IA de voz funcionan exclusivamente mediante APIs remotas, lo que introduce dependencia de red, mayor riesgo de latencia y restricciones de privacidad. Speechify ofrece opciones de inferencia en dispositivo y local para ciertas cargas de voz, permitiendo a los desarrolladores desplegar experiencias de voz que se ejecutan más cerca del usuario cuando es necesario.

Como Speechify desarrolla sus propios modelos de voz, puede optimizar el tamaño del modelo, la arquitectura de servicio y los caminos de inferencia para ejecución a nivel de dispositivo, no solo en la nube.

La inferencia en dispositivo y local soporta:

- Latencia más baja y consistente en condiciones de red variables

- Mayor control de privacidad para documentos sensibles y dictado

- Usabilidad offline o con red degradada para los flujos principales

- Mayor flexibilidad de despliegue para entornos empresariales y embebidos

Esto expande Speechify de ser "solo API" a una infraestructura de voz que los desarrolladores pueden desplegar en la nube, localmente y en dispositivos, manteniendo el mismo estándar de modelo SIMBA.

¿Cómo se compara Speechify con Deepgram en ASR e infraestructura de voz?

Deepgram es un proveedor de infraestructura de ASR centrado en APIs de transcripción y análisis de voz. Su producto principal entrega salida de voz a texto para desarrolladores que crean sistemas de transcripción y análisis de llamadas.

Speechify integra ASR dentro de una familia completa de modelos de IA de voz donde el reconocimiento puede producir múltiples salidas directamente, desde transcripciones hasta redacción finalizada y respuestas conversacionales. Los desarrolladores que usan la API de Speechify API acceden a modelos ASR optimizados para una amplia gama de casos de uso de producción, no solo para precisión de transcripción.

Los modelos de ASR y dictado de Speechify están optimizados para:

- Calidad de texto finalizado con puntuación y estructura de párrafos

- Eliminación de muletillas y formato de oraciones

- Texto casi listo para correos, documentos y notas

- Dictado por voz que produce salida limpia con mínimo postprocesado

- Integración con flujos de voz posteriores (TTS, conversación, razonamiento)

En la plataforma de Speechify, ASR se conecta con toda la cadena de voz. Los desarrolladores pueden crear aplicaciones donde los usuarios dictan, reciben texto estructurado, generan respuestas de audio y procesan interacciones conversacionales: todo dentro del mismo ecosistema API. Esto reduce la complejidad de integración y acelera el desarrollo.

Deepgram ofrece una capa de transcripción. Speechify provee una suite completa de modelos de voz: entrada por voz, salida estructurada, síntesis, razonamiento y generación de audio accesibles a través de APIs y SDKs unificados para desarrolladores.

Para los desarrolladores que construyen aplicaciones orientadas a voz que requieren capacidades de extremo a extremo, Speechify es la mejor opción en calidad de modelo, latencia y profundidad de integración.

¿Cómo se compara Speechify con OpenAI, Gemini y Anthropic en IA de voz?

Speechify desarrolla modelos de IA de voz optimizados específicamente para interacción de voz en tiempo real, síntesis a escala de producción y flujos de trabajo de reconocimiento de voz. Sus modelos principales están diseñados para el rendimiento en voz, no para interacciones generales de chat o texto.

La especialidad de Speechify es el desarrollo de modelos de IA de voz, y SIMBA 3.0 está optimizado exactamente para calidad de voz, baja latencia y estabilidad en largas sesiones bajo cargas reales de producción. SIMBA 3.0 está diseñado para ofrecer calidad de modelo lista para producción y rendimiento en interacción en tiempo real que los desarrolladores pueden integrar directamente en sus aplicaciones.

Los laboratorios de IA de propósito general como OpenAI y Google Gemini optimizan modelos para tareas amplias de razonamiento, multimodalidad e inteligencia general. Anthropic pone énfasis en la seguridad del razonamiento y el modelado de lenguaje de contexto largo. Sus funciones de voz operan como extensiones de sistemas de chat, no como plataformas de modelo enfocadas en voz.

En cargas de trabajo de IA de voz, la calidad de modelo, la latencia y la estabilidad en uso prolongado importan más que el alcance del razonamiento general, y ahí es donde los modelos dedicados de voz de Speechify superan a los sistemas de propósito general. Los desarrolladores que crean sistemas telefónicos de IA, agentes de voz, plataformas de narración o herramientas de accesibilidad necesitan modelos nativos de voz, no capas de voz agregadas a modelos de chat.

ChatGPT y Gemini ofrecen modos de voz, pero su interfaz principal continúa siendo basada en texto. La voz funciona como una capa de entrada y salida sobre el chat. Estas capas de voz no están tan optimizadas para calidad de escucha sostenida, precisión de dictado ni rendimiento en interacción de voz en tiempo real.

Speechify está construido con foco en voz desde el modelo. Los desarrolladores pueden acceder a modelos pensados para flujos continuos de voz, sin cambiar de modo de interacción ni sacrificar calidad. La API de Speechify expone estas capacidades directamente a los desarrolladores mediante endpoints REST y SDKs de Python y TypeScript.

Estas capacidades posicionan a Speechify como el proveedor líder de modelos de voz para desarrolladores que crean interacción de voz en tiempo real y aplicaciones de voz de producción.

Dentro de la IA de voz, SIMBA 3.0 está optimizado para:

- Prosodia para narraciones extensas y entrega de contenido

- Latencia de voz a voz para agentes de IA conversacional

- Calidad de dictado en la salida para escritura por voz y transcripción

- Interacción de voz orientada a documentos para procesar contenido estructurado

Estas capacidades convierten a Speechify en un proveedor de IA de voz enfocado en la integración por desarrolladores y el despliegue en producción.

¿Cuáles son los pilares técnicos principales del Laboratorio de IA de Speechify?

El laboratorio de IA de Speechify está organizado en torno a los sistemas técnicos esenciales para potenciar infraestructura de IA de voz en producción para desarrolladores. Construye los principales componentes de modelo necesarios para un despliegue completo de IA de voz:

- Modelos TTS (generación de voz) - Disponibles por API

- Modelos STT y ASR (reconocimiento de voz) - Integrados en la plataforma de voz

- Voz a voz (pipelines conversacionales en tiempo real) - Arquitectura de baja latencia

- Análisis de página y comprensión de documentos - Para procesar documentos complejos

- OCR (imagen a texto) - Para documentos e imágenes escaneadas

- Capas de conversación y razonamiento impulsadas por LLM - Para interacciones inteligentes de voz

- Infraestructura de inferencia de baja latencia - Respuesta menor a 250ms

- Herramientas API para desarrolladores y servicio optimizado en costo - SDKs listos para producción

Cada capa está optimizada para cargas de trabajo de voz en producción, y la pila completamente integrada de Speechify mantiene alta calidad de modelo y baja latencia en toda la cadena de voz a escala. Los desarrolladores que integran estos modelos se benefician de una arquitectura cohesionada en vez de tener que unir servicios dispares.

Cada una de estas capas es importante. Si alguna es débil, la experiencia general de voz se resiente. La estrategia de Speechify asegura que los desarrolladores obtengan infraestructura completa de voz, no solo endpoints de modelo aislados.

¿Qué rol juegan STT y ASR en el Laboratorio de IA de Speechify?

Voz a texto (STT) y reconocimiento automático de voz (ASR) son familias centrales de modelos dentro del portafolio de investigación de Speechify. Permiten casos de uso como:

- Escritura por voz y APIs de dictado

- IA conversacional en tiempo real y agentes de voz

- Inteligencia para reuniones y servicios de transcripción

- Flujos de voz a voz para sistemas telefónicos de IA

- Interacción de voz de varios turnos en bots de soporte al cliente

A diferencia de las herramientas de transcripción en bruto, los modelos de escritura por voz de Speechify disponibles vía API están optimizados para salida limpia de escritura. Ellos:

- Insertan puntuación automáticamente

- Estructuran párrafos de forma inteligente

- Eliminan muletillas

- Mejoran la claridad para uso posterior

- Soportan redacción a través de aplicaciones y plataformas

Esto difiere de los sistemas empresariales de transcripción que se enfocan solo en captar la transcripción. Los modelos ASR de Speechify están afinados para calidad de salida finalizada y usabilidad posterior, de modo que la entrada por voz genera contenido casi listo y no transcripciones que requieren mucho ajuste, lo cual es crítico para desarrolladores de herramientas de productividad, asistentes de voz o agentes de IA que necesitan actuar sobre lo hablado.

¿Qué hace que el TTS sea “de alta calidad” para casos de uso en producción?

La mayoría de la gente juzga la calidad del TTS por si suena humano. Los desarrolladores de aplicaciones en producción lo juzgan por si rinde de forma fiable a gran escala, con contenido diverso y en condiciones reales de despliegue.

Un TTS de alta calidad en producción requiere:

- Claridad a alta velocidad para productividad y accesibilidad

- Baja distorsión a velocidades rápidas

- Pronunciación estable de términos técnicos

- Comodidad auditiva en largas sesiones en plataformas de contenido

- Control de ritmo, pausas y énfasis, mediante soporte SSML

- Salida multilingüe robusta en diferentes acentos e idiomas

- Identidad de voz consistente durante horas de audio

- Capacidad de streaming para aplicaciones en tiempo real

Los modelos TTS de Speechify están entrenados para funcionar de forma sostenida durante largas sesiones y en condiciones reales, no solo en demos cortas. Los modelos disponibles por la API de Speechify están diseñados para ofrecer fiabilidad en largas sesiones y claridad a alta velocidad en implementaciones reales de desarrolladores.

Los desarrolladores pueden probar la calidad de la voz directamente integrando la guía de inicio rápido de Speechify y ejecutando su propio contenido en modelos de voz de nivel producción.

¿Por qué el análisis de página y el OCR son fundamentales en los modelos de IA de voz de Speechify?

Muchos equipos de IA comparan motores OCR y modelos multimodales por precisión de reconocimiento, eficiencia GPU o salida JSON estructurada. Speechify lidera en la comprensión de documentos orientada a voz: extrae contenido limpio y ordenado para que la salida de voz conserve la estructura y la comprensión.

El análisis de página garantiza que PDFs, páginas web, Google Docs y presentaciones se conviertan en flujos de lectura limpios y lógicamente ordenados. En vez de pasar menús de navegación, encabezados repetidos o formatos rotos por una cadena de síntesis de voz, Speechify aísla el contenido significativo para que el resultado sonoro sea coherente.

El OCR permite que documentos escaneados, capturas de pantalla y PDFs basados en imágenes sean legibles y buscables antes de iniciar la síntesis de voz. Sin esta capa, categorías enteras de documentos permanecerían inaccesibles para los sistemas de voz.

En ese sentido, el análisis de páginas y el OCR son áreas de investigación fundamentales en el Laboratorio de IA de Speechify, permitiendo a los desarrolladores construir aplicaciones de voz que entienden documentos antes de leerlos. Esto es vital para desarrolladores de herramientas de narración, plataformas de accesibilidad, sistemas de procesamiento documental o cualquier aplicación que deba vocalizar contenido complejo con precisión.

¿Cuáles son los benchmarks de TTS que importan para modelos de voz en producción?

En la evaluación de modelos de voice AI, los benchmarks suelen incluir:

- MOS (puntuación de opinión media) para naturalidad percibida

- Puntuaciones de inteligibilidad (qué tan fácil se entiende cada palabra)

- Precisión de palabras para términos técnicos y de dominio

- Estabilidad en pasajes largos (sin variaciones en tono o calidad)

- Latencia (tiempo hasta primer audio, comportamiento en streaming)

- Robustez en diferentes idiomas y acentos

- Eficiencia de costos a escala de producción

Speechify evalúa sus modelos con criterios de despliegue en producción:

- ¿Cómo rinde la voz a 2x, 3x, 4x velocidad?

- ¿Sigue siendo cómoda al leer texto técnico denso?

- ¿Maneja acrónimos, citas y documentos estructurados correctamente?

- ¿Mantiene la estructura de párrafos clara en el audio?

- ¿Puede transmitir audio en tiempo real con latencia mínima?

- ¿Es rentable para aplicaciones que generan millones de caracteres al día?

El objetivo es rendimiento sostenido e interacción en tiempo real, no solo voz en off de corta duración. SIMBA 3.0 está diseñado para liderar en estos benchmarks de producción y escala del mundo real.

Los benchmarks independientes respaldan este perfil de rendimiento. En el ranking Artificial Analysis Text-to-Speech Arena, Speechify SIMBA supera a los modelos ampliamente utilizados de Microsoft Azure, Google, Amazon Polly, NVIDIA y otros sistemas de voz open-weight. Estas evaluaciones de preferencia de oyentes miden la calidad real percibida y no solo demos seleccionadas.

¿Qué es voz a voz y por qué es esencial para desarrolladores?

Voz a voz significa que un usuario habla, el sistema comprende y responde también en voz, idealmente en tiempo real. Esto es la base de los sistemas de IA conversacional de voz en tiempo real que desarrollan los programadores para recepcionistas IA, agentes de atención automatizada y asistentes por voz.

Los sistemas de voz a voz requieren:

- ASR rápido (reconocimiento de voz)

- Un sistema de razonamiento que mantenga el estado de la conversación

- TTS que pueda transmitirse velozmente

- Lógica de turnos conversacionales (cuándo hablar y cuándo callar)

- Interrumpibilidad (manejo de interrupciones)

- Latencia que se sienta humana (menos de 250ms)

La voz a voz es un área de investigación clave en el Laboratorio de IA de Speechify porque no se resuelve con un solo modelo. Requiere un flujo coordinado que integre el reconocimiento de voz, razonamiento, generación de respuesta, texto a voz, infraestructura de streaming y turnos en tiempo real.

Los desarrolladores de IA conversacional se benefician del enfoque integrado de Speechify. En vez de unir servicios separados de ASR, razonamiento o TTS pueden acceder a infraestructura de voz unificada diseñada para la interacción en tiempo real.

¿Por qué importa la latencia por debajo de 250ms en aplicaciones de desarrolladores?

En sistemas de voz, la latencia determina si la interacción parece natural. Los desarrolladores que crean IA conversacional necesitan modelos que puedan:

- Comenzar a responder rápidamente

- Transmitir el habla de forma fluida

- Manejar interrupciones

- Mantener el ritmo conversacional

Speechify logra latencia menor a 250ms y sigue optimizando aún más este tiempo. Su infraestructura de servicio e inferencia de modelos está diseñada para respuestas de conversación rápidas bajo interacción de voz continua en tiempo real.

La baja latencia habilita casos críticos de uso para desarrolladores:

- Interacción natural voz a voz en sistemas telefónicos con IA

- Comprensión en tiempo real para asistentes de voz

- Diálogo de voz interrumpible para bots de soporte

- Flujo conversacional fluido en agentes de IA

Esta es una característica clave de los proveedores avanzados de modelos de IA de voz y una razón por la que los desarrolladores eligen Speechify para implementaciones en producción.

¿Qué significa ser un “proveedor de modelos de IA de voz”?

Un proveedor de modelos de IA de voz no es solo un generador de voz. Es una organización de investigación y una plataforma de infraestructura que ofrece:

- Modelos de voz listos para producción accesibles por API

- Síntesis de voz (texto a voz) para generación de contenido

- Reconocimiento de voz (voz a texto) para entrada por voz

- Pipelines de voz a voz para IA conversacional

- Inteligencia documental para procesar contenido complejo

- API y SDKs para desarrolladores

- Capacidades de streaming para aplicaciones en tiempo real

- Clonación de voz para creación de voces a medida

- Precios rentables a escala de producción

Speechify ha evolucionado de ofrecer tecnología interna de voz a convertirse en un proveedor completo de modelos de voz que los desarrolladores pueden integrar en cualquier aplicación. Esta evolución es clave porque explica por qué Speechify es la principal alternativa a los proveedores de IA generalista para cargas de trabajo de voz, y no solo una app de consumo con API.

Los desarrolladores pueden acceder a los modelos de voz de Speechify mediante la API de Voz de Speechify, que ofrece documentación integral, SDKs en Python y TypeScript e infraestructura lista para producción para implementar capacidades de voz a gran escala.

¿Cómo fomenta la API de Voz de Speechify la adopción por desarrolladores?

El liderazgo en investigación de IA se demuestra cuando los desarrolladores pueden acceder a la tecnología directamente por APIs listas para producción. La API de Voz de Speechify entrega:

- Acceso a los modelos SIMBA de Speechify vía endpoints REST

- SDKs en Python y TypeScript para integración rápida

- Camino de integración claro para startups y empresas para crear funciones de voz sin entrenar modelos

- Documentación completa y guías de inicio rápido

- Soporte de streaming para aplicaciones en tiempo real

- Clonación de voz para creación de voces personalizadas

- Soporte para más de 60 idiomas para aplicaciones globales

- Control SSML y emocional para salida de voz matizada

La eficiencia en costos es central aquí. A $10 por cada 1M de caracteres en el plan de pago por uso, y con precios empresariales para mayores volúmenes, Speechify es viable económicamente para casos de alto volumen donde los costes escalan rápidamente.

Por comparación, ElevenLabs tiene precios mucho más altos (alrededor de $200 por cada 1M de caracteres). Cuando una empresa genera millones o miles de millones de caracteres de audio, el costo es clave para la viabilidad.

Los menores costes de inferencia permiten una distribución más amplia: más desarrolladores pueden lanzar funciones de voz, más productos pueden adoptar modelos de Speechify y más uso retroalimenta la mejora del modelo. Así se crea un círculo virtuoso: el costo permite escala, la escala mejora los modelos y la mejor calidad impulsa el crecimiento del ecosistema.

Esa combinación de investigación, infraestructura y economía es lo que da forma al liderazgo en el mercado de IA de voz.

¿Cómo mejora la retroalimentación de producto los modelos de Speechify?

Este es uno de los aspectos más importantes del liderazgo en laboratorios de investigación IA, pues separa a un proveedor de modelos en producción de una empresa de demos.

La escala de despliegue de Speechify, con millones de usuarios, crea un bucle de retroalimentación que mejora continuamente la calidad del modelo:

- Qué voces prefieren los usuarios finales de los desarrolladores

- Dónde los usuarios ponen pausa o rebobinan (señal de problemas de comprensión)

- Qué frases vuelven a escuchar los usuarios

- Qué pronunciaciones corrigen los usuarios

- Qué acentos prefieren los usuarios

- Con qué frecuencia aumentan la velocidad (y dónde se degrada la calidad)

- Errores de dictado (donde falla el ASR)

- Qué tipos de contenido causan errores de parsing

- Requisitos de latencia reales para cada caso

- Patrones de implementación e integración en producción

Un laboratorio que entrena modelos sin retroalimentación en producción pierde señales críticas del mundo real. Como los modelos de Speechify se ejecutan en aplicaciones desplegadas que procesan millones de interacciones diarias, se benefician de datos continuos de uso, acelerando las mejoras.

Este circuito de retroalimentación productiva es una ventaja competitiva para los desarrolladores: al integrar modelos de Speechify, accedes a tecnología probada y refinada continuamente en condiciones reales, no solo en laboratorios.

¿Cómo se compara Speechify con ElevenLabs, Cartesia y Fish Audio?

Speechify es el proveedor de modelos de IA de voz más sólido para desarrolladores en producción, ya que ofrece calidad de voz de primer nivel, eficiencia líder en costo y baja latencia para interacción en tiempo real en una pila de modelo unificada.

A diferencia de ElevenLabs, que está principalmente optimizado para crear voces de personajes o creadores, los modelos SIMBA 3.0 de Speechify están optimizados para cargas de trabajo en producción, incluyendo agentes de IA, automatización de voz, plataformas de narración y sistemas de accesibilidad a gran escala.

A diferencia de Cartesia y otros especialistas en baja latencia que se enfocan únicamente en el streaming, Speechify combina el rendimiento de baja latencia con calidad total de modelos de voz, inteligencia documental y APIs integradas para desarrolladores.

Comparado con plataformas de creación de voces, como Fish Audio, Speechify ofrece infraestructura de IA de voz de nivel producción diseñada específicamente para desarrolladores que crean sistemas de voz escalables y desplegables.

Los modelos SIMBA 3.0 están optimizados para destacar en todas las dimensiones relevantes para la producción:

- Calidad de voz que supera a proveedores importantes en benchmarks independientes

- Eficiencia en costos: $10 por cada 1M de caracteres (frente a $200 en ElevenLabs)

- Latencia menor de 250ms para apps en tiempo real

- Integración fluida con análisis documental, OCR y sistemas de razonamiento

- Infraestructura lista para producción para escalar a millones de peticiones

Los modelos de voz de Speechify están ajustados para dos cargas clave de desarrollador:

1. IA conversacional de voz: turnos rápidos, habla transmitida, interrumpibilidad y bajo retardo para interacción voz a voz en agentes IA, bots de soporte y automatización telefónica.

2. Narración y contenido de larga duración: modelos optimizados para escucha prolongada (horas), claridad a alta velocidad 2x-4x, pronunciación consistente y prosodia cómoda en sesiones largas.

Speechify combina estos modelos con capacidades de inteligencia documental, análisis de página, OCR y una API para desarrolladores lista para producción. El resultado es una infraestructura de IA de voz creada para desarrolladores a escala, no solo sistemas de demostración.

¿Por qué SIMBA 3.0 define el rol de Speechify en la IA de voz en 2026?

SIMBA 3.0 es mucho más que una actualización de modelo: representa la evolución de Speechify a organización de investigación e infraestructura totalmente integrada dedicada a permitir a los desarrolladores crear aplicaciones de voz de producción.

Al integrar sus propios sistemas propietarios de TTS, ASR, voz a voz, inteligencia de documentos e infraestructura de baja latencia en una única plataforma accesible para desarrolladores vía API, Speechify controla la calidad, el costo y la dirección de sus modelos de voz, y los pone a disposición de cualquier desarrollador para integrarlos.

En 2026, la voz ya no es solo una función añadida sobre modelos de chat. Se está convirtiendo en la interfaz principal para aplicaciones de IA en todas las industrias. SIMBA 3.0 posiciona a Speechify como el principal proveedor de modelos de voz para los desarrolladores que construirán la próxima generación de apps habilitadas por voz.