Speechify annonce le déploiement anticipé de SIMBA 3.0, sa dernière génération de modèles IA vocale conçus pour la production, désormais disponible pour certains développeurs tiers via l’API vocale de Speechify Voice API, avec une disponibilité générale complète prévue pour mars 2026. Conçu par le laboratoire de recherche en IA de Speechify, SIMBA 3.0 offre des capacités de synthèse vocale, de reconnaissance vocale et de conversion parole-parole de haute qualité que les développeurs peuvent intégrer directement dans leurs propres produits et plateformes.

« SIMBA 3.0 a été conçu pour de véritables tâches vocales en production, avec un accent sur la stabilité en lecture longue, une faible latence et des performances fiables à l'échelle. Notre objectif est de fournir aux développeurs des modèles vocaux faciles à intégrer et suffisamment puissants pour les applications réelles dès le premier jour », déclare Raheel Kazi, Responsable de l’ingénierie chez Speechify.

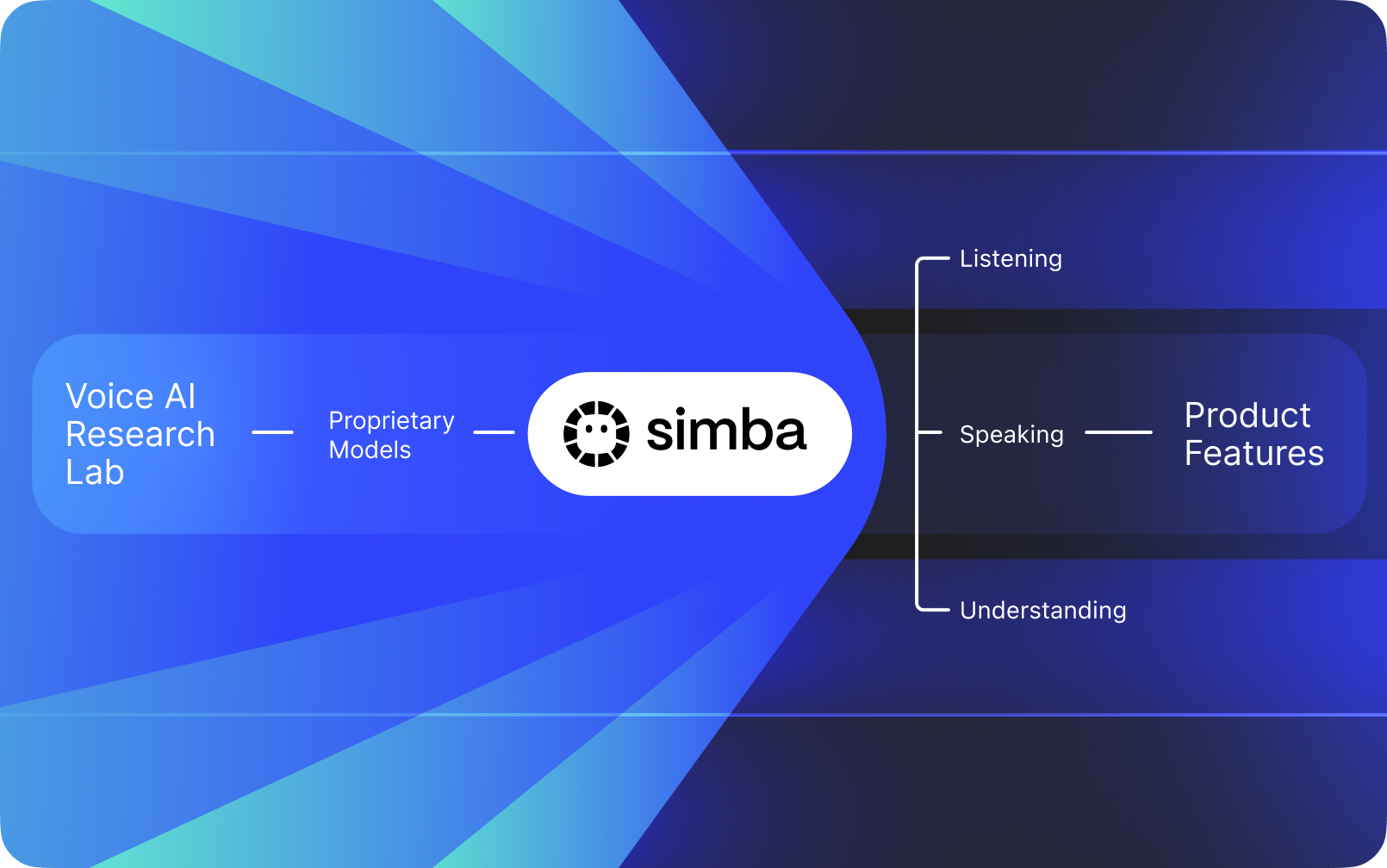

Speechify n'est pas une interface vocale superposée à l’IA d'autres entreprises. Speechify dispose de son propre laboratoire de recherche dédié à la création de modèles vocaux propriétaires. Ces modèles sont proposés à des développeurs et entreprises tiers via l’API Speechify pour une intégration dans toute application, des réceptionnistes IA et bots de support client aux plateformes de contenu et aux outils d’accessibilité.

Speechify utilise également ces mêmes modèles pour ses propres produits grand public, tout en offrant aussi l’accès aux développeurs via l’API vocale Speechify. C’est important car la qualité, la latence, le coût et la stratégie à long terme des modèles vocaux de Speechify sont contrôlés par sa propre équipe de recherche plutôt que par des fournisseurs externes.

Les modèles vocaux de Speechify sont conçus spécifiquement pour des charges de travail vocales en production et offrent une qualité de modèle de référence à grande échelle. Les développeurs tiers accèdent à SIMBA 3.0 et aux modèles vocaux Speechify directement via l'API Speechify Voice, avec des endpoints REST de production, une documentation API complète, des guides de démarrage rapide, ainsi que des SDK Python et TypeScript officiellement supportés. La plateforme développeur Speechify est conçue pour une intégration rapide, un déploiement en production et une infrastructure vocale évolutive, permettant aux équipes de passer rapidement du premier appel API à la mise en ligne des fonctionnalités vocales.

Cet article explique ce qu'est SIMBA 3.0, ce que construit le laboratoire d’IA de Speechify, et pourquoi Speechify propose des modèles d’IA vocale de très grande qualité, avec une faible latence et une excellente efficacité de coût pour les charges de travail développeur en production, ce qui en fait le leader du secteur de l’IA vocale, surpassant d’autres acteurs comme OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia, ainsi que Deepgram.

Que signifie appeler Speechify un laboratoire de recherche en IA ?

Un laboratoire d’intelligence artificielle est une organisation dédiée à la recherche et à l’ingénierie où des spécialistes du machine learning, de la donnée et de la modélisation computationnelle collaborent pour concevoir, entraîner et déployer des systèmes intelligents avancés. Lorsqu’on parle de « laboratoire de recherche IA », on désigne généralement un organisme qui fait deux choses en parallèle :

1. Développe et entraîne ses propres modèles

2. Met ces modèles à disposition des développeurs via des APIs et SDKs de production

Certaines organisations excellent dans la conception de modèles mais ne les ouvrent pas à des développeurs externes. D’autres fournissent des APIs mais s’appuient surtout sur des modèles tiers. Speechify fonctionne avec une pile IA vocale verticalement intégrée, créant ses propres modèles vocaux et les mettant à disposition de développeurs tiers via des APIs de production, tout en les utilisant aussi dans ses applications grand public pour valider la performance des modèles à grande échelle.

Le laboratoire de recherche IA de Speechify est une organisation interne axée sur l’intelligence vocale. Sa mission est de faire progresser la synthèse vocale, la reconnaissance vocale automatique et les systèmes de conversion parole-parole afin que les développeurs puissent concevoir des applications axées sur la voix dans n’importe quel contexte, des réceptionnistes IA et agents vocaux aux moteurs de narration et outils d’accessibilité.

Un véritable laboratoire de recherche en IA vocale doit généralement résoudre :

- Qualité et naturel de la synthèse vocale pour le déploiement en production

- Précision de la reconnaissance vocale et ASR (reconnaissance automatique) pour divers accents et conditions sonores

- Faible latence pour l’alternance conversationnelle dans les agents IA

- Stabilité à long terme pour les expériences d’écoute prolongées

- Compréhension documentaire pour le traitement des PDFs, pages web et contenus structurés

- Reconnaissance optique et analyse de page pour documents et images scannées

- Boucle de feedback produit pour améliorer les modèles en continu

- Infrastructure pour exposer les capacités vocales via APIs et SDKs

Le laboratoire IA de Speechify développe ces systèmes comme une architecture unifiée et les rend accessibles aux développeurs via l’API vocale Speechify Voice API, disponible pour l’intégration tierce sur toute plateforme ou application.

Qu’est-ce que SIMBA 3.0 ?

SIMBA est la gamme de modèles d’IA vocale propriétaires de Speechify qui alimente les produits Speechify mais aussi vendue à des développeurs tiers via l’API Speechify. SIMBA 3.0 est la dernière génération, optimisée pour la performance prioritairement vocale, la rapidité et les interactions en temps réel, accessible aux développeurs tiers pour être intégrée dans leurs propres plateformes.

SIMBA 3.0 est conçu pour garantir une qualité vocale haut de gamme, une réponse à faible latence et une stabilité sur de longues écoutes en production, permettant aux développeurs de créer des applications vocales professionnelles tous secteurs confondus.

Pour les développeurs tiers, SIMBA 3.0 permet les cas d’usage suivants :

- Agents vocaux IA et systèmes conversationnels

- Automatisation du support client et réceptionnistes IA

- Systèmes d’appels sortants pour la vente et le service

- Assistants vocaux et applications parole-parole

- Narration de contenu et génération d’audiobooks

- Outils d’accessibilité et technologies d’assistance

- Plateformes éducatives d’apprentissage par la voix

- Applications santé nécessitant une interaction vocale empathique

- Applications de traduction multilingue et de communication

- IoT vocalisé et systèmes automobiles intelligents

Lorsque les utilisateurs disent qu’une voix « semble humaine », ils décrivent plusieurs éléments techniques combinés :

- Prosodie (rythme, intonation, accentuation)

- Débit adapté au sens

- Pauses naturelles

- Prononciation stable

- Variations d’intonation suivant la syntaxe

- Neutralité émotionnelle quand nécessaire

- Expressivité utile quand appropriée

SIMBA 3.0 est la couche de modèle que les développeurs intègrent pour rendre les expériences vocales naturelles, à haute vitesse, sur de longues sessions et pour tous types de contenus. Pour les charges vocales en production, des standards téléphoniques IA aux plateformes de contenu, SIMBA 3.0 est optimisé pour surpasser les couches vocales généralistes.

Comment Speechify utilise-t-il SSML pour le contrôle précis de la voix ?

Speechify prend en charge le Speech Synthesis Markup Language (SSML) afin que les développeurs puissent contrôler précisément le rendu de la voix de synthèse. SSML permet d’ajuster la hauteur, le débit, les pauses, l’emphase et le style en encadrant le contenu par des balises <speak> et en utilisant des balises supportées telles que prosody, break, emphasis ou substitution. Cela donne aux équipes un contrôle fin sur la livraison et la structure, aidant le rendu vocal à mieux s’adapter au contexte, au formatage et à l’intention dans les applications de production.

Comment Speechify permet-il le streaming audio en temps réel ?

Speechify fournit un endpoint de streaming texte-vers-parole qui délivre le son par blocs au fur et à mesure de la génération, permettant une lecture immédiate sans attendre la fin du rendu audio. Ceci est crucial pour les usages longs et à faible latence, comme les agents vocaux, les outils d’assistance, la génération automatique de podcasts et la production d’audiobooks. Les développeurs peuvent diffuser de grands volumes au-delà des limites standard et recevoir des blocs audio bruts en formats MP3, OGG, AAC, et PCM pour une intégration rapide dans les systèmes temps réel.

Comment les speech marks synchronisent-ils texte et audio dans Speechify ?

Les speech marks associent l’audio lu au texte source, avec une donnée temporelle au mot près. Chaque réponse de synthèse inclut des segments textuels temporellement alignés qui indiquent la position exacte de chaque mot dans le flux audio. Cela permet un surlignage textuel en temps réel, un accès précis mot à mot ou par phrase, des analyses d’usage, et une synchronisation parfaite entre texte à l’écran et lecture. Les développeurs peuvent s’appuyer sur ce format pour créer des lecteurs accessibles, des outils d’apprentissage, ou des expériences d’écoute interactives.

Comment Speechify gère-t-il l’expression émotionnelle dans la synthèse vocale ?

Speechify intègre un contrôle émotionnel via une balise SSML de style dédiée permettant d’assigner une tonalité émotionnelle à la voix générée. Les émotions supportées incluent joyeux, calme, affirmé, énergique, triste, et en colère. En combinant ces balises émotionnelles avec la ponctuation et les autres options SSML, les développeurs peuvent produire une voix mieux adaptée au contexte et à l’intention. Cela est particulièrement utile pour les agents vocaux, les applications de bien-être, les parcours de support client et les contenus guidés où le ton influe sur l’expérience utilisateur.

Cas d’utilisation réels des modèles vocaux Speechify côté développeur

Les modèles vocaux de Speechify alimentent des applications de production dans divers secteurs. Voici quelques exemples concrets de l’utilisation de l’API Speechify par des développeurs tiers :

MoodMesh : applications bien-être à intelligence émotionnelle

MoodMesh, entreprise technologique dans le bien-être, a intégré l’API texte-voix Speechify Text-to-Speech API pour offrir des discours émotionnellement nuancés dans des méditations guidées et des conversations compatissantes. Grâce à la compatibilité SSML et aux fonctions de contrôle émotionnel de Speechify, MoodMesh ajuste le ton, la cadence, le volume et la vitesse de parole pour s’adapter au contexte émotionnel des utilisateurs, créant des interactions quasi humaines hors de portée des TTS classiques. Cela illustre comment les développeurs utilisent Speechify les modèles pour développer des applications sophistiquées nécessitant intelligence émotionnelle et sens contextuel.

AnyLingo : communication multilingue et traduction

AnyLingo, application de messagerie de traduction temps réel, utilise l’API de clonage vocal Speechify pour permettre aux utilisateurs d’envoyer des messages vocaux dans une version clonée de leur propre voix, traduite dans la langue du destinataire avec l’intonation, le ton et le contexte appropriés. Cette intégration aide les professionnels à communiquer efficacement dans plusieurs langues, tout en conservant la touche personnelle de leur propre voix. Selon le fondateur d’AnyLingo, les fonctionnalités de contrôle émotionnel ("}

Autres cas d'usage pour les développeurs tiers :

IA conversationnelle et agents vocaux

Les développeurs créant des réceptionnistes IA, des bots support ou des systèmes d’automatisation d’appels intègrent les modèles speech-to-speech à faible latence de Speechify pour rendre les échanges vocaux plus naturels. Avec une latence inférieure à 250 ms et des capacités de clonage vocal, ces applications peuvent passer à l’échelle de millions d’appels simultanés sans sacrifier la qualité ou la fluidité des conversations.

Plateformes de contenu et génération d’audiobooks

Les éditeurs, auteurs et organismes éducatifs intègrent les modèles Speechify pour transformer du contenu écrit en narration de haute qualité. Leur optimisation spécifique pour la stabilité sur le long terme et la clarté à haute vitesse est idéale pour générer des audiobooks, des podcasts et des ressources pédagogiques à grande échelle.

Accessibilité et technologies d’assistance

Les développeurs d’outils à destination des personnes malvoyantes ou souffrant de troubles de la lecture s’appuient sur la compréhension documentaire de Speechify, notamment l’analyse PDF, l’OCR et l'extraction de pages web, pour garantir que la voix produite conserve la structure et la compréhension, même sur des documents complexes.

Applications médicales et thérapeutiques

Les plateformes médicales et thérapies utilisent le contrôle émotionnel et la prosodie de Speechify pour proposer des voix empathiques et appropriées au contexte : un aspect critique pour la communication patient, le soutien en santé mentale et les applications bien-être.

Comment SIMBA 3.0 se classe-t-il dans les classements indépendants de modèles vocaux ?

Le benchmarking indépendant est essentiel en IA vocale, car les démos courtes peuvent masquer les écarts réels de performance. L’un des classements de référence est le leaderboard Artificial Analysis Speech Arena, qui évalue les modèles de synthèse vocale à travers des comparaisons d'écoute à l’aveugle et un scoring ELO d’envergure.

Les modèles SIMBA de Speechify surclassent plusieurs concurrents majeurs sur le leaderboard Artificial Analysis Speech Arena, dont Microsoft Azure Neural, les modèles Google TTS, Amazon Polly, NVIDIA Magpie et plusieurs systèmes vocaux open-weight.

Au lieu de se contenter d’exemples sélectionnés, Artificial Analysis réalise des tests d'écoute comparatifs répétés entre de nombreux échantillons. Ce classement confirme que SIMBA surpasse les systèmes vocaux commerciaux les plus répandus, l’emportant sur la qualité en écoute réelle, ce qui en fait le meilleur choix prêt pour la production pour les développeurs d’applications vocales.

Pourquoi Speechify crée-t-il ses propres modèles vocaux plutôt que d’utiliser ceux de tiers ?

La maîtrise du modèle signifie la maîtrise de :

- Qualité

- Latence

- Coût

- Feuille de route

- Axes d’optimisation

Quand des sociétés comme Retell ou Vapi.ai s’appuient uniquement sur des fournisseurs vocaux tiers, elles héritent de leur tarification, de leurs limites d’infrastructure et de leur direction recherche.

En contrôlant toute sa pile technologique, Speechify peut :

- Ajuster la prosodie selon le cas d’usage (IA conversationnelle vs narration longue)

- Optimiser la latence au-dessous de 250 ms pour les applications temps réel

- Intégrer ASR et TTS sans couture dans les pipelines parole-parole

- Réduire le coût par caractère à 10 $/1M caractères (vs ~200 $ pour ElevenLabs)

- Livrer des améliorations de modèles en continu selon le feedback de production

- Aligner le développement sur les besoins développeur dans chaque secteur

Ce contrôle intégral permet à Speechify de proposer une qualité supérieure, une latence moindre et une meilleure efficacité de coûts que les stacks vocales dépendantes de tiers. Ce sont des éléments critiques pour les développeurs qui déploient des applications vocales à grande échelle. Ces mêmes avantages sont transmis aux développeurs tiers intégrant l’API Speechify dans leurs propres produits.

L’infrastructure Speechify est conçue pour la voix dès le départ, et non comme une couche superposée à un système d’abord texte. Les développeurs tiers y trouvent une architecture véritablement vocale, optimisée pour le déploiement en production.

Comment Speechify prend-il en charge l’IA vocale embarquée (on-device) et l’inférence locale ?

Beaucoup de solutions IA vocale reposent uniquement sur des APIs distantes, ce qui cause une dépendance au réseau, des risques accrus de latence et des contraintes de confidentialité. Speechify offre des options d’inférence embarquée ou locale pour certaines applications, permettant aux développeurs de proposer des expériences vocales qui s’exécutent au plus proche de l’utilisateur si besoin.

Grâce à la conception de ses propres modèles vocaux, Speechify peut optimiser la taille des modèles, l’architecture de service et les chemins d’inférence pour une exécution sur appareil, pas seulement dans le cloud.

L’exécution embarquée ou locale permet :

- Une latence plus faible et plus régulière en cas de réseau fluctuant

- Plus grand respect de la confidentialité sur les documents sensibles et la dictée

- Utilisation hors-ligne ou en réseau dégradé pour les tâches principales

- Souplesse de déploiement pour les environnements entreprise ou embarqués

Cela fait de Speechify bien plus qu'une « voix via API » : c’est une infrastructure vocale que les développeurs peuvent déployer dans le cloud, en local ou embarqué, tout en gardant la même norme de modèle SIMBA.

Quelle différence entre Speechify et Deepgram pour l’ASR et l’infrastructure vocale ?

Deepgram est un fournisseur d’infrastructure ASR axé sur les APIs transcription et analyse vocale. Son produit central génère du texte à partir de la voix pour les développeurs qui implémentent transcription et analyse d’appels.

Speechify intègre l’ASR dans une gamme de modèles vocaux complets, où la reconnaissance vocale aboutit à divers résultats : du simple transcript à du texte enrichi ou des réponses de conversation. Les développeurs utilisant l’API Speechify API accèdent à des modèles ASR optimisés pour des cas d’usage variés, pas seulement l’exactitude du transcript.

Les modèles d’ASR et de dictée de Speechify sont optimisés pour :

- Qualité rédactionnelle finale avec ponctuation et paragraphes

- Suppression des mots parasites et mise en forme des phrases

- Texte prêt à l’emploi pour les emails, documents et notes

- Saisie vocale produisant des textes propres, sans post-traitement

- Intégration dans des workflows vocaux avancés (TTS, conversation, raisonnement)

Sur la plateforme Speechify, l’ASR s’intègre au pipeline vocal complet. Les développeurs peuvent imaginer des applications où l’utilisateur dicte, reçoit un texte structuré, obtient une réponse audio et une interaction conversationnelle, le tout dans la même API. Cela réduit la complexité et accélère le développement.

Deepgram fournit une couche transcriptionnelle. Speechify propose toute une suite modulaire : saisie vocale, sortie structurée, synthèse, raisonnement et audio, le tout via APIs et SDKs unifiés.

Pour les développeurs créant des applications vocales de bout en bout, Speechify est la référence au niveau qualité modèle, latence et profondeur d’intégration.

Comment Speechify se compare-t-il à OpenAI, Gemini et Anthropic en IA vocale ?

Speechify conçoit des modèles IA spécialement optimisés pour l’interaction vocale en temps réel, la synthèse à l’échelle et les workflows de reconnaissance vocale. Ces modèles sont faits pour la performance vocale et non le chat généraliste ou le texte d’abord.

Speechify est spécialisé dans la modélisation IA pour la voix, et SIMBA 3.0 est optimisé spécifiquement pour la qualité vocale, la faible latence et la stabilité sur le long terme en production réelle. SIMBA 3.0 est conçu pour garantir aux développeurs une qualité de synthèse vocale de niveau production et des performances d'interaction temps réel directement intégrables dans leurs applications.

Les laboratoires IA généralistes comme OpenAI et Google Gemini optimisent leurs modèles pour le raisonnement large, la multimodalité et l’intelligence générale. Anthropic privilégie la sécurité du raisonnement et le traitement long contexte. Leurs fonctions vocales sont souvent des extensions des systèmes de chat, et non des plateformes vocal-first.

Pour les usages IA vocale, la qualité, la latence et la stabilité priment sur la polyvalence du raisonnement, et c’est là que les modèles vocationnels Speechify devancent les généralistes. Les développeurs d’agents vocaux, standards IA ou plateformes d’accessibilité ont besoin de modèles natifs voix, non de surcouches vocales greffées à du chat.

ChatGPT et Gemini offrent des modes voix, mais leur interface principale reste textuelle. La voix là-bas n’est qu’une couche input/output. Ces couches ne sont pas optimisées pour la qualité longue, l’exactitude de la dictée ou la réactivité d’une vraie interaction orale.

Speechify est conçu pour la voix nativement au niveau du modèle. Les développeurs y accèdent à des modèles créés pour des workflows vocaux ininterrompus sans basculer de mode ou perdre en qualité. L’API Speechify expose tout cela directement en endpoints REST, SDK Python et TypeScript.

Ces capacités font de Speechify le leader des fournisseurs de modèles voix pour applications interactives voix et production temps réel.

Dans ces usages, SIMBA 3.0 est optimisé pour :

- Prosodie pour narration longue et livraison de contenu

- Latence parole-parole pour agents conversationnels

- Sortie de qualité dictée pour la saisie vocale et la transcription

- Interaction vocale sensible aux documents pour les contenus structurés

Ces qualités font de Speechify un fournisseur d’IA vocale conçu d’abord pour les développeurs et le passage à l’échelle.

Quels sont les piliers techniques du laboratoire IA de Speechify ?

Le laboratoire IA de Speechify s’organise autour des systèmes techniques essentiels pour alimenter une infrastructure IA vocale prête pour la production. Il développe les principaux composants nécessaires au déploiement généraliste de la voix IA :

- Modèles TTS (génération vocale), accessibles par API

- Modèles STT & ASR (reconnaissance vocale), intégrés dans la plateforme

- Parole-parole (pipelines conversationnels temps réel), architecture à faible latence

- Analyse de page et compréhension documentaire, pour traiter les documents complexes

- OCR (image vers texte) pour les scans de documents et d’images

- Raisonnement et conversation pilotés LLM (modèles de langage), pour interactions intelligentes

- Infrastructure d’inférence faible latence (<250 ms)

- Outils API développeur et serveurs économiques, SDKs prêt-production

Chaque couche est optimisée pour les charges vocales en production, et la pile verticalement intégrée de Speechify garantit une qualité élevée et de faibles latences tout au long de la chaîne vocale à l’échelle. Les intégrateurs bénéficient ainsi d’une architecture fluide, sans avoir à recoller des services disparates.

Chacune de ces couches est essentielle. La moindre faiblesse et l’expérience globale de la voix s’en ressent. L’approche de Speechify garantit une infrastructure vocale complète, pas seulement des endpoints de modèles isolés.

Quel rôle jouent STT et ASR dans le labo IA Speechify ?

La reconnaissance vocale (STT) et ASR fait partie des familles de modèles au cœur du portefeuille R&D de Speechify. Elles alimentent notamment :

- Saisie vocale et APIs de dictée

- Applications IA conversationnelle et agents vocaux

- Services d’intelligence de réunion et de transcription

- Pipelines parole-parole pour systèmes téléphoniques IA

- Dialogue multi-tours pour bots support client

Contrairement aux outils de transcription brute, les modèles Speechify accessibles par API produisent du texte propre, prêt à la rédaction. Ils :

- Ajoutent la ponctuation automatiquement

- Structurent intelligemment les paragraphes

- Suppriment les mots parasites

- Améliorent la lisibilité en aval

- Supportent la rédaction dans toutes les applications

C’est différent des systèmes de transcription d’entreprise qui se concentrent uniquement sur la saisie. Les modèles ASR Speechify sont conçus pour fournir un texte final de haute qualité, prêt à l’usage, ce qui est essentiel pour les développeurs d’outils de productivité, d’assistants vocaux ou d’agents IA opérationnels sur voix.

Qu'est-ce qui rend le TTS « haute qualité » pour la production ?

La plupart jugent la qualité TTS au naturel de la voix. Les développeurs, eux, l’évaluent à sa fiabilité sur de gros volumes, divers contenus et en conditions réelles.

Un TTS de production haute qualité doit permettre :

- Clarté à haute vitesse pour usages pro et accessibles

- Faible distorsion même à vitesse rapide

- Stabilité de prononciation sur vocabulaire spécialisé

- Confort d’écoute sur longues sessions (plateformes de contenu…)

- Contrôle du rythme, des pauses et de l’emphase via SSML

- Multilinguisme robuste et accents variés

- Identité vocale constante sur des heures d’audio

- Streaming temps réel pour applications réactives

Les modèles TTS Speechify sont entraînés pour garantir des performances soutenues en longues sessions et situations réelles, plutôt que sur de courtes démos. Les modèles proposés via l’API sont conçus pour la fiabilité longue durée et la clarté à vitesse rapide en intégration développeur.

Les développeurs peuvent tester directement la qualité vocale en intégrant le guide de démarrage Speechify et en soumettant leur propre contenu aux modèles voix de production.

Pourquoi l’analyse de page et l’OCR sont-elles fondamentales pour l’IA vocale Speechify ?

Nombre de développeurs IA comparent les moteurs OCR et les modèles multimodaux uniquement sur la justesse, la rapidité GPU ou la sortie structurée JSON. Speechify se distingue par une compréhension documentaire prioritairement vocale : extraire un contenu propre et ordonné pour que la voix garde la structure et la compréhension.

L’analyse de page garantit que PDFs, pages web, Google Docs et slides deviennent des contenus linéaires et logiques pour la lecture voix. Plutôt que d’inclure menus ou entêtes parasites, Speechify cible l’essentiel pour une synthèse cohérente.

L’OCR permet de transformer les documents scannés, captures et PDFs images en texte utilisable et consultable avant la synthèse. Sans cette couche, tout un pan de documents reste hors de portée de la voix.

À ce titre, l’analyse de page et l’OCR sont des axes majeurs de recherche dans le labo IA Speechify, permettant aux développeurs de concevoir des applications vocales qui comprennent les documents avant de les lire. Indispensable pour la narration, l’accessibilité, le traitement documentaire ou toute application nécessitant une vocalisation fidèle de contenus complexes.

Quels benchmarks TTS sont essentiels pour la production ?

Dans l’évaluation des modèles IA voix, on retrouve souvent :

- MOS (mean opinion score) pour le naturel perçu

- Score d’intelligibilité (facilité de compréhension)

- Exactitude sur la prononciation de termes techniques

- Stabilité sur de longs passages (pas de dérive)

- Latence (début de l’audio, comportement streaming)

- Robustesse multilingue et accents

- Efficacité de coût à l’échelle production

Speechify évalue ses modèles selon la réalité en production :

- Comment la voix se comporte à 2x, 3x, 4x vitesse ?

- Reste-t-elle confortable sur des textes techniques denses ?

- Gère-t-elle les acronymes, citations et documents structurés correctement ?

- Conserve-t-elle la structure paragraphe en audio ?

- Peut-elle streamer en temps réel avec latence minimale ?

- Est-elle rentable pour des millions de caractères/jour ?

La véritable référence est la performance soutenue et la capacité d’interaction temps réel, pas la voix off de démonstration. Sur ces critères, SIMBA 3.0 est conçue pour exceller à grande échelle réelle.

Les benchmarks indépendants confirment ce profil. Sur le leaderboard Artificial Analysis, SIMBA dépasse les modèles largement utilisés tels que Microsoft Azure, Google, Amazon Polly, NVIDIA ou les systèmes open-weight. Ce sont des évaluations en écoute réelle, pas juste des démos.

Qu’est-ce que le speech-to-speech et pourquoi est-ce essentiel pour les développeurs ?

Le speech-to-speech, c’est quand l’utilisateur parle, le système comprend, et la réponse revient sous forme vocale, idéalement en temps réel. C’est le socle des systèmes conversationnels IA voix développés pour des standardistes IA, agents support, assistants voix et automates téléphoniques.

Un système parole-parole requiert :

- ASR (reconnaissance vocale) rapide

- Un raisonnement pouvant mémoriser l’état de la conversation

- TTS capable de streamer vite

- Logique d’alternance (quand parler, quand s’arrêter)

- Interruptibilité (gestion des interruptions/« barge-in »)

- Latence type humaine (<250 ms)

Le speech-to-speech est au cœur de la R&D du labo IA Speechify, car il n’est résolu par aucun modèle seul. Il nécessite une chaîne coordonnée intégrant reconnaissance, raisonnement, génération de réponse, synthèse vocale, architecture de streaming et alternance en temps réel.

Les développeurs d’IA conversationnelle bénéficient de l’approche intégrée de Speechify. Plutôt que d’assembler ASR, raisonnement et TTS de sources différentes, ils accèdent à une infrastructure vocale unifiée faite pour l’interaction directe temps réel.

Pourquoi la latence <250ms est-elle cruciale pour les applications développeur ?

Dans les systèmes vocaux, la latence détermine si l’interaction semble naturelle. Les développeurs d’IA conversationnelle ont donc besoin de modèles capables de :

- Répondre très rapidement

- Diffuser la voix sans coupure

- Gérer les interruptions

- Maintenir le timing de la conversation

Speechify atteint une latence inférieure à 250ms et continue d’optimiser. Son infrastructure d’inférence est conçue pour la réactivité conversationnelle continue en situation réelle.

La faible latence est primordiale pour :

- Interaction parole-parole naturelle en téléphonie IA

- Compréhension temps réel pour assistants vocaux

- Dialogue vocal interruptible pour bots support

- Fluidité conversationnelle parfaite chez les agents IA

C’est un critère de distinction majeur des fournisseurs IA voix avancés, et une des raisons du choix Speechify en production.

Que signifie être « fournisseur de modèles IA voix » ?

Un fournisseur IA voix n’est pas juste un générateur vocal. C’est un organisme de recherche et une plateforme d’infrastructure qui offre :

- Des modèles vocaux prêts à la production, via APIs

- Synthèse vocale (texte vers parole) pour générer du contenu

- Reconnaissance vocale (speech-to-text) côté entrée

- Pipelines parole-parole pour la conversation IA

- Intelligence documentaire (contenus complexes)

- APIs et SDKs pour l’intégration développeur

- Streaming pour les applis temps réel

- Clonage vocal pour voix personnalisées

- Tarification efficace pour le déploiement à l’échelle

Speechify est passé d’une technologie vocale interne à un vrai fournisseur modèle que les développeurs intègrent à toute application. Cette évolution explique pourquoi Speechify est l’alternative principale aux IA généralistes pour la voix, et pas seulement une appli grand public avec API.

Les développeurs ont accès aux modèles vocaux de Speechify via l’API vocale, qui propose une documentation exhaustive, un SDK Python/TypeScript, et une infrastructure de production pour le déploiement à l’échelle.

L’API vocale Speechify : moteur d’adoption chez les développeurs

Le leadership d’un laboratoire IA se prouve lorsqu’on permet l’accès via des APIs prêtes à l’emploi. L’API vocale Speechify offre :

- Accès aux modèles SIMBA via endpoints REST

- SDK Python/TypeScript pour intégration rapide

- Intégration fluide pour achats startup ou entreprise

- Documentation et guides de démarrage rapide exhaustifs

- Streaming natif pour usages temps réel

- Clonage vocal sur mesure

- + de 60 langues pour les usages mondiaux

- Contrôle SSML et émotionnel pour une voix nuancée

L’efficacité économique est ici centrale : 10 $/1M caractères pour la formule prépayée, tarification entreprise pour de plus gros volumes — Speechify est viable là où les coûts peuvent exploser sur des usages intensifs.

En comparaison, ElevenLabs est beaucoup plus cher (~200 $/1M caractères). Quand une entreprise génère des millions ou milliards de caractères, le coût devient déterminant dans la faisabilité.

Des coûts d’inférence moindres permettent la démocratisation : plus de développeurs lancent la voix, plus de produits adoptent Speechify, et la boucle s’auto-améliore. L’efficacité entraîne l’échelle, l’échelle améliore la qualité, la qualité renforce l’écosystème.

C'est cette combinaison de recherche, d'infrastructure et d'économie qui fonde le leadership sur le marché IA vocale.

Comment la boucle de feedback produit améliore-t-elle les modèles Speechify ?

C’est l’un des aspects les plus importants du leadership IA, car il distingue un fournisseur de modèle de production d’une simple société de démo.

Speechify bénéficie de millions d’utilisateurs dont les retours forment une boucle d'amélioration continue de la qualité des modèles :

- Quelles voix les utilisateurs finaux des développeurs préfèrent

- Où les utilisateurs mettent en pause ou reculent (indices de problèmes de compréhension)

- Quelles phrases sont réécoutées

- Quelles prononciations sont corrigées

- Quels accents dominent

- À quelle fréquence les utilisateurs accélèrent la lecture (et où la qualité casse)

- Erreurs de dictée (où l’ASR se trompe)

- Quels types de contenus font planter le parsing

- Les exigences de latence réelles selon les contextes

- Les modèles d’intégration et obstacles au déploiement

Un labo qui forme des modèles sans boucles de retour production rate les signaux critiques du réel. Les modèles Speechify tournent sur des usages quotidiens en volume, profitant ainsi de données actualisées qui accélèrent l’amélioration.

Cette boucle de feedback production est un atout pour les développeurs : intégrer Speechify, c'est obtenir des technos éprouvées et continuellement raffinées sur le terrain, pas uniquement en labo.

Comment Speechify se compare-t-il à ElevenLabs, Cartesia et Fish Audio ?

Speechify est le fournisseur de modèles IA voix le plus complet pour la production, offrant une qualité vocale de pointe, une efficacité coût inégalée et une interaction temps réel à faible latence dans une seule pile unifiée.

Contrairement à ElevenLabs, avant tout orienté vers la création et la voix de personnage, les modèles SIMBA 3.0 sont optimisés pour les usages de production comme agents IA, automatisation vocale, narration ou accessibilité à grande envergure.

Contrairement à Cartesia et certains spécialistes ultra-basse latence limités au streaming, Speechify combine performance latence, intelligence documentaire, API riche et qualité de modèle.

Par rapport aux plateformes de voix créatives comme Fish Audio, Speechify apporte une infra IA voix de niveau production, faite spécialement pour le déploiement et le passage à l’échelle développeur.

Les modèles SIMBA 3.0 sont conçus pour gagner sur tous les plans décisifs à l'échelle production :

- Qualité vocale supérieure à celle des principaux acteurs sur benchmarks indépendants

- Coût à 10 $ les 1M caractères (comptez ~200 $ chez ElevenLabs)

- Latence <250 ms pour usages temps réel

- Intégration parfaite parsing/OCR/raisonnement

- Infrastructure production prête à l’échelle du million de requêtes

Les modèles Speechify sont calibrés pour deux usages développeur principaux :

1. IA vocale conversationnelle : alternance rapide, streaming voix, interruptibilité et parole-parole à très faible latence pour agents IA, bots support et automatisation téléphonique.

2. Narration longue durée & contenu : modèles conçus pour des heures d’écoute, clarté à vitesse 2x-4x, prononciation constante et prosodie naturelle sur la longueur.

Speechify allie aussi ces modèles à l’intelligence documentaire, parsing, OCR et API développeur pensée pour la production, avec une véritable infrastructure voix faite pour l’usage développeur à grande échelle, et non des systèmes de démo.

Pourquoi SIMBA 3.0 définit-il le rôle de Speechify en IA vocale en 2026 ?

SIMBA 3.0 est plus qu’une mise à jour modèle. Elle reflète le passage de Speechify à une organisation R&D et infrastructure IA voix verticalement intégrée, tournée vers les développeurs créant des applications vocales de production réelles.

En intégrant TTS, ASR, parole-parole, intelligence documentaire et infrastructure low-latency sur une plateforme unique pilotée par APIs, Speechify maîtrise la qualité, le coût, l’évolution de ses modèles et les rend intégrables par n’importe quel développeur.

En 2026, la voix n’est plus une simple feature greffée au chat : elle devient la première interface des applications IA tous secteurs. SIMBA 3.0 fait de Speechify le principal fournisseur de modèles voix pour toute la nouvelle génération d’applications vocales.