MoodMesh to firma technologiczna zajmująca się dobrym samopoczuciem, która pomaga użytkownikom śledzić, rozumieć i poprawiać swoje samopoczucie emocjonalne oraz dzielić się emocjami z partnerami i przyjaciółmi. Łącząc psychologię z nauką o danych, MoodMesh oferuje narzędzia, które umożliwiają użytkownikom identyfikację wzorców w ich zdrowiu psychicznym i podejmowanie proaktywnych kroków w kierunku równowagi emocjonalnej. To studium przypadku opisuje, jak MoodMesh zintegrował Speechify Text to Speechify API, aby uczynić opiekę emocjonalną bardziej intuicyjną i dostępną w każdej chwili, w każdym miejscu.

O MoodMesh

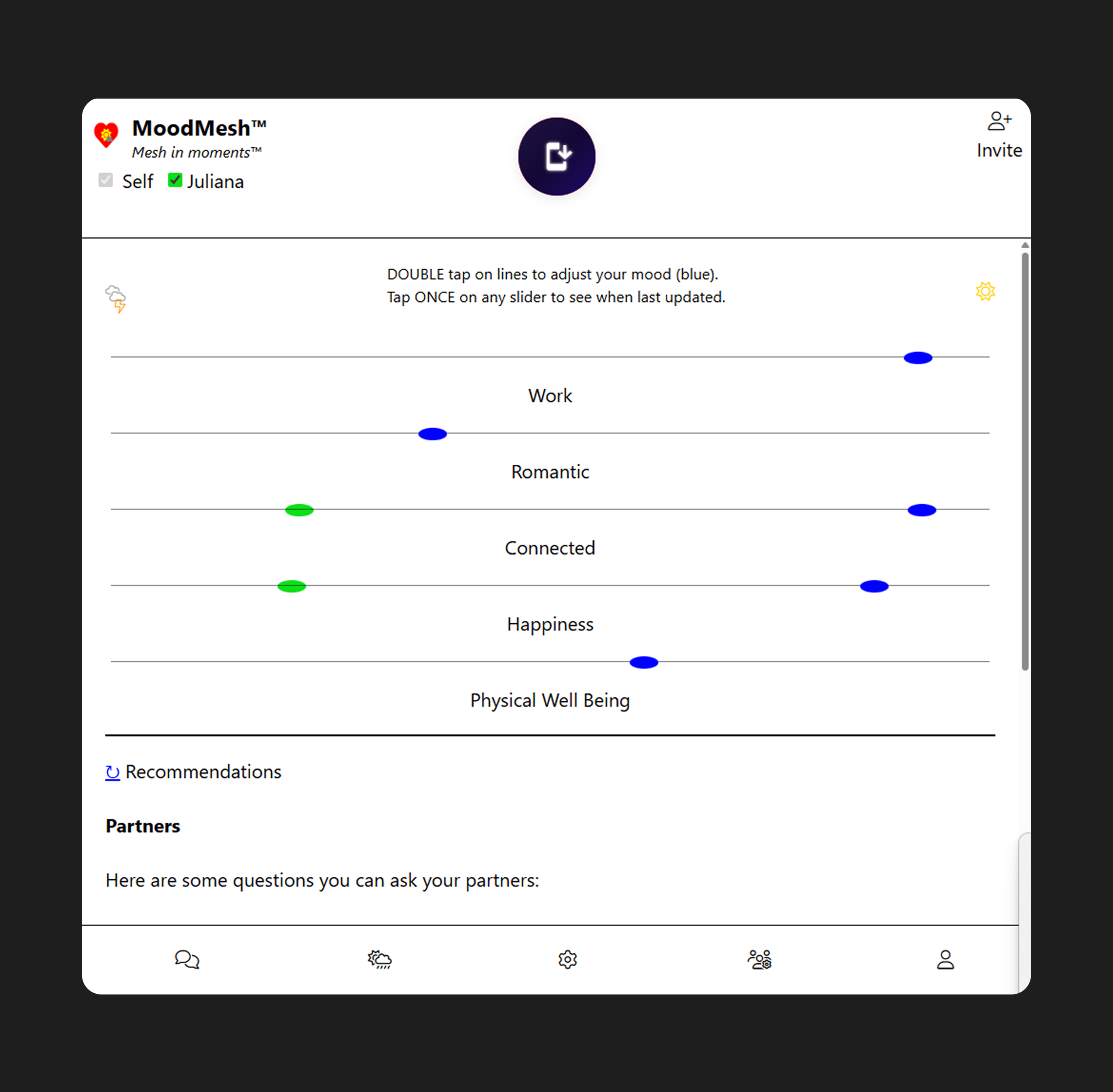

MoodMesh powstał z wspólnej wizji trzech przyjaciół—duetu pasjonującego się komunikacją emocjonalną i trzeciego, głęboko zaangażowanego w potencjał empatycznej AI. Co zaczęło się jako prosty fizyczny abakus, gdzie pozycja koralików reprezentowała stany emocjonalne w różnych aspektach życia, szybko przekształciło się w coś bardziej ambitnego. Po 18 miesiącach intensywnych badań nad empatią i emocjami w sztucznej inteligencji, zespół uruchomił aplikację internetową dostępną na urządzenia mobilne, która pozwala użytkownikom szybko śledzić i dzielić się swoimi nastrojami, jednocześnie otrzymując spersonalizowane porady komunikacyjne, wskazówki do prowadzenia dziennika, medytacje prowadzone i narzędzia do współczujących rozmów. Misja MoodMesh jest prosta, ale głęboka: pomóc ludziom łączyć się głębiej ze sobą i innymi poprzez technologię dostrojoną emocjonalnie.

Wyzwanie

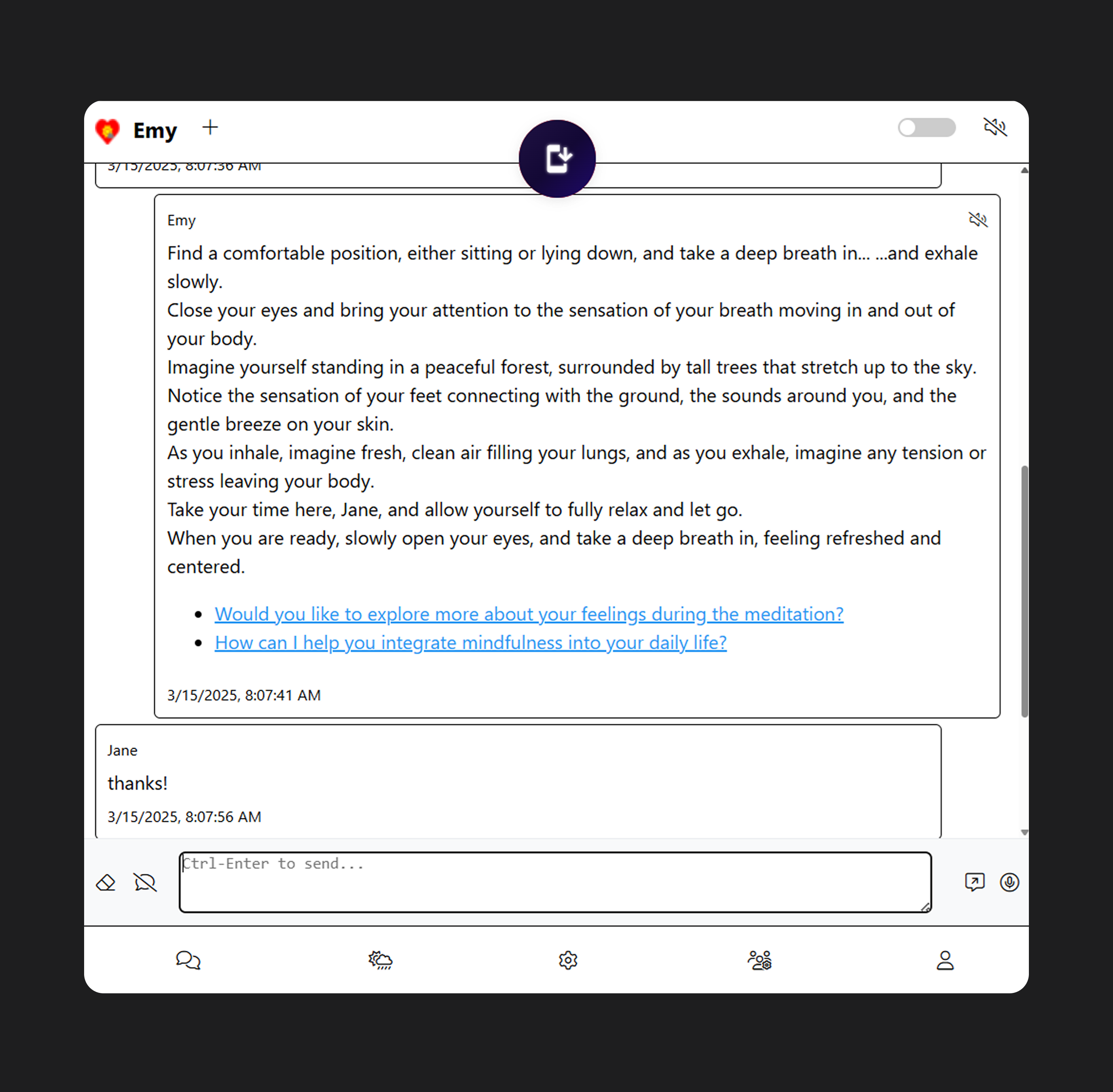

Cel MoodMesh, jakim jest wspieranie wglądu emocjonalnego i ludzkiego połączenia, stanowił unikalne wyzwanie techniczne. Wielu użytkowników zauważyło, że czytanie lub pisanie tekstu zakłóca ich przepływ emocjonalny. Szczególnie w przypadku medytacji, jednej z kluczowych funkcji MoodMesh, tekst na ekranie nie był immersyjny ani relaksujący. Tymczasem standardowe przeglądarkowe rozwiązania tekstu na mowę i mobilne SDK brakowały niuansów. Robotyczne lub płaskie audio mogło wręcz zmniejszać emocjonalny ton doświadczenia użytkownika. MoodMesh potrzebował rozwiązania, które mogłoby dostarczać mowę z emocjonalną autentycznością—coś, co byłoby w stanie dopasować ciepło i rytm prawdziwego ludzkiego głosu w czasie rzeczywistym, w różnych przypadkach użycia, od medytacji prowadzonej po pomoc w rozmowach terapeutycznych.

Rozwiązanie: Speechify Text to Speech API

Korzystając z Speechify Text to Speech API, MoodMesh może dostarczać mowę z emocjonalnymi niuansami, odpowiednim tonem, głośnością, tempem i szybkością zarówno dla medytacji, jak i współczujących rozmów. Dzięki solidnemu wsparciu SSML (Speech Synthesis Markup Language) i bogatej bibliotece głosów emocjonalnych, MoodMesh mógł wyjść poza mowę robotyczną i przejść do naprawdę ekspresyjnego przekazu głosowego. Integrując API Speechify, zespół był w stanie dostosować ton, tempo, głośność i szybkość mowy dla każdego przypadku użycia, tworząc znacznie bardziej emocjonalnie dopasowane doświadczenie dla użytkowników.

Ulubione funkcje Speechify w MoodMesh

Według zespołu MoodMesh, prostota, elastyczność, bezpieczeństwo i przystępność cenowa API Speechify Text to Speech wyróżniały się, ale wsparcie SSML było przełomowe. Wiele rozwiązań mowy w czasie rzeczywistym brakowało wystarczającej kontroli nad prozodią (intonacją i rytmem mowy), co skutkowało wyjściem głosowym, które wydawało się nienaturalne lub emocjonalnie nie na miejscu.

Ulepszenia SSML w API Speechify Text to Speech—including wsparcie dla tonów emocjonalnych, takich jak radosny, ciepły i jasny—pozwoliły MoodMesh dopasować przekaz głosowy do emocjonalnego kontekstu użytkownika. Oznaczało to, że nawet gdy użytkownicy czuli się przygnębieni, aplikacja mogła odpowiedzieć wspierającym, empatycznym tonem. API Speechify Text to Speech pozwoliło również MoodMesh zastosować różne emocje do różnych ofert, zamiast być ograniczonym do jednego tonu dla wszystkich doświadczeń słuchowych w aplikacji.

Wpływ partnerstwa MoodMesh i Speechify

Integracja API Speechify Text to Speech w MoodMesh znacząco zwiększyła zaangażowanie i satysfakcję użytkowników. Medytacje teraz są kojące i spersonalizowane. Sugestie rozmów są odczytywane tonem, który jest zgodny z emocjonalnymi potrzebami użytkownika, a nie narzucony przez domyślny głos. To emocjonalnie zgodne wsparcie audio pogłębiło zdolność aplikacji do obsługi użytkowników przechodzących przez stres, żałobę, lęk lub radość—tworząc znacznie bardziej ludzką interakcję cyfrową.

Podsumowanie

Wykorzystanie przez MoodMesh API Speechify z ulepszonym SSML to potężny przykład, jak emocjonalnie inteligentny design i technologia głosowa mogą się połączyć. Speechify Text to Speech API nie tylko dodało głos do MoodMesh—dodało właściwy głos, ciepły, dynamiczny i głęboko ludzki w tonie. Gdy MoodMesh nadal eksploruje przyszłość AI i empatii, Speechify pozostaje kluczowym partnerem w sprawianiu, by cyfrowa empatia była odczuwalna.

Aby dowiedzieć się więcej o tym, jak MoodMesh wykorzystuje AI do emocjonalnego dopasowania i lepszego łączenia się z innymi, odwiedź moodmesh.com.