Speechify объявляет о раннем запуске SIMBA 3.0 — своего новейшего поколения промышленных голосовых моделей AI, которые теперь доступны избранным сторонним разработчикам через Speechify Voice API. Полный публичный запуск запланирован на март 2026 года. Разработанная в AI-лаборатории Speechify, SIMBA 3.0 обеспечивает высококачественные возможности текст-в-речь, распознавания речи и голос-голос, которые разработчики могут напрямую встраивать в свои продукты и платформы.

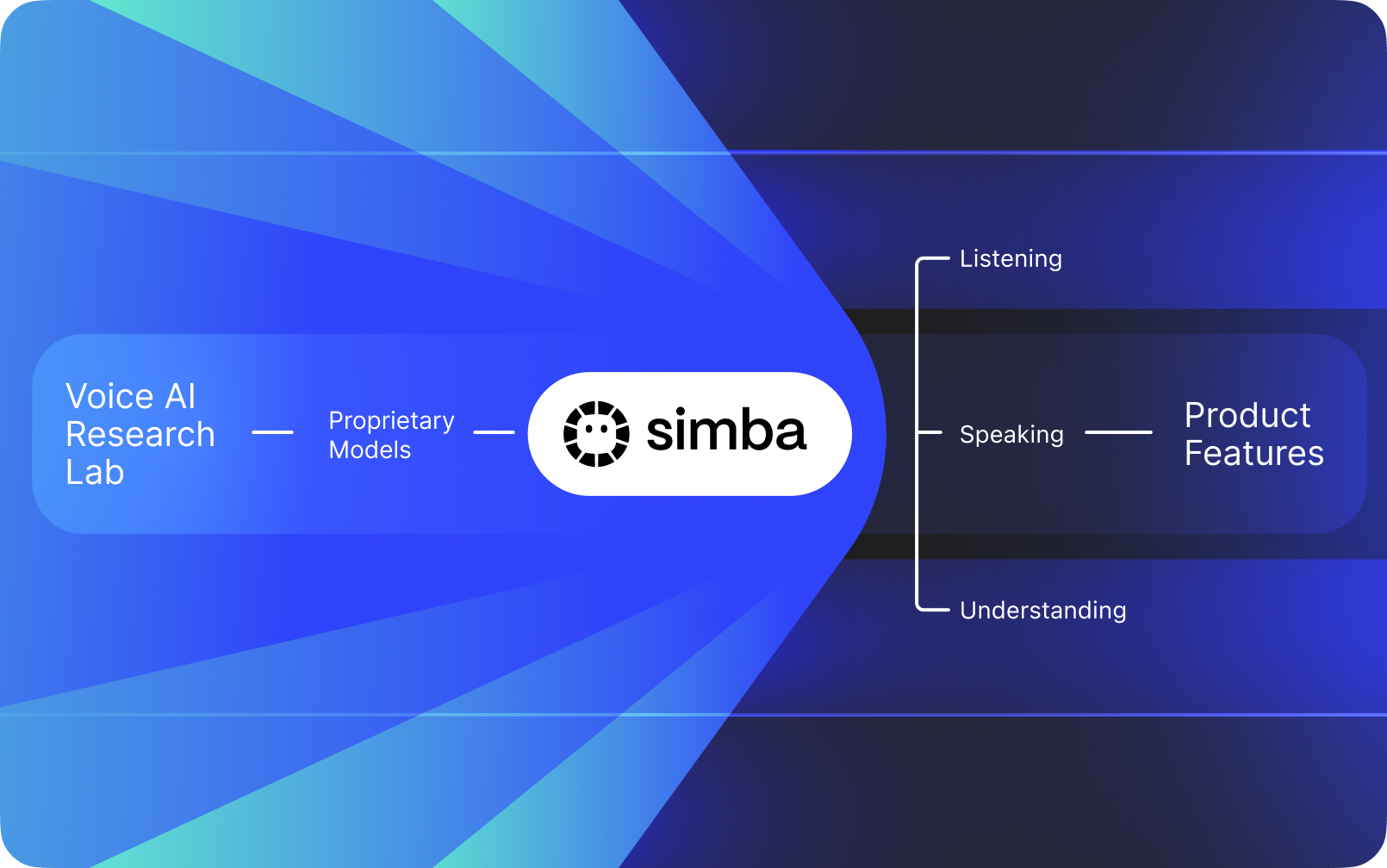

Speechify — это не просто голосовой интерфейс, построенный поверх чужих ИИ. У компании есть собственная AI-лаборатория, которая занимается созданием проприетарных голосовых моделей. Эти модели продаются сторонним разработчикам и компаниям через API Speechify для интеграции в любые приложения — от AI-ресепционистов и ботов поддержки до контент-платформ и инструментов доступности.

Speechify также использует эти же модели в своих пользовательских продуктах, одновременно предоставляя разработчикам доступ через Speechify Voice API. Это важно, потому что качество, задержка, стоимость и долгосрочное развитие голосовых моделей Speechify контролируются собственной исследовательской командой, а не внешними поставщиками.

Голосовые модели Speechify созданы специально для промышленных голосовых задач и обеспечивают лучшее качество модели в индустрии на больших масштабах. Сторонние разработчики получают доступ к SIMBA 3.0 и голосовым моделям Speechify напрямую через Speechify Voice API, с рабочими REST endpoint’ами, полной документацией API, краткими руководствами для быстрого старта и официально поддерживаемыми SDK для Python и TypeScript. Платформа для разработчиков Speechify создана для быстрой интеграции, развёртывания в продакшне и масштабируемой голосовой инфраструктуры, позволяя командам быстро перейти от первого API-запроса к живым голосовым функциям.

В этой статье объясняется, что такое SIMBA 3.0, что разрабатывает Speechify AI Research Lab и почему Speechify обеспечивает высочайшее качество голосовых AI-моделей, низкую задержку и выгодную экономику для промышленных задач разработчиков, делая компанию лидирующим поставщиком голосового AI и опережая других поставщиков голосовых и мультимодальных AI, таких как OpenAI, Gemini, Anthropic, ElevenLabs, Cartesia и Deepgram.

Что значит называть Speechify исследовательской AI-лабораторией?

Лаборатория искусственного интеллекта — это специализированная исследовательская и инженерная организация, где специалисты по машинному обучению, данным и вычислительному моделированию работают вместе над созданием, обучением и внедрением передовых интеллектуальных систем. Когда говорят «AI Research Lab», обычно имеют в виду организацию, которая делает две вещи одновременно:

1. Разрабатывает и обучает собственные модели

2. Предоставляет эти модели разработчикам через промышленные API и SDK

Некоторые организации создают отличные модели, но не дают к ним доступ внешним разработчикам. Другие предоставляют API, но в основном используют сторонние модели. Speechify работает по вертикально интегрированной модели голосового AI. Компания создаёт собственные голосовые AI-модели и предоставляет их сторонним разработчикам через промышленные API, одновременно используя их в своих пользовательских приложениях для проверки производительности на масштабе.

AI Research Lab Speechify — это собственная исследовательская организация, сфокусированная на голосовом интеллекте. Её миссия — продвигать технологии текст-в-речь, автоматического распознавания речи и голос-голос систем, чтобы разработчики могли создавать голосоориентированные приложения в любых сценариях — от AI-ресепционистов и голосовых агентов до движков для озвучивания и инструментов доступности.

Настоящей лаборатории по исследованию голосового AI обычно приходится решать задачи:

- Качество и естественность синтеза речи для развёртывания в промышленном масштабе

- Точность распознавания речи и ASR вне зависимости от акцента и шумовых условий

- Минимальная задержка в режиме реального времени для ведения беседы с ИИ-агентом

- Стабильность на длинных текстах для продолжительного прослушивания

- Понимание документов для обработки PDF-файлов, веб-страниц и структурированного контента

- OCR и парсинг страниц для сканированных документов и изображений

- Петля обратной связи от продукта, которая со временем улучшает модели

- Инфраструктура для разработчиков, обеспечивающая доступ к голосовым возможностям через API и SDK

AI Research Lab Speechify разрабатывает эти системы в единой архитектуре и делает их доступными для разработчиков через Speechify Voice API для сторонней интеграции на любой платформе или в любом приложении.

Что такое SIMBA 3.0?

SIMBA — это проприетарное семейство голосовых AI-моделей Speechify, которое одновременно используется в собственных продуктах Speechify и предлагается сторонним разработчикам через API. SIMBA 3.0 — новейшее поколение, оптимизированное для голосоориентированной производительности, скорости и взаимодействия в реальном времени, доступное сторонним разработчикам для интеграции в свои платформы.

SIMBA 3.0 создана для обеспечения премиального качества голоса, низкой задержки реакции и стабильности при длительных прослушиваниях в промышленных масштабах, позволяя разработчикам создавать профессиональные голосовые приложения для разных отраслей.

Для сторонних разработчиков SIMBA 3.0 открывает такие сценарии использования, как:

- Голосовые AI-агенты и разговорные AI-системы

- Автоматизация поддержки клиентов и голосовые ресепционисты AI

- Автоматические обзвонные системы для продаж и обслуживания

- Голосовые помощники и приложения голос-в-голос

- Озвучка контента и платформы генерации аудиокниг

- Инструменты доступности и ассистивные технологии

- Образовательные платформы с обучением через голос

- Медицинские приложения, требующие эмпатичных голосовых взаимодействий

- Многоязычные приложения для перевода и общения

- Голос-активируемые IoT-системы и автомобили

Когда пользователи говорят, что голос «звучит по-человечески», они имеют в виду сочетание следующих технических элементов:

- Просодия (ритм, высота, ударения)

- Смысловая паузация

- Естественные паузы

- Стабильное произношение

- Сдвиги интонации в соответствии с синтаксисом

- Эмоциональная нейтральность, когда это требуется

- Выразительность, когда это уместно

SIMBA 3.0 — уровень модели, который разработчики интегрируют, чтобы голосовой опыт был максимально естественным, даже при высокой скорости, длинных сессиях и разных типах контента. Для промышленных задач — от AI-телефонии до контент-платформ — SIMBA 3.0 оптимизирована для превосходства среди универсальных голосовых решений.

Как Speechify использует SSML для точного управления речью?

Speechify поддерживает язык разметки синтеза речи (SSML), чтобы разработчики могли точно контролировать, как будет звучать синтезированная речь. SSML позволяет настраивать высоту, темп, паузы, акценты и стиль с помощью тегов <speak> и дополнительных — prosody, break, emphasis и substitution. Это даёт командам тонкую настройку подачи и структуры, помогая голосовому выводу лучше соответствовать контексту, форматированию и намерению в промышленных приложениях.

Как Speechify реализует потоковое воспроизведение аудио в реальном времени?

Speechify предоставляет потоковый endpoint для синтеза речи, который выдаёт аудио порциями по мере его генерации, позволяя начать воспроизведение немедленно, не дожидаясь создания всего аудиофрагмента. Это поддерживает длинные форматы и сценарии с низкой задержкой — например, голосовые агенты, ассистивные технологии, автоматическая генерация подкастов и аудиокниг. Разработчики могут стримить большие входные данные за пределами стандартных лимитов и получать необработанные аудиочанки в форматах MP3, OGG, AAC и PCM для быстрой интеграции в системы реального времени.

Как в Speechify реализована синхронизация текста и аудио с помощью speech marks?

Speech marks отображают произнесённое аудио на исходный текст с пословной разметкой времени. Каждый ответ включает синхронизированные фрагменты текста с указанием, когда каждое слово начинается и заканчивается в аудиопотоке. Это позволяет реализовать подсветку текста в реальном времени, точный переход по словам и фразам, аналитику использования и плотную синхронизацию текста на экране и аудиовоспроизведения. Разработчики могут использовать этот механизм для создания доступных ридеров, учебных инструментов и интерактивного прослушивания.

Как Speechify поддерживает эмоциональную выразительность в синтезированной речи?

В Speechify имеется контроль эмоций с помощью специального SSML-тега, который позволяет задавать эмоциональный тон озвучке. Среди поддерживаемых эмоций — радость, спокойствие, напористость, энергичность, грусть и злость. Комбинируя теги эмоций с пунктуацией и другими SSML-элементами, разработчики могут добиваться лучшего соответствия речи контексту и намерению. Это особенно полезно для голосовых агентов, wellness-приложений, поддержки клиентов и контента, где тональность напрямую влияет на пользовательский опыт.

Реальные сценарии использования голосовых моделей Speechify для разработчиков

Голосовые модели Speechify используются в промышленных приложениях в разных отраслях. Вот реальные примеры того, как сторонние разработчики используют Speechify API:

MoodMesh: Приложения для благополучия с эмоциональным интеллектом

MoodMesh, компания в области wellness-технологий, интегрировала Speechify Text-to-Speech API для создания эмоционально окрашенной речи для медитаций и сочувственных разговоров. Используя SSML и контроль эмоций, MoodMesh подбирает тон, ритм, громкость и скорость речи под эмоциональный контекст пользователя, формируя по-настоящему человечное взаимодействие — такого стандартный TTS дать не может. Это пример того, как разработчики используют Speechify модели для сложных задач, где нужна эмоциональная чуткость и понимание контекста.

AnyLingo: Многоязычное общение и перевод

AnyLingo, приложение-мессенджер для перевода в реальном времени, использует API клонирования голоса Speechify, чтобы пользователи могли отправлять голосовые сообщения клоном своего собственного голоса на языке получателя с нужными интонациями, тоном и контекстом. Это помогает бизнесу общаться между языками, сохраняя личную интонацию. Основатель AnyLingo отмечает, что функция управления эмоциями Speechify (“Moods”) — важное отличие, позволяющее подбирать нужную интонацию для любых ситуаций.

Прочие сценарии работы для сторонних разработчиков:

Разговорный AI и голосовые агенты

Разработчики, создающие AI-ресепционистов, ботов поддержки и системы автоматизации продаж, используют низкозадержанные голос-в-голос модели Speechify для создания естественного голосового взаимодействия. С задержкой ниже 250 мс и функциями клонирования голоса эти приложения масштабируются до миллионов звонков, сохраняя качество голоса и естественность беседы.

Контент-платформы и генерация аудиокниг

Издатели, авторы и образовательные платформы интегрируют модели Speechify для конвертации текста в качественную озвучку. Оптимизация моделей для длинных сессий и высокой чёткости на высокой скорости делает их идеальными для создания аудиокниг, подкастов и образовательных материалов в масштабе.

Доступность и ассистивные технологии

Разработчики, создающие инструменты для слабовидящих или людей с дислексией, полагаются на возможности распознавания документа Speechify: парсинг PDF, OCR, выделение веб-страниц, чтобы голосовой вывод сохранял структуру и смысл даже в сложных документах.

Медицина и терапия

Медицинские платформы и терапевтические приложения используют контроль эмоций и настройку просодии в Speechify для создания эмпатичных, контекстно уместных голосовых взаимодействий — это критически важно для общения с пациентами, поддержки психического здоровья и wellness-приложений.

Как SIMBA 3.0 показывает себя на независимых лидербордах голосовых моделей?

Независимый бенчмаркинг имеет большое значение в голосовом AI, потому что короткие демо могут скрывать проблемы производительности. Один из самых известных сторонних бенчмарков — лидерборд Artificial Analysis Speech Arena, который оценивает модели текст-в-речь на основе массовых слепых сравнений прослушивания и системы ELO-скоринга.

Голосовые модели SIMBA от Speechify занимают места выше многих крупных поставщиков на лидерборде Artificial Analysis Speech Arena, включая Microsoft Azure Neural, модели Google TTS, Amazon Polly, NVIDIA Magpie и другие открытые голосовые системы.

Вместо обращения к тщательно отобранным примерам Artificial Analysis использует многократные парные предпочтения слушателей по огромному числу образцов. Этот рейтинг подтверждает, что SIMBA превосходит даже коммерческие голосовые системы по качеству моделей в реальных тестах, делая её лучшим выбором для разработчиков, строящих голосовые приложения для продакшна.

Почему Speechify создаёт собственные голосовые модели вместо использования сторонних систем?

Контроль над моделью — это контроль над:

- Качеством

- Задержкой

- Стоимостью

- Дорожной картой

- Приоритетами оптимизации

Когда компании, такие как Retell или Vapi.ai, полностью зависят от сторонних голосовых платформ, они фактически перенимают их цену, ограничения инфраструктуры и направление исследований.

Владея всем стеком, Speechify может:

- Тонко настраивать просодию под задачи (AI-диалог против длинных начиток)

- Оптимизировать задержку ниже 250 мс для задач в реальном времени

- Интегрировать ASR и TTS в единую голос-в-голос цепочку

- Снизить стоимость до $10 за 1 млн символов (против $200 за 1 млн у ElevenLabs)

- Выпускать улучшения моделей по фидбеку продакшн-пользователей

- Выравнивать развитие моделей под нужды разработчиков в разных индустриях

Такой полный контроль над стеком позволяет Speechify обеспечивать более высокое качество моделей, меньшую задержку и лучшую эффективность расходов, чем голосовые решения, зависящие от сторонних API. Это критически важно для разработчиков, масштабирующих голосовые приложения. И те же преимущества получает сторонний бизнес, интегрируя Speechify API в свой продукт.

Инфраструктура Speechify изначально построена вокруг голоса, а не как слой, наложенный на систему для чата. Разработчики, интегрирующие модели Speechify, получают доступ к архитектуре, которая с нуля оптимизирована для промышленного развёртывания голосовых возможностей.

Как Speechify поддерживает локальный голосовой ИИ и инференс на устройстве?

Многие голосовые AI-системы работают только через удалённые API, что создаёт зависимость от сети, повышает риск задержек и ограничивает приватность. Speechify предлагает опции локального/на устройстве инференса для отдельных голосовых задач, позволяя развернуть голосовой опыт ближе к пользователю там, где это необходимо.

Поскольку Speechify разрабатывает собственные голосовые модели, компания может оптимизировать размер моделей, архитектуру сервинга и методы инференса для выполнения на устройстве, а не только в облаке.

Локальный/на устройстве инференс обеспечивает:

- Более низкую и стабильную задержку при нестабильной сети

- Улучшенную приватность для конфиденциальных документов и диктовки

- Работу в оффлайн-режиме или при плохой сети

- Гибкость внедрения для корпоративных или встраиваемых решений

Это расширяет возможности Speechify — от «голос только по API» к инфраструктуре, которую можно развёртывать в облаке, локально и на устройстве, сохраняя стандарт модели SIMBA.

Чем Speechify отличается от Deepgram в ASR и голосовой инфраструктуре?

Deepgram — это инфраструктурный провайдер ASR, фокусирующийся на API для транскрипции и анализа речи. Его основной продукт выдаёт текстовый результат для задач транскрибации и анализа звонков.

Speechify интегрирует ASR во всё семейство голосовых моделей, где распознавание речи может сразу породить разные выходы: от чернового текста до готовых текстов и диалоговых ответов. Разработчики, использующие Speechify API, имеют доступ к моделям ASR, оптимизированным не только для точности транскрибации, но и для различных практических задач.

ASR и диктовочные модели Speechify оптимизированы для:

- Качества выходного текста с пунктуацией и абзацами

- Удаления слов-паразитов и форматирования предложений

- Чернового текста для писем, документов и заметок

- Голосового ввода с минимумом постобработки

- Интеграции в голосовые workflows (TTS, диалоги, reasoning)

На платформе Speechify ASR соединяется со всей голосовой цепочкой. Разработчики могут создавать приложения: пользователь диктует, получает структурированный текст, генерирует аудиоответ и ведёт диалог — всё через единый API. Это снижает сложность интеграции и ускоряет разработку.

Deepgram — это слой транскрибации. Speechify — полный пакет голосовых моделей: вход, структурированный вывод, синтез, reasoning и генерация аудио с едиными API и SDK для разработчиков.

Для разработчиков, строящих голосовые приложения с полным циклом, Speechify — один из самых сильных вариантов по качеству моделей, задержке и глубине интеграции.

Чем Speechify отличается от OpenAI, Gemini и Anthropic в области голосового AI?

Speechify создаёт голосовые AI-модели, оптимизированные именно под голосовое взаимодействие в реальном времени, синтез в промышленных масштабах и сценарии распознавания речи. Базовые модели изначально нацелены на голос, а не на чат или текстовое взаимодействие.

Специализация Speechify — разработка голосовых моделей AI, а SIMBA 3.0 специально оптимизирована под качество голоса, низкую задержку и стабильность при длительных нагрузках в реальном продакшне. SIMBA 3.0 создана для обеспечения промышленного качества моделей и быстрого голосового взаимодействия — всё это легко интегрируется разработчиками в свои приложения.

Универсальные AI-лаборатории, такие как OpenAI и Google Gemini, оптимизируют свои модели для широкого класса задач: рассуждение, мультимодальность, общий интеллект. Anthropic делает акцент на безопасности reasoning’a и длинном контексте. Их голосовые функции — просто расширение чатов, а не отдельные голосовые платформы.

В голосовом AI приоритет — качество модели, задержка и устойчивость на длинных сессиях, а не широта возможностей reasoning’a — и здесь специализированные голосовые модели Speechify превосходят универсальные системы. Разработчики, создающие ИИ-телефонию, голосовых агентов, платформы озвучки или доступности, нуждаются в голосоориентированных моделях, а не в голосовом слое поверх чат-ИИ.

ChatGPT и Gemini предлагают голосовые режимы, но их основной интерфейс по-прежнему текстовый. Голос — лишь слой ввода-вывода поверх чата. Такие голосовые слои не оптимизированы для продолжительного качества прослушивания, точности диктовки или работы в реальном времени.

Speechify — изначально голосовая модель, и разработчики могут работать с моделями, настроенными для непрерывных голосовых сценариев, без необходимости смены режима и компромиссов в качестве. Speechify API предоставляет эти возможности прямо через REST endpoint’ы и SDK для Python и TypeScript.

Таким образом, Speechify становится ведущим провайдером голосовых моделей для разработчиков, создающих голосовые приложения и системы взаимодействия в реальном времени.

В задачах голосового AI SIMBA 3.0 оптимизирована для:

- Просодии для длинных текстов и контента

- Минимальной задержки голос-голос для разговорных AI-агентов

- Качества диктовки для голосового ввода и транскрибации

- Голосового взаимодействия с учётом структуры документов

Эти возможности делают Speechify AI-провайдером голосовых моделей, оптимизированных для интеграции разработчиками и запуска в продакшне.

Каковы основные технические столпы AI Research Lab от Speechify?

AI Research Lab Speechify организована вокруг базовых технических систем для построения промышленной voice-AI-инфраструктуры для разработчиков. Лаборатория разрабатывает ключевые компоненты моделей для комплексного развёртывания голосового ИИ:

- Модели TTS (синтез речи) — доступны через API

- STT & ASR-модели (распознавание речи) — интегрированы в голосовую платформу

- Голос-голос (реальные разговорные пайплайны) — низкозадержанная архитектура

- Парсинг страниц и понимание документов — для обработки сложных документов

- OCR (распознавание текста на изображениях) — для сканированных документов и картинок

- Разговорные слои на базе LLM — для интеллектуальных голосовых взаимодействий

- Инфраструктура с низкой задержкой — ответы быстрее 250 мс

- Инструменты API и оптимизация расходов — SDK для продакшна

Каждый слой оптимизирован под промышленные голосовые задачи, а вертикально интегрированный стек моделей Speechify поддерживает высокое качество и низкую задержку на всём пути обработки речи в масштабе. Интеграция этих моделей обеспечивает разработчикам целостную архитектуру, а не «кустарную сборку» из разрозненных сервисов.

Значение имеет каждый слой. Если хотя бы один слабый, общее голосовое взаимодействие страдает. Speechify обеспечивает разработчикам полноценную голосовую инфраструктуру, а не просто отдельные endpoints.

Какую роль играют STT и ASR в AI Research Lab Speechify?

Speech-to-text (STT) и автоматическое распознавание речи (ASR) — ключевые семейства моделей в портфеле исследований Speechify. Они обеспечивают такие кейсы для разработчиков, как:

- Голосовой ввод и диктовку через API

- Реальные диалоги с AI и голосовые агенты

- Анализ и транскрибация встреч

- Голос-голос пайплайны для AI-телефонии

- Многоходовые диалоги для ботов поддержки

В отличие от обычных инструментов транскрибации, голосовые модели Speechify по API оптимизированы для чистого текстового результата. Они:

- Ставят пунктуацию автоматически

- Интеллектуально формируют абзацы

- Убирают слова-паразиты

- Повышают понятность для дальнейшей обработки

- Поддерживают сценарии записи в разных приложениях и на разных платформах

Это отличает Speechify от корпоративных систем транскрипции, фокусирующихся только на захвате текста. ASR-модели Speechify нацелены на высокое качество и удобство дальнейшей работы, чтобы голосовой ввод сразу превращался в черновой текст, а не требовал много ручной доработки — что критично для инструментов продуктивности, голосовых ассистентов и AI-агентов.

Что делает TTS «высококачественным» для производства?

Большинство людей оценивают качество TTS по тому, насколько он звучит по-человечески. Но для разработчиков важно, как он ведёт себя в масштабе, на разном контенте и в условиях реального мира.

Высокое качество TTS для продакшна требует:

- Чёткости на высокой скорости для продуктивности и доступности

- Минимальных искажений при ускоренном воспроизведении

- Стабильности произношения терминов и специальной лексики

- Комфорта при прослушивании долгих сессий

- Контроля скорости, пауз и акцентов через SSML

- Мультиязычности и поддержки разных акцентов

- Постоянства голоса на протяжении часов звучания

- Поточного режима для приложений в реальном времени

Модели TTS от Speechify обучены для устойчивой работы на длинных сессиях и в боевых условиях, а не только на демо-образцах. Модели, доступные через API, специально созданы для надёжности при длительном времени воспроизведения и разборчивости на высокой скорости в реальных задачах разработчиков.

Разработчики могут сами протестировать качество голоса, воспользовавшись руководством по быстрому старту Speechify и прогнав свой контент через боевые голосовые модели.

Почему парсинг страниц и OCR — это основа голосовых AI-моделей Speechify?

Многие AI-команды сравнивают OCR и мультимодальные модели по сырому распознаванию, скорости на GPU или JSON-выводам. Speechify — лидер в голосовом понимании документов: извлекает чистый, упорядоченный контент так, чтобы голосовой вывод сохранял структуру и смысл.

Парсинг страниц гарантирует, что PDF, веб-страницы, Google Docs и презентации превращаются в чистый, логически последовательный поток чтения. Вместо озвучки меню навигации, дублирующихся заголовков или сломанной вёрстки Speechify выделяет только главный контент, чтобы речь оставалась связной.

OCR гарантирует, что сканированные документы, скриншоты и основанные на изображениях PDF становятся читаемыми и доступны для поиска до начала синтеза речи. Без этого слоя целые категории документов были бы недоступны для голосовых систем.

В этом смысле парсинг страниц и OCR — фундаментальные направления исследований лаборатории AI Speechify, позволяющие разработчикам строить голосовой софт, который понимает документы до озвучки. Это критично для инструментов озвучки, доступности, систем обработки документов или любого приложения, которому нужно достоверно воспроизводить сложные тексты.

Какие TTS-бенчмарки критичны для голосовых моделей продакшна?

В оценке голосовых AI часто используются такие бенчмарки:

- MOS (средняя субъективная оценка естественности)

- Показатели разборчивости (насколько легко понять речь)

- Точность произношения терминов и специальной лексики

- Стабильность на длинных отрывках (нет дрейфа голоса)

- Задержка (время до первого аудио, потоковая работа)

- Надёжность на разных языках и акцентах

- Экономичность на масштабе

Speechify бенчмаркет модели на основе реального продакшна:

- Как голос ведёт себя на скорости 2x, 3x, 4x?

- Остаётся ли комфорт при озвучке сложных технических текстов?

- Справляется ли с аббревиатурами, цитатами и структурированными документами?

- Сохраняется ли структура абзацев в аудиовыводе?

- Может ли стримить аудио в реальном времени с минимальной задержкой?

- Выгодно ли для приложений с миллионами символов в день?

Главный экзамен — устойчивая производительность и работа в реальном времени, а не краткое voiceover-демо. Во всех этих сценариях SIMBA 3.0 спроектирована быть лидером на масштабах реальных задач.

Независимые бенчмарки подтверждают такой профиль. В Artificial Analysis Text-to-Speech Arena SIMBA от Speechify стоит выше моделей Microsoft Azure, Google, Amazon Polly, NVIDIA и многих открытых голосовых систем. Такие слушательские сравнения измеряют реальное качество восприятия, а не демонстрационную нарезку.

Что такое голос-в-голос и почему это ключевая возможность для разработчиков?

Голос-в-голос — это когда пользователь говорит, система понимает и отвечает в аудио, желательно в реальном времени. Это ядро настоящих conversational voice AI, которые создаются для AI-ресепционистов, поддержки, голосовых ассистентов, телефонии и не только.

Система голос-в-голос требует:

- Быстрого ASR (распознавания речи)

- Reasoning-системы для поддержания беседы

- Быстрого потокового TTS

- Логики «смены хода» (когда говорить, когда слушать)

- Возможности прерывания (barge-in)

- Человеческой задержки (до 250 мс)

Голос-в-голос — это ключевая область исследований в AI Research Lab Speechify, потому что эта задача не решается одной моделью. Требуется чёткая интеграция распознавания, reasoning’а, генерации ответа, синтеза речи, стриминговой инфраструктуры и управления режимом «слушаю/говорю» в реальном времени.

Разработчики разговорных AI-приложений выигрывают от интегрированного подхода Speechify: им не нужно сшивать отдельные сервисы ASR, reasoning и TTS — доступен единый голосовой стек для взаимодействия в реальном времени.

Почему важна задержка ниже 250 мс для приложений?

В голосовых системах задержка определяет, насколько естественным ощущается взаимодействие. Разработчикам разговорных AI нужны модели, которые могут:

- Начинать отвечать быстро

- Плавно стримить речь

- Обрабатывать прерывания

- Сохранять темп диалога

Speechify обеспечивает задержку ниже 250 мс и продолжает её снижать. Инфраструктура сервинга и инференса моделей рассчитана на быстрый отклик в реальном диалоге на постоянной основе.

Низкая задержка критична для таких задач:

- Натурального голос-в-голос взаимодействия в AI-телефонии

- Реального понимания контента у голосовых помощников

- Прерываемого диалога с ботами поддержки

- Бесшовного ведения диалога у AI-агентов

Это ключевая черта продвинутых провайдеров голосового AI — и причина, по которой разработчики выбирают Speechify для масштабных внедрений.

Что значит «поставщик голосовых AI-моделей»?

Поставщик голосовых AI-моделей — это не просто генератор речи. Это исследовательская и инфраструктурная платформа, предлагающая:

- Готовые к продакшну голосовые модели через API

- Синтез речи (текст-в-речь) для генерации контента

- Распознавание речи (речь-в-текст) для голосового ввода

- Пайплайны голос-в-голос для AI-диалогов

- Интеллект для обработки сложных документов

- API/SDK для разработчиков для интеграции

- Стриминг для работы в реальном времени

- Клонирование голоса для персонализации

- Экономичное ценообразование для масштабных внедрений

Speechify прошёл путь от внутренней голосовой технологии до полноценного поставщика моделей, которые разработчики могут встроить в любое приложение. Это важно, так как объясняет, почему Speechify — реальная альтернатива универсальным AI в задачах голоса, а не просто потребительское приложение с API.

Разработчики могут получить доступ к голосовым моделям Speechify через Voice API Speechify: полная документация, Python и TypeScript SDK, инфраструктура для масштабного запуска голосовых функций.

Как Voice API Speechify способствует массовому принятию среди разработчиков?

Лидерство AI Research Lab подтверждается тем, что разработчики могут напрямую работать с технологией через готовые API. Voice API Speechify даёт:

- Доступ к SIMBA-моделям Speechify через REST endpoint’ы

- Python и TypeScript SDK для быстрой интеграции

- Понятный путь интеграции — от стартапа до корпорации — без собственного обучения моделей

- Полную документацию и гайды для быстрого старта

- Стриминговую поддержку реального времени

- Возможность клонирования голоса для персонализации

- Поддержку 60+ языков для глобальных решений

- SSML и управление эмоциями для точной передачи интонаций

Экономичность здесь критична: $10 за 1 млн символов в тарифе pay-as-you-go, а для крупных объёмов — корпоративные условия. Это делает Speechify выгодным для сценариев с огромным трафиком.

Для сравнения, ElevenLabs стоит гораздо дороже (примерно $200 за 1 млн символов). Когда бизнес генерирует миллионы или миллиарды символов, стоимость определяет жизнеспособность функции.

Более низкая стоимость инференса позволяет шире внедрять технологию: больше разработчиков могут выпускать голосовые функции, больше продуктов используют модели Speechify, а обратная связь ускоряет улучшение моделей. Работает замкнутый круг: экономия — масштаб — качество — рост экосистемы.

Именно сочетание исследований, инфраструктуры и экономики определяет лидерство на рынке голосовых AI-моделей.

Как цикл продуктовой обратной связи улучшает модели Speechify?

Это один из важнейших аспектов лидерства AI-lab, ведь именно он отличает настоящего поставщика промышленных моделей от демо-компании.

Масштаб внедрения Speechify среди миллионов пользователей обеспечивает цикл обратной связи, который постоянно улучшает качество моделей:

- Какие голоса предпочитают конечные пользователи разработчиков

- Где пользователи делают паузы/перематывают (сигнал проблем понимания)

- Какие предложения переслушивают

- Какие произношения исправляют

- Какие акценты ценят

- Где ускоряют скорость (и где пропадает качество)

- Коррекции диктовок — где ASR делает ошибки

- Ошибки разбора на контенте

- Реальные требования к задержке в разных задачах

- Паттерны развёртывания и интеграционные проблемы

Лаборатория, обучающая модели без продакшн-фидбека, упускает ключевые сигналы реального использования. А модели Speechify работают в боевых приложениях, ежедневно обрабатывая миллионы голосовых взаимодействий — значит, постоянно получают данные для ускорения улучшений.

Такой цикл инкрементальных улучшений — конкурентное преимущество для разработчиков: интегрируя модели Speechify, вы получаете технологию, закалённую и постоянно дорабатываемую в реальных условиях, а не только в лаборатории.

Чем Speechify отличается от ElevenLabs, Cartesia и Fish Audio?

Speechify — один из сильнейших провайдеров голосовых AI-моделей для продакшн-разработчиков: наивысшее качество, экономичность и низкая задержка в едином стеке моделей.

В отличие от ElevenLabs, ориентированного на генерацию персонажей и креаторов, SIMBA 3.0 Speechify оптимизирована именно под потребности разработчиков: AI-агенты, голосовая автоматизация, платформы озвучки и системы доступности на большом масштабе.

В отличие от Cartesia и других ультрабыстрых решений, заточенных только под стриминг, Speechify совмещает скорость с полнотой голосового стека, анализом документов и удобной интеграцией для разработчиков.

По сравнению с платформами для креаторов, такими как Fish Audio, Speechify — это инфраструктура для разработки масштабных, надёжных голосовых AI-систем.

SIMBA 3.0 оптимизирована побеждать по всем критериям, важным на масштабе:

- Качество голоса выше, чем у ключевых лидеров на независимых бенчмарках

- Экономичность: $10 за 1 млн символов (у ElevenLabs — ~$200)

- Задержка ниже 250 мс для real-time приложений

- Интеграция парсинга документов, OCR и reasoning

- Готовая инфраструктура для масштабирования до миллионов запросов

Голосовые модели Speechify заточены под два типа разработки:

1. Разговорный Voice AI: быстрые очереди реплик, потоковая речь, прерывание и низкая задержка для AI-ботов, поддержки, телефонных диалогов.

2. Длинная озвучка и контент: модели для комфортного прослушивания в течение часов, чёткость на скорости до 4x, стабильное произношение, просодия для длинных сессий.

Speechify сочетает модели с анализом документов, парсингом, OCR и API для запуска в продакшне. Результат — голосовая инфраструктура, которую разрабатывают для масштабных внедрений, а не для демо.

Почему SIMBA 3.0 формирует роль Speechify в голосовом AI в 2026 году?

SIMBA 3.0 — не просто обновление модели. Это отражение эволюции Speechify в вертикально интегрированную организацию исследований и инфраструктуры голосового AI, ориентированную на помощь разработчикам в создании промышленных голосовых приложений.

Интегрируя проприетарные TTS, ASR, голос-голос, анализ документов и низкозадержанную инфраструктуру в единую платформу с API для разработчиков, Speechify контролирует качество, стоимость и развитие голосовых моделей, делая их доступными для разработчиков по всему миру.

В 2026 году голос — уже не просто функция в чате. Это ключевой способ взаимодействия с AI-приложениями в разных отраслях. SIMBA 3.0 делает Speechify ведущим провайдером моделей для разработчиков, создающих новое поколение голосовых решений.